持续交付36讲

开篇词 量身定制你的持续交付体系

你好,我是王潇俊,从今天开始,我将会和你一起聊聊“持续交付”这个话题。

“持续交付”已不再是一个陌生词汇了,绝大多数软件研发企业,都在或多或少地实施“持续交付”,因为大家都清楚,也都曾经体会或者听别人说过,“持续交付”能够提高研发效率。 但是要说实施得多好、多彻底,那我估计很多人都会面面相觑。

做好持续交付并不是件易事,从我的经验来看,它主要难在三个地方。

第一,实施“持续交付”,将会影响整个的研发生命周期,会涉及到流程、团队、工具等多个方面。很可能需要突破当前组织的束缚,引起大量的技术和组织变革。因为,实施“持续交付”需要组织从上到下的认可,需要有大勇气将一些可能属于黑箱操作的工作,公开出来给大家监督。所以,这样的事情很难推进。

第二,实施“持续交付”,对实施者和参与者的要求都很高,他们不仅需要了解开发,还要了解流程,了解测试,了解运维,甚至还需要有一定的架构知识和管理知识。所以,这样的人才很难寻找。

第三,实施“持续交付”,大多数团队都希望能够快速见效,立竿见影。但是,“持续交付”的改进过程本身就是一个持续迭代的过程,需要多次循环才能体现效果。甚至在实施的初期,因为开发习惯和流程变化,团队在适应的过程中效率会有暂时的下降。所以,这样的效果很难度量。

由于这三大难点,很多人对“持续交付”敬而远之,或者爱恨交加。因此,我希望这个专栏能够带你全面、立体地认识持续交付,当你了解得越多,理解得越透彻,你也就越有信心。简单来说,我认为:

无论企业在什么阶段,无论个人的能力如何,都可以去尝试“持续交付”。

在实践中,我还经常看到一些错误的观点。

- 过度强调自动化。认为只有自动化才能算是“持续”,但限于业务逻辑变化快,QA 能力不足等,又无法实现测试自动化,而发布自动化更是遥遥无期,所以只能放弃。

- 过度强调流程化。总觉得“持续交付”先要构建强流程来管控,结果就一直限于流程和实现流程的“泥潭”里,却忘了初衷。

- 过度强调特殊化。比如我们经常会听到,我们的工程师能力特别强,我们的团队有特殊的工作方式,我们的系统有不同的设计,这些往往成了拒绝“持续交付”的借口。

希望在这个专栏里,通过我的讲解能够纠正你的这些错误观点。

同时,我也希望和你之间不是教与学的关系,而是切磋与讨论,在这三个月的时间里,我们一起讨论如何解决现实的问题,讨论如何进一步去做好“持续交付”,讨论那些超出你我边界的所谓的“难题”。

自从决定写这个专栏,我就一直在脑子里“翻箱倒柜”,在网络上收集相关参考资料,整理写作材料。突然,我脑子里蹦出一个问题:我自己当年是怎么接触到持续交付的,是怎么走上“持续”这条“不归路”的?

仔细回想一下,接触“持续集成”这个概念其实是挺早的事情了。那时我在第九城市负责用户中心的开发,有些与《魔兽世界》相关的功能需要大洋彼岸的老美同学(QA)进行验收。因此,为了利用时差优势,我们如果有新功能要测试,就会要求整个团队在当天下午冻结代码版本,并在 6 点后向测试环境发布。

晚上我们睡觉的时候,老美们就开始干活了。因为《魔兽世界》的爆红,所以当时开发需求特别多,缺陷也特别多,几乎每天都要提测,我就干脆用按键精灵写了个脚本,实现了每天自动地处理这些事情。现在想想,这不就是每日构建嘛。

你现在可能和当时的我一样,正在采用或借鉴一些“持续集成”或“持续交付”的最佳实践,但还停留在一个个小的、零散的点上,并没有形成统一的体系,还搞不定持续交付。

所以,我希望这个专栏首先能够给你呈现一个体系化的“持续交付”课程,帮助你拓展高度和广度,形成对“持续交付”立体的认识。

其实从这个角度来看,我想通过这个专栏与你分享的内容,不正好就是我自己在实际成长过程中一点一点学到的东西吗?那么,如果你不嫌厌烦,可以继续听一下我的故事。

离开第九城市之后,由于经受不住帝都“干燥”的天气,2008 年我又回到魔都,加入了当时还默默无闻的大众点评网。在那里,我真正体验了一把“坐火箭”的感觉;也是在那里,我与“持续交付”真正结缘。

点评是一家工程师文化很浓重的公司,一直以来都以工程师的能力为傲。但随着 O2O 和移动互联网的兴起,点评走到了风口浪尖,团队在不断扩大,而研发效率开始下降了。

起初,大家都觉得是自己的能力跟不上,就开始拼命学习,公司也开始树立专家典型。但结果却事与愿违,个人越牛,杂事越多,不能专注,反而成了瓶颈。总结之后,我们发现,这种情况是研发流程、合作方式等低效造成的。个人再强放在一个低效的环境下,也无力可施。

然后,QA 团队开始推动“持续交付”,试图改变现状。为什么是 QA 团队呢,因为 QA 在软件研发生命周期的最后一端,所有前期的问题,他们都得承担。低效的研发模式和体系,首先压死的就是 QA。但是,QA 团队最终还是以失败收场了。究其原因:

- 缺乏实践经验,多数“持续交付”相关的图书、分享都停留在“what”和“why”上,没有具体的“how”;

- QA 团队本身缺乏开发能力,无法将“持续交付”通过工具进行落地,只能流于表面的流程和理念。

但这场自底向上的革命,却让公司看到了变革的方向。

之后,点评就开始了轰轰烈烈的“精益创业”运动。“持续交付”作为研发线变革的重点,得到了更多资源的支持和高度的关注。也是在这时,我获得了与国内众多的领域专家进行探讨和学习的机会。

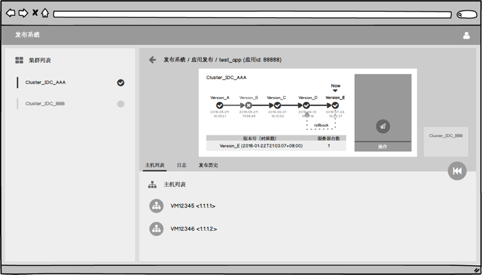

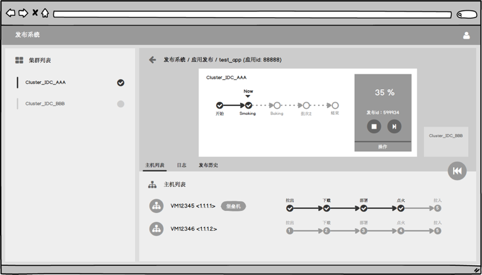

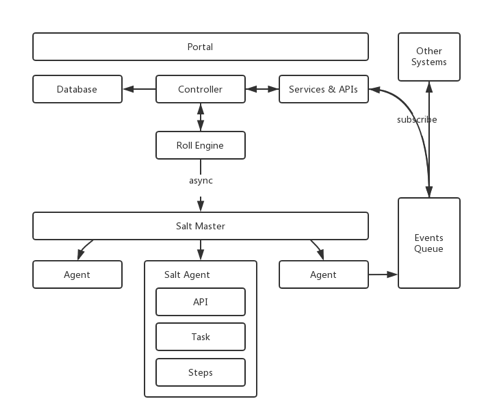

最终,点评是以发布系统为切入点,从下游逐步向上游的方式推行“持续交付”。 并且在这个过程中,形成了专职的工程效能团队,从而打造出了一套持续交付平台。

所以,我希望这个专栏的第二个重点是,结合我个人多年的实践经验,与你分享“持续交付”涉及的工具、系统、平台,到底如何去设计,如何去实施,如何去落地。

离开点评之后,我加入了携程。携程的规模、体量相比点评,又大了许多。比如,携程有近 20 个 BU,应用数量达到 6000+,研发人员有 3000 人;同时还有去哪儿、艺龙等兄弟公司,在系统上也息息相关;而且携程随着多年的业务发展,系统复杂度也远远高于点评。要在这么大的平台上推行“持续交付”,挑战是巨大的。

其实,携程在“持续交付”方面一直以来都是有所尝试和努力的,引进、自研各种方式都有,但是收效甚微。其中构建的一些工具和平台,由于种种问题,反而给研发人员留下了坏印象。这里面自然有各方面的问题,但我认为最主要的问题是以下三点:

- “持续交付”必须以平台化的思想去看待,单点突破是无力的;

- “持续交付”的实施,也要顺应技术的变迁,善于利用技术红利;

- “持续交付”与系统架构、运维体系息息相关,已经不分彼此。

事实上,在携程推进“持续交付”时,我们联合了框架、OPS 等部门,将目标放在支持更未来的容器化、云原生(Cloud Native),以及微服务上,利用这些新兴技术的理念,和开源社区的红利,从“持续发布”开始,逐步推进“持续交付”。

在推进的过程中,我们既兼容了老旧的系统架构,也为迁移到新一代架构做好了准备,并提供了支持。可以说,携程第四代架构的升级本身,就是在坚持“持续交付”,从而获得了成功。

所以,在 DevOps 越来越火的今天,我希望这个专栏可以达到的第三个目的是,能够让你看到“持续交付”与新兴技术擦出的火花,并与你探讨“持续交付”的未来。

除了以上内容,你还将通过我的专栏收获以下四个方面。

- “持续交付”的主要组件:配置管理、环境管理、构建集成和测试管理。 在这一部分里,我会深入浅出地,跟你聊聊“持续交付”的这“四大金刚”,帮你全方位地理解“持续交付”的各项主要活动。

- 如何实现“灰度发布”。 如果你对“持续部署”有所期待,希望进一步了解,那么你大多数的问题都可以在这一部分得到解答。

- 移动 App 中有所不同的“持续交付”体系。 移动互联网如火如荼,你一定也想了解下,如何在手机客户端研发中做好“持续交付”。那么这一部分,你就不能错过了。

- 如何利用开源红利,快速搭建一套持续交付平台。 在这一部分,我会手把手地,带你真正去搭建一套最小集合的持续交付平台。

01 持续交付到底有什么价值?

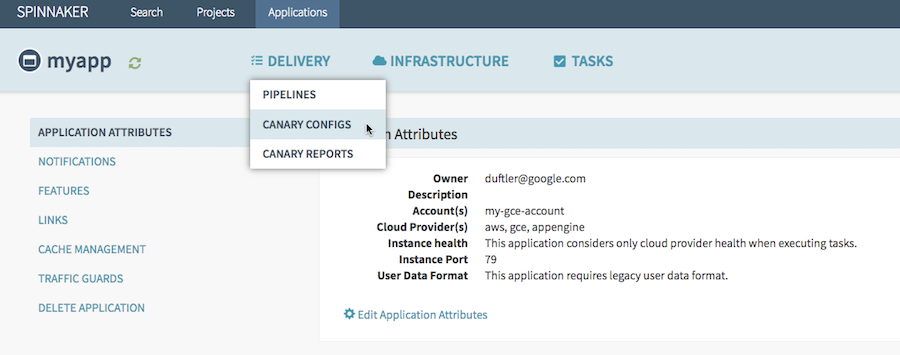

随着云计算、容器等新兴技术的发展,“持续交付”这个老生常谈的问题,忽如一夜春风来,仿佛找到了从理想通向现实的大门。各类相关工具、产品、服务,也是纷纷出现:如 Jenkins 2.0,Jenkins X,阿里云效,Netflix Spinnaker,Jfrog Artifactory 等等。

到底是什么魔力使得各大公司和厂商对“持续交付”如此趋之若鹜?那么,作为本专栏的第一篇文章,我就先来为你揭示“持续交付”真正的价值。

你了解持续交付吗?

持续交付,到底是什么意思,它的定义是什么?《持续交付:发布可靠软件的系统方法》一书中把“持续交付”定义为:

持续交付是软件研发人员,如何将一个好点子,以最快的速度交付给用户的方法。

是不是听起来有点抽象呢?其实这就好像你去问 100 个哲学家,“哲学”的定义是什么,你会获得 101 个答案一样。与马丁 · 福勒(Martin Fowler)老爷子在 2006 年,提出“持续集成”概念时一样,我们可以把 “持续交付”定义为“一套软件工程方法论和许许多多的最佳实践的集合”。

但即使熟知了定义和方法论,其实也还是如海市蜃楼一般,无法落地,因为大家所贡献的最佳实践才是持续交付理论的核心。只有真正在工作中贯彻和使用这些实践工具,才能体会持续交付的真正含义和作用。

持续集成、持续交付和持续部署的关系

了解了持续交付,你可能会说“持续集成”、“持续部署”又是什么意思, 它们和“持续交付”有什么关系呢。那我就给你简单解释一下。

我们通常会把软件研发工作拆解,拆分成不同模块或不同团队后进行编码,编码完成后,进行集成构建和测试。这个从编码到构建再到测试的反复持续过程,就叫作“持续集成”。

“持续集成”一旦完成,则代表产品处在一个可交付状态,但并不代表这是最优状态,还需要根据外部使用者的反馈逐步优化。当然这里的使用者并不一定是真正的用户,还可能是测试人员、产品人员、用户体验工程师、安全工程师、企业领导等等。

这个在“持续集成”之后,获取外部对软件的反馈再通过“持续集成”进行优化的过程就叫作“持续交付”,它是“持续集成”的自然延续。

那“持续部署”又是什么呢?软件的发布和部署通常是最艰难的一个步骤。

传统安装型软件,要现场调试,要用户购买等等,其难度可想而知。即使是可达度最高的互联网应用,由于生产环境的多样性(各种软件安装,配置等)、架构的复杂性(分布式,微服务)、影响的广泛性(需要灰度发布)等等,就算产品已是待交付的状态,要真正达到用户可用的标准,还有大量的问题需要解决。

而“持续部署”就是将可交付产品,快速且安全地交付用户使用的一套方法和系统,它是“持续交付”的最后“一公里”。

可见,“持续交付”是一个承上启下的过程,它使“持续集成”有了实际业务价值,形成了闭环,而又为将来达到“持续部署”的高级目标做好了铺垫。

虽然从概念上你可以这样理解,但从实践和我个人多年的经验来说,往往是从“持续部署”(自动化发布)开始推进“持续交付”,这才是一条优选的路径。这部分内容我会在后续文章中详细介绍。

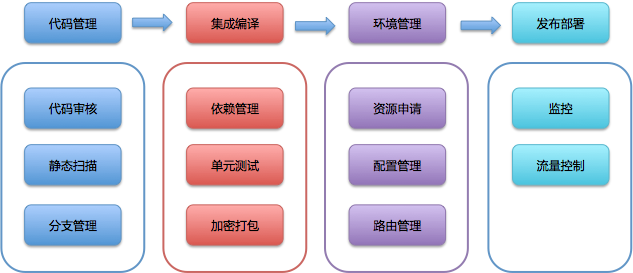

持续交付的显性价值

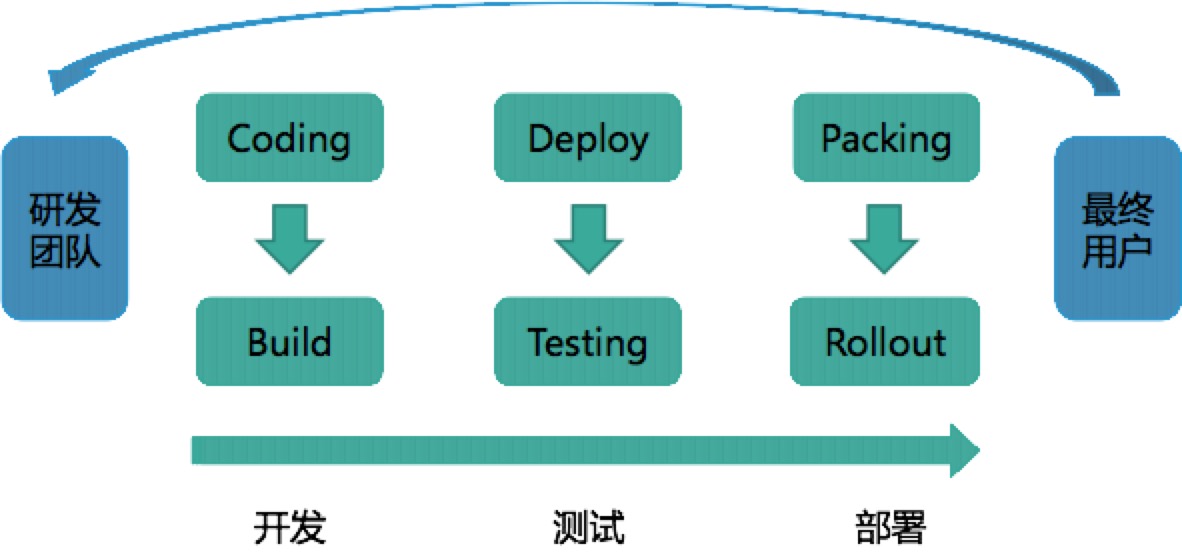

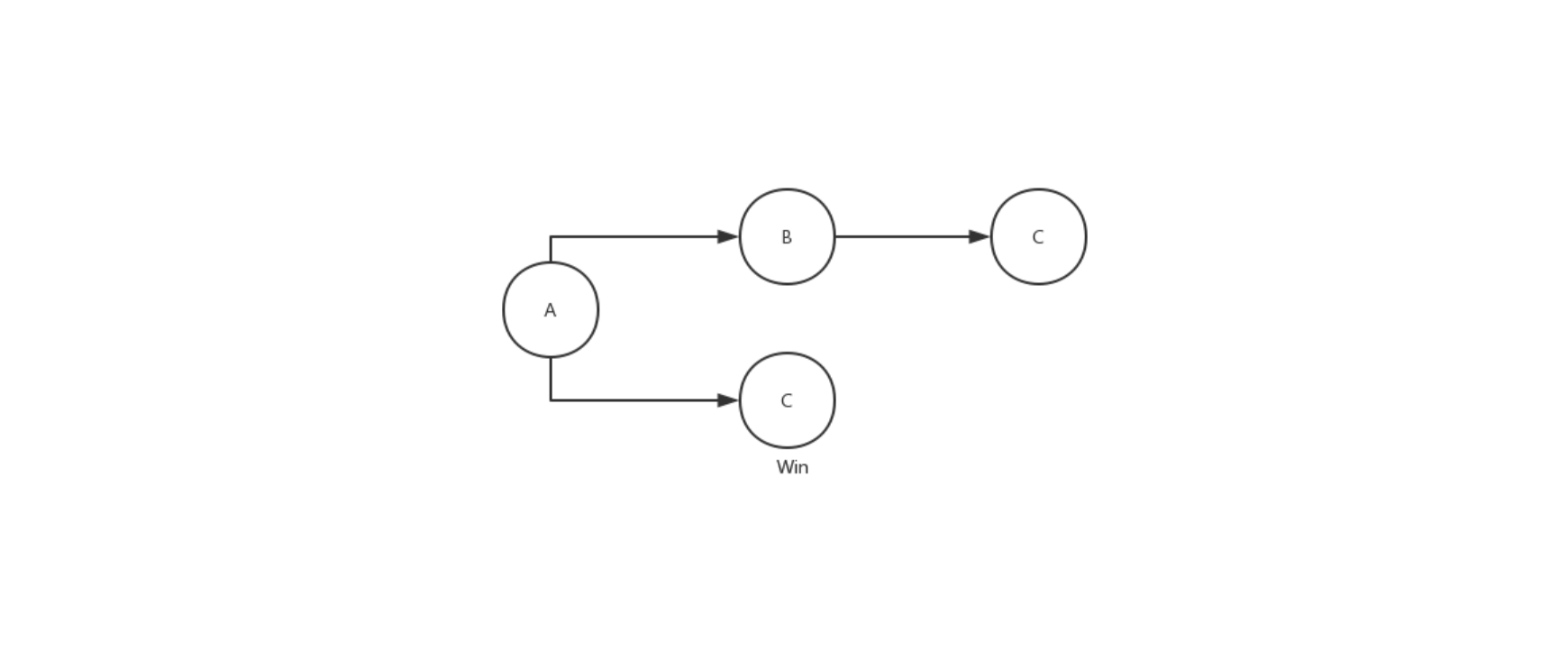

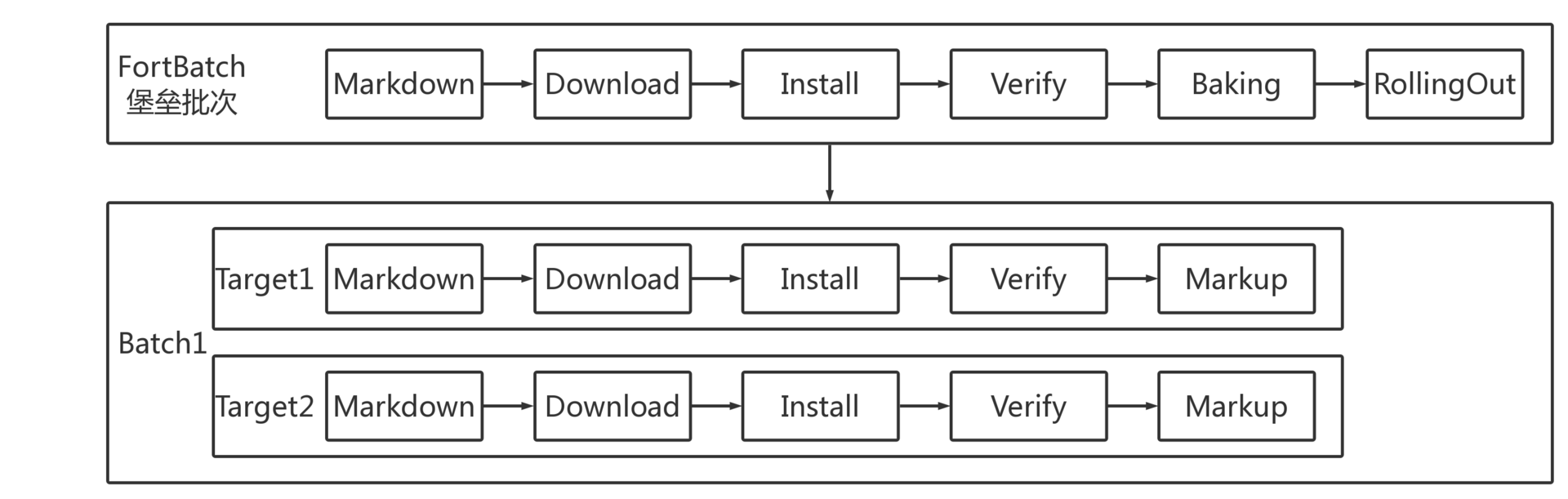

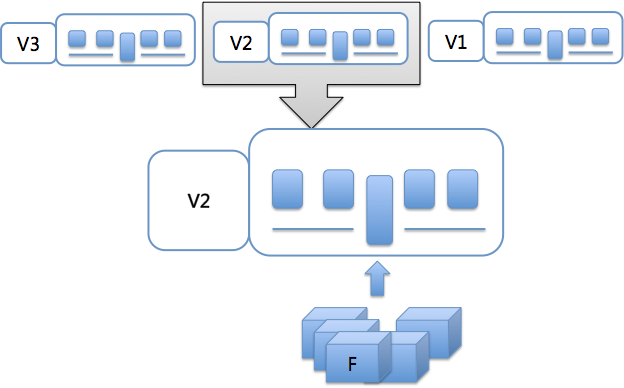

持续交付也通常以“发布流水线”的方式来解释,即研发团队从开发,到测试,再到部署,最终将产品交付给最终用户使用的过程。如下图:

虽然持续交付着重打造的是发布流水线的部分,但它所要达到的目标是在“最终用户”和“研发团队”之间建立紧密的反馈环:通过持续交付新的软件版本,以验证新想法和软件改动的正确性,并衡量这些改动对软件价值的影响。

这里说的“软件价值”,说白了就是收入、日活、GMV 等 KPI 指标了。

通常我们在实施持续交付后,都能够做到在保证交付质量的前提下,加快交付速度,从而更快地得到市场反馈,引领产品的方向,最终达到扩大收益的目的。

在互联网应用盛行、速度为王的今天,持续交付的价值更是被突显出来。持续交付的能力,正成为评定一家互联网公司研发能力的重要指标。

持续交付的隐性价值

除了上面这些你一眼就能看出来的价值外,如果作为不同的角色、站在不同的角度去看持续交付之后的变化,你还会发现其他一些隐性价值,而其中有一些影响甚至远远超过你的预期。

或者可以这么说,通过介绍持续交付的隐性价值,我希望你能够了解到,无论是什么企业,无论你的职位高低,都可以或者应该去尝试持续交付,它一定会让你觉得物超所值。

如果你是 CTO 或者是一个较大规模研发团队的管理者

- 你是不是时常困扰于技术选型的问题? 技术选型最大的难点在于影响大,又难以验证(或者验证效率低下)。而造成这些困境的绝大多数原因是没有合适的测试环境,比如环境差异造成测试数据缺乏说服力,又比如缺少隔离环境造成服务冲突等等。而这正是持续交付的用武之地。 持续交付的实施,将全面改善企业对测试环境的管理方法,使得环境管理更合理、更自由。我也将在后续章节里介绍如何做好环境管理。

- 你是不是经常头痛于已制定的标准难以落地? 标准、规范、流程的落地,都需要载体,而最好的载体就是平台工具。而持续交付是一整套平台工具的落地,几乎涵盖了研发的整个生命周期,是天然的、最佳的载体。 另外,持续交付的落地本身就伴随着各类标准、规范、流程的制定和实施,可以说两者相互依存,是非常好的管理思想落地方案。

- 你是不是时常考虑如何提高跨部门协作的效率? 我看到的每一个持续交付实施团队,都可以说是最厉害的“拆墙大队”,拆的就是各个研发协作部门间的“隔离墙”。 持续交付能够向各个协作部门输出统一的标准、流程和工具,提升沟通效率;并且通过大量的自动化,进一步提升各部门工作效率;还可以快速集成,把各个分散的团队,无论是横向的业务研发团队,还是纵向的技术框架团队,紧紧地联系在一起,共同进退。

- 你是不是担心“黑天鹅”的降临? 既然叫“黑天鹅”,那就是说明它的产生有一定的必然性。正应了一句老话“是福不是祸,是祸躲不过”,既然躲不过,那就解决它呗。其实任何故障都有一个天敌,叫作:快速恢复。 假设,所有的故障都可以在 3 分钟内恢复,你是不是觉得天下无敌了。那恢复故障最快、最有效的手段又是什么呢?当然就是回滚(或重新部署)了,而这正是持续交付所包含和着力打造的能力之一。

如果你是 Team Leader

- 你一定希望团队的知识能够传承。 互联网公司的人才流动之频繁已经远远超过了你我的想象。人来人往,如何将知识传承下来呢?其实在这方面,持续交付也能为团队提供很多帮助。 首先,持续交付将团队赖以生存的工作流程进行了固化;其次,利用代码静态检查等工具,能够很好地传承团队多年来的代码规范,并作为检查项进行自动化校验;再次,自动化测试的脚本,同样是团队经验的产物。

- 你一定希望团队专注于业务而非工程。 目前越来越多的公司或研发组织意识到,持续交付体系也如同中间件一样,能够从日常的业务研发工作中抽象出来,其不同只在于中间件解决架构问题,而持续交付解决工程问题。 这样研发团队能够全力应付业务的需求,而不用总是重复奔波于一些烦人且耗时的工程问题,比如安装测试机、准备编译服务器等等。

- 你一定希望以一个较平稳的节奏持续工作。 虽然在实施持续交付的初期,团队为了适应新的流程和工具,会有一定的效率下降,但之后在自动化的帮助下,团队效率会有一个明显的提升并逐渐稳定下来。 持续交付就是这样通过稳固的流程、自动化的工具和公开而真实的数据,来避免发布前夕容易发生的“死亡行军”式开发阶段。

如果你是产品经理

- 你应该是产品真正的第一个用户。 持续交付不仅仅是可以保证每一个变化都能及时得到测试以及反馈,更多的是解决测试与实际发布时存在差异的问题。 产品人员再也不会陷入“为什么用户端运行的结果,和在测试环境中的不一致”这样的窘境,他们将真正成为第一个用户,而不再是最后一个 QA。

- 你应该完全知悉当前的进度和质量。 作为产品人员,你是不是一直有这样的感觉:和研发团队之间总有一扇墙,程序员们似乎并不乐意告诉产品人员项目的真相;而最终总有这样那样的理由造成延期,产品人员往往无话可说。 那么,持续交付就能够实时地反应当前的开发情况,从而帮助产品人员决策和调整。

- 你的产品应该随时能发布。 计划永远赶不上变化,任何产品人员都希望自己的产品能够随时处于可发布状态。这样就能灵活地交付已完成的功能,迎合市场或业务的需要。 本质上,做到代码上线和业务上线的解耦分离,这也正是持续交付方法论强调的一个重点。

如果你是一个程序员

- 你可以通过对持续交付的学习,进一步加强自己对整个软件工程的认识。 持续交付涵盖了软件交付端到端的整个周期,其覆盖面不仅仅包括编码,还包括:设计、测试、部署、运维、运营等等。 如果你对自己的发展有更高的要求,那么你就应该学习一下持续交付的内容,它能让你看到更多与编码有关的其他东西,比如不同的编码方式等;也能让你站在更高的角度去看待自己的工作:研发效率的提高往往不是个人能力的提高,而是集体协同效率的提高。

- 你可以利用持续交付的工具或最佳实践,提高自己的工作效率和质量。 随着持续交付的流行,其配套的实践和工具也层出不穷。如果你玩过 ping-pong 式的结对编程(A 写测试,B 写实现,然后 B 写下一个测试,A 写重构和实现),你一定会觉得编程如此轻松有趣,而这种 TDD 的方式也很好的保证了代码质量。

- 你可以参与到持续交付实施中去,享受为其他程序员提供效率工具的挑战和乐趣。 试想一下,如果你是一个出租车司机,而你的乘客却是舒马赫(F1 世界冠军),此时你开车的压力会有多大。其实参与到持续交付的实施中也是一样,因为你正在用程序员的方式改造程序员的工作习惯,为程序员提供工具。 虽然挑战和压力巨大,但这又是如此有趣,你将会站在另一个高度去看你曾经的工作,不想试试吗?

如何评估持续交付的价值

我跟你说了这么多持续交付的价值,那如何评估它呢?这是一个非常难的问题,我自己每年在绩效考评时也都会问自己这个问题:我到底应该怎么给老板汇报呢?我可以量化持续交付的价值吗?

首先,你一定会说,我可以衡量产品的交付速度是否变快了。但是,实际情况下影响产品交付速度的因素实在太多,虽然我们一定知道持续交付有积极作用,但到底占比是多少呢?好像非常模糊,难以回答。

然后,你又想到,我们可以衡量各个自动化过程的速度是否变快了,比如:编译速度、发布速度、回滚速度、自动化测试速度等等。

是的,这些指标确实很好地反应了持续交付的价值,但总觉得这些并不是全部,持续交付的标准化、推行的新流程、改革的环境治理架构,好像都没有体现出来。

那到底应该怎么评估持续交付的价值呢?这里和你分享一下我在携程是怎么解决这个问题的。

我除了会评估一些常规的 KPI 外,更多地会换一种思考方式。既然很难量化持续交付的价值,那么我们就具象化,来看看整个工程生命周期中有多少被开发人员诟病,或者阻碍开发人员自助处理的问题点 ,即“不可持续点”:

开发不能按需产生隔离的测试环境; 生产代码回滚后,要手工处理代码分支; 预发布(Staging)流量要能自动分离,以便预发布测试。

在携程,我们会将所有的“不可持续点”进行记录和分解,通过 OKR 的考评方式,将消灭这些点作为目标,拆解出来的可行动点,作为关键结果,以这样的方式来完成绩效考评。

虽然,有些“不可持续点”已经超越了一般传统持续交付的概念,甚至有些已经超越了纯技术改进的范畴,但是持续交付仍会一直关注于消灭这些“不可持续点”。

So what,我们就是要持续交付我们的价值!

总结

接下来,我给你提炼一下今天内容的要点。

持续交付的价值不仅仅局限于简单地提高产品交付的效率,它还通过统一标准、规范流程、工具化、自动化等等方式,影响着整个研发生命周期。

持续交付最终的使命是打破一切影响研发的“阻碍墙”,为软件研发工作本身赋能。无论你是持续交付的老朋友还是新朋友,无论你在公司担任管理工作还是普通的研发人员,持续交付都会对你的工作产生积极的作用。

思考题

你的团队最希望借助持续交付解决什么现实问题?

02 影响持续交付的因素有哪些?

在上一篇文章中,我和你聊了聊“持续交付”的价值。现在,你是不是感觉热血澎湃,似乎找到了解决一些问题的良方?你是不是跃跃欲试,想在团队立刻实施看看效果如何?

但别急,就像我在开篇词里说的一样,“持续交付”可真不是一件简单的事情。你一定会在实施过程中碰到各种各样的问题和困难,但也不要气馁,我现在就和你说说:影响持续交付的各种因素。知己知彼,方可百战不殆。

与绝大多数理论分析一样,影响持续交付的因素也可归结为:人(组织和文化),事(流程),物(架构)。

组织和文化因素

谈到组织,你是不是一下就想到了部门划分,跨部门合作等?的确,这就是我要和你讲的第一个影响因素。因为“持续交付“一定是整个组织层面的事情,是跨部门合作的产物,所以组织和文化因素,是要首先考虑的问题。

什么样的组织文化,才是“持续交付”成长的沃土(当然这也是定义好的组织的标准),我把它分成了三个层次:

第一个层次:紧密配合,这是组织发展,部门合作的基础。

一般企业都会按照职能划分部门。不同的职能产生不同的角色;不同的角色拥有不同的资源;不同的资源又产生不同的工作方式。这些不同的部门紧密配合,协同工作于共同的目标,就能达到成效。

第二个层次:集思广益,这就需要组织内各个不同部门,或不同职能的角色,跳出自身的“舒适区”。

除思考和解决本身职能的问题外,各部门还要为达到组织的共同目标,通盘考虑和解决所遇到问题和困难。这个层次需要增加组织的透明度,需要接受互相批评和帮助。

第三个层次:自我驱动,是理想中的完美组织形式。

如果第二个层次能够持续地运转,就会形成自我学习、自我驱动的飞轮效应,并且越转越快,它甚至能自发式的预见困难,并自驱动解决问题。

这三个层次看起是不是有点眼熟,和我在上一篇文章中讲到的持续集成的三个层次:

- 分模块编码;

- 整体集成;

- 实现以上两个过程的自动化,并形成闭环;

好像是一样的。真是有趣,持续交付其实也是帮企业建立更好的组织形式的一种方法。

那么,在形成理想组织的实际执行中会遇到哪些问题呢?

一般软件企业与交付有关的研发部门包括四个:产品、开发、测试和运维。而这四个部门天然地形成了一个生产流水线,所以形成理想组织的第一层次紧密配合,基本没什么问题。

但是,要达到第二层次集思广益的难度,往往就很大。因为,每个部门有自身的利益,以及自己的工作方式和目标。

- 比如,产品人员和测试人员就是一对矛盾体:产品人员希望产品尽快上线,而测试人员则希望多留时间进行更完整的测试。

- 又比如,开发人员和运维人员也经常矛盾:开发人员希望能有完全权限,而运维人员却控制着生产的 root。

从各自的小目标的角度看,这些矛盾是正常的。但是,产品、开发、测试和运维这些部门的小目标往往就是实施持续交付的阻碍,只有它们把眼光放到更高地持续交付可用的产品上,有了共同的目标,问题才会迎刃而解。

那么,靠各个部门自己能解决这个问题吗,其实很难。组织的问题,还是需要通过组织变革来解决。通常我们会采用以下三种方案:

- 成立项目管理办公室(Project Manage Office,简称 PMO)这样的监督型组织,帮助持续交付落地;

- 独立建立工程效能部门,全面负责包括持续交付在内的研发效率提升工作;

- 使用敏捷形式,如 Scrum,打破职能部门间的“隔离墙”,以产品的形式组织团队,各团队自行推进持续交付 。

当然,这三种方案各有利弊。比如:

- 成立项目管理办公室,虽然会带来非常强大的项目推进力,但它往往需要通过流程把控进行监督,这样就很有可能把流程变得更加复杂;

- 而独立的工程效能部门,虽然能最大化地去做好持续交付工作,但其研发成本的投入也是需要考虑的,小团队的话,就不太适用了;

- 敏捷形式是比较适合中小团队的一种组织变革方式,但对个人能力的要求也会比较高,而且往往需要一个很长时间的磨合才能见效。

所以,你需要根据当前组织的情况来选择。总而言之,持续交付必须有与其相适应的组织和文化,否则将很难实施。

流程因素

要说持续交付对企业和组织改变最多的是什么,那么一定是流程。

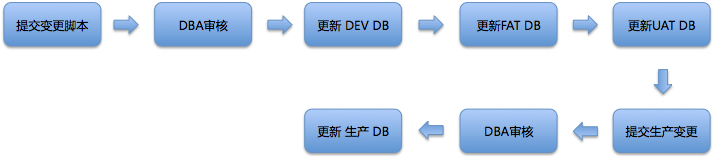

持续交付一定会打破的这三类流程是:

- 耗时较长的流程。比如,一个功能的研发迭代周期为 5 天,而其中有一个上线审核流程,需要花费 3 天时间,那这个流程就严重影响了持续交付,必须被打破。

- 完全人工类的流程。 完全人工操作的流程,一般效率低下,且质量难以保证,持续交付的逐步深入会通过自动化替代这些人工流程的存在。

- 信息报备类的流程。 持续交付过程中同样会产生各种信息流,这些信息有些需要广播,有些需要定点传递。实施持续交付后,这些信息报备类的流程一定会通过异步消息等方式进行改造。

其中,如何对待审批流程是重点。

在持续交付过程中,其实最让你头痛的应该是一些审批流程。这些流程既然叫做审批,那就代表着授权与责任,代表着严谨与严肃,因此也一定有其存在的价值和意义,不能轻易被去除或打破。

但是,你我都知道,审批往往指的是由人进行审核和批准,既是一个全人工流程,又是一个信息流转类流程。那么如何打破它呢?同样,也有几种思路:

- 该审批流程是否确实需要,如果能够通过系统来保证,则可以去除;

- 该审批流程是否可以从事前审批转化为事后审核;

- 该审批流程是否可以被简化。

但是,每家公司的流程都不太一样,所以我的这几个思路并不一定是放诸四海而皆准,但我希望你可以借鉴,或者从中学习到一些新的思路,并结合你自己的情况进行合理调整。

相对于组织文化和流程因素,架构是真正和技术相关的因素,也是我要和你重点分享的内容。

架构因素

技术架构对于持续交付来说,是万分重要的。如果遇到混乱的架构,那持续交付会处处受制,痛苦不堪。但与之前讨论的组织、文化和流程因素相比,架构的问题解决起来也会相对容易,因为凡是技术上的东西,都比较愿意接受优化,并且可以随着持续交付一起慢慢重构。

影响持续交付的架构因素,主要有两大部分:系统架构和部署架构,接下来我会给你详细展开。

第一,系统架构

系统架构指系统的组成结构,它决定了系统的运行模式,层次结构,调用关系等。我们通常会遇到的系统架构包括:

- 单体架构,一个部署包,包含了应用所有功能;

- SOA 架构,面向服务,通过服务间的接口和契约联系;

- 微服务架构,按业务领域划分为独立的服务单元,可独立部署,松耦合。

那么,这些架构对持续交付又有什么影响和挑战呢?

对单体架构来说:

- 整个应用使用一个代码仓库,在系统简单的情况下,因为管理简单,可以快速简单地做到持续集成;但是一旦系统复杂起来,仓库就会越变越大,开发团队也会越来越大,多团队维护一个代码仓库简直就是噩梦,会产生大量的冲突;而且持续集成的编译时间也会随着仓库变大而变长,团队再也承受不起一次编译几十分钟,结果最终失败的痛苦。

- 应用变复杂后,测试需要全回归,因为不管多么小的功能变更,都会引起整个应用的重新编译和打包。即使在有高覆盖率的自动化测试的帮助下,测试所要花费的时间成本仍旧巨大,且错误成本昂贵。

- 在应用比较小的情况下,可以做到单机部署,简单直接,这有利于持续交付;但是一旦应用复杂起来,每次部署的代价也变得越来越高,这和之前说的构建越来越慢是一个道理。而且部署代价高会直接影响生产稳定性。这显然不是持续交付想要的结果。

总而言之,一个你可以完全驾驭的单体架构应用,是最有容易做到持续交付的,但一旦它变得复杂起来,一切就都会失控。

对 SOA 架构来说:

- 由于服务的拆分,使得应用的代码管理、构建、测试都变得更轻量,这有利于持续集成的实施。

- 因为分布式的部署,使得测试环境的治理,测试部署变得非常复杂,这里就需要持续交付过程中考虑服务与服务间的依赖,环境的隔离等等。

- 一些新技术和组件的引入,比如服务发现、配置中心、路由、网关等,使得持续交付过程中不得不去考虑这些中间件的适配。

总体来说,SOA 架构要做到持续交付比单体架构要难得多。但也正因架构解耦造成的分散化开发问题,持续集成、持续交付能够在这样的架构下发挥更大的威力。

对微服务架构来说:

其实,微服务架构是一种 SOA 架构的演化,它给持续交付带来的影响和挑战也基本与 SOA 架构一致。

当然,如果你采用容器技术来承载你的微服务架构,就另当别论了,这完全是一个持续交付全新的领域,这部分内容我将在后续文章中跟你分享。

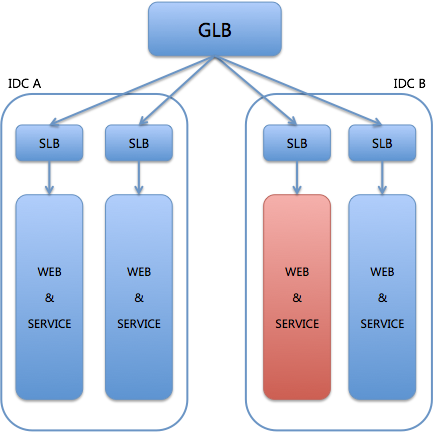

第二,部署架构

部署架构指的是,系统在各种环境下的部署方法,验收标准,编排次序等的集合。它将直接影响你持续交付的“最后一公里”。

首先,你需要考虑,是否有统一的部署标准和方式。 在各个环境,不同的设备上,应用的部署方式和标准应该都是一样的,可复用的;除了单个应用以外,最好能做到组织内所有应用的部署方式都是一样的。否则可以想象,每个应用在每个环境上都有不同的部署方式,都要进行持续交付的适配,成本是巨大的。

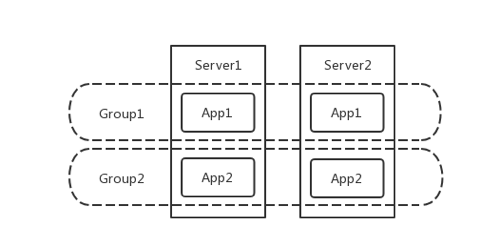

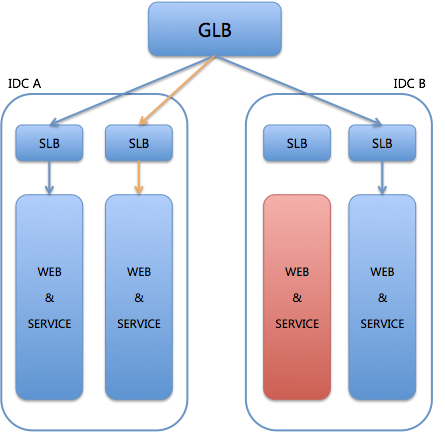

其次,需要考虑发布的编排次序。 特别是在大集群、多机房的情况下。我们通常会采用金丝雀发布(之后讲到灰度发布时,我会详解这部分内容),或者滚动发布等灰度发布策略。那么就需要持续交付系统或平台能够支持这样的功能了。

再次,是 markdown 与 markup 机制。 为了应用在部署时做到业务无损,我们需要有完善的服务拉入拉出机制来保证。否则每次持续交付都伴随着异常产生,肯定不是大家愿意见到的。

最后,是预热与自检。 持续交付的目的是交付有效的软件。而有些软件在启动后需要处理加载缓存等预热过程,这些也是持续交付所要考虑的关键点,并不能粗暴启动后就认为交付完成了。同理,如何为应用建立统一的自检体系,也就自然成为持续交付的一项内容了。

关于部署的问题,我也会在之后的篇章中和你详细的讨论。

总结

今天,我和你分享的主题是影响持续交付的因素,为了便于你理解,我将其划分为人(组织和文化),事(流程),物(架构)三个方面:

- 组织和文化,是最重要的因素,是持续交付推进的基础;

- 流程因素,实施持续交付也是一次流程改造之旅;

- 系统架构,与持续交付相互影响,但技术可以解决一切问题;部署架构,千万不要失败在“最后一公里”,这部分你也需要重点关注。

03 持续交付和DevOps是一对好基友

现在很多人都在困惑持续交付和 DevOps 到底是什么关系,有什么区别,或许你也感觉傻傻分不清楚。那么今天,我就来和你聊聊持续交付和 DevOps,以及它们到底是什么关系。

持续交付是什么?

我在专栏的第一篇文章中,已经跟你很详细地分享了持续交付是什么,为了加深你的印象,并与 DevOps 形成对比,我在这里再从另外一个角度给你总结一下:

持续交付是,提升软件交付速率的一套工程方法和一系列最佳实践的集合。

它的关注点可以概括为:持续集成构建、测试自动化和部署流水线。

那么,DevOps 又是什么呢?其实一直以来,学术界、工业界都对 DevOps 没有明确的定义,所以造成了大家对它的看法也是众说纷纭,也难免片面。

在我给出我个人的认识之前,我先给你讲讲 DevOps 是怎么被发明的吧。

DevOps 的诞生

DevOps 的故事,要从一个叫帕特里克 · 德博伊斯(Patrick Debois)的 IT 咨询师讲起。2007 年,帕特里克参与了一个政府下属部门的大型数据中心迁移的项目。

在这个项目中,帕特里克发现开发团队(Dev)和运维团队(Ops)的工作方式和思维方式有巨大的差异:

- Dev 的工作是,为软件增加新功能和修复缺陷,这要通过频繁的变更来达到;

- Ops 的工作是,保证系统的高稳定性和高性能,这代表着变更越少越不容易出错。

因此,Dev 和 Ops 长久以来,都处于对立和矛盾的状态。

2009 年 6 月 23 日,Flickr 公司的运维部门经理约翰 · 阿斯帕尔瓦(John Allspaw)和工程师保罗 · 哈蒙德在 Velocity 大会上做了一个轰动世界的演讲:《每天部署 10 次以上:Flickr 公司的 Dev 与 Ops 的合作》(10+ Deploys Per Day: Dev and Ops Cooperation at Flickr)。

这个演讲中提出了 DevOps 的核心观点:Dev 和 Ops 的矛盾可以通过技术升级和文化构建来解决,这标志着 DevOps 的诞生。

帕特里克也在网上看到了这个演讲,并且十分兴奋,因为这就是长久以来他所想解决的问题。于是,他开始筹备自己的 Velocity 大会。

2009 年 10 月,帕特里克的 Velocity 大会在比利时顺利召开,他把会议命名为 DevOpsDays。他本来想用 DOD 作为 DevOpsDays 的缩写,以提醒自己“死在交付上”(Dead On Delivery),但不知什么原因,他最后没有这么做。

这届大会出人意料的成功,许多开发工程师和运维工程师参加了这次大会,甚至还有各种 IT 管理人员参加。人们开始在 Twitter 上大量讨论 DevOpsDays 的内容。

由于 Twitter 对内容长度的限制是 140 个字符,所以大家在 Twitter 上讨论时去掉了“Days”,只保留了 “DevOps”。于是, DevOps 这个名称正式诞生。

持续交付的姗姗来迟

在 DevOps 的这段编年史里,持续交付又在哪里呢?

2006 年,杰斯 · 亨布尔(Jez Humble),克里斯 · 里德(Chris Read)和丹 · 诺斯(Dan North)在 Agile 大会上发表了一篇名为《部署生产线》(Deployment Production Line)的文章,这也是第一篇描述持续部署核心内容的会议文章。

在后面的三年里,又有一系列“持续部署”的文章被发表。2009 年,这一些系列的文章被编成为了一本叫作《持续交付:发布可靠软件的系统方法》的书,这一年也正是帕特里克举办 DevOpsDays 的那一年。

2010 年,《持续交付:发布可靠软件的系统方法》的作者之一杰斯参加了第二届的 DevOpsDays,并做了 关于“持续交付”的演讲,在这一年“DevOps”与“持续交付”终于有了交集。

从本质上说,帕特里克最初遇到的问题,在《持续交付:发布可靠软件的系统方法》一书中找到了最佳实践。如果这本书可以早两年问世,或许今天就不会有 DevOps 了。

然而,DevOps 的概念一直在向外延伸,包括了:运营和用户,以及快速、良好、及时的反馈机制等内容,已经超出了“持续交付”本身所涵盖的范畴。而持续交付则一直被视作 DevOps 的核心实践之一被广泛谈及。

这么看来,持续交付真是打了一个大盹儿。

认识 DevOps

DevOps 这几年一直在不断地演化,那么它到底是什么呢?

目前,人们对 DevOps 的看法,可以大致概括为 DevOps 是一组技术,一个职能、一种文化,和一种组织架构四种。

第一,DevOps 是一组技术,包括:自动化运维、持续交付、高频部署、Docker 等内容。

但是,如果你仅仅将 DevOps 认为是一组技术的集合的话,就有一些片面。任何技术都是为了解决某些问题而被创造出来的。比如 Docker,就是为了解决 DevOps 所提倡的“基础设施即代码”这个问题,而被创造出来的。

从这个角度来看的话,DevOps 的范畴应该远远大于一组技术了。

其实,DevOps 是一组技术这个观点,还是只站在了工程师角度去思考问题而得出的结论。虽然“DevOps”中“Dev”和“Ops”这两个角色都是工程师,但是其本质还是希望跳出工程师的惯性思维来看待问题。

第二,DevOps 是一个职能,这也是我在各个场合最常听到的观点。

你的公司有没有或者正准备成立一个叫作 DevOps 的部门,并将这个部门的工程师命名为 DevOps 工程师?至少在各大招聘网站上,是随处可见这样的职位,而招聘要求往往就是:会 Ops 技能的 Dev,或者会 Dev 技能的 Ops;或者干脆叫全栈工程师。

“DevOps 是一个职能”这个观点,源于设施的日趋完善,云服务的流行,以及各类开源工具的广泛使用,使传统 Ops 的工作重心发生了变化,使企业产生了不再需要 Ops 的错觉。

但这个观点也是错误的,原因就是忽略了 Dev 与 Ops 本质上是不同的,也就是他们掌握的技能是不同。

虽然在 DevOps 看来,Dev 和 Ops 的最终目标是一致的,都是为了快速向客户提供高质量的产品,但其达到目标的手段和方法是不一样的。比如,Ops 往往需要更多的在线处理问题的经验,而这未必是 Dev 所具备的。

所以,简单地把 DevOps 看做是一个职能,是一个彻底错误的观点。

第三,DevOps 是一种文化,推倒 Dev 与 Ops 之间的阻碍墙。

DevOps 是通过充分的合作解决责任模糊、相互推诿的问题和矛盾。在著名的演讲《每天部署 10 次以上:Flickr 公司的 Dev 与 Ops 的合作》 中,就明确的指出工具和文化是他们成功的原因。

其实,DevOps 通常想要告诉我们的是:什么行为是值得被鼓励的,而什么行为需要被惩罚。通过这样的方法,DevOps 可以促使我们形成良好的做事习惯,也就是 DevOps 文化。

所以,我们可以发现引入 DevOps 的组织,其实都是希望塑造这样的一种:信任、合作、沟通、学习、分享、共担等鼓励协作的文化。

第四,DevOps 是一种组织架构,将 Dev 和 Ops 置于一个团队内,一同工作,同化目标,以达到 DevOps 文化地彻底贯彻。

这看起来确实没有什么问题,而且敏捷团队往往都是这么去做的。但是,从另一方面来看,Ops 作为公司的公共研发资源,往往与 Dev 的配比是不成比例。所以,虽然我们希望每一个敏捷团队都有 Ops,但这可能是一种奢求。

但是,敏捷团队也说了,不一定是要有一个专职 Ops 人员,只要有负担这个角色职责的成员存在即可。这当然也讲得通,但可能真正的执行效果就没有 DevOps 所设想的那么好了。

所以,DevOps 是一种组织架构,这种说法,也对也不对,主要视组织的具体情况而定。

总结

今天,我和你一起回顾了 DevOps 产生的历程。同时,也顺便带你回顾了一下爱打盹儿的持续交付。我希望通过这篇文章,你可以理清持续交付和 DevOps 的关系:

- DevOps 的本质其实是一种鼓励协作的研发文化;

- 持续交付与 DevOps 所追求的最终目标是一致的,即快速向用户交付高质量的软件产品;

- DevOps 的概念比持续交付更宽泛,是持续交付的继续延伸;

- 持续交付更专注于技术与实践,是 DevOps 的工具及技术实现。

思考题

DevOps 大潮袭来,企业是不是真的就不需要 Ops 这个岗位了呢?

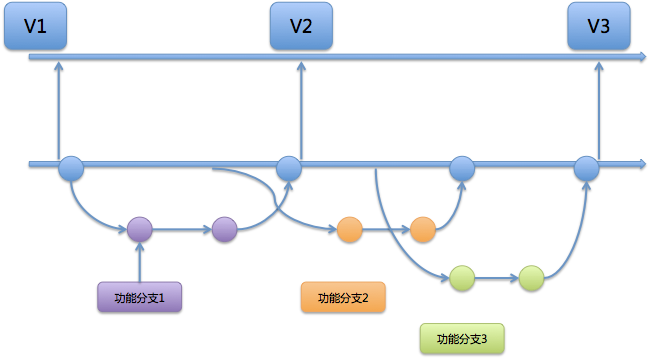

04 一切的源头,代码分支策略的选择

记得大概是一年前吧,我与好友老吴喝茶聊天时,讨论到:高效的持续交付体系,必定需要一个合适的代码分支策略。

我告诉老吴:“采用不同的代码分支策略,意味着实施不同的代码集成与上线流程,这会影响整个研发团队每日的协作方式,因此研发团队通常会很认真地选择自己的策略。”

老吴是一名有多年开发经验的资深架构师,当时正好要接手一个框架团队,从个人贡献者向团队管理者转型。他个人对代码管理工具可谓熟之又熟,甚至连“老古董”的 CVS 都可以跟你聊半天。但他在为团队制定代码分支管理策略时,还是慎之又慎,足见其重要性。

最后我们发现,要确定选用哪种代码分支管理策略,需要先假设几个问题,这几个问题有了答案,也就代表你找到了适合的方向。

你需要思考的几个问题如下:

- Google 和 Facebook 这两个互联网大咖都在用主干开发(Trunk Based Development,简称 TBD),我们是不是也参照它俩,采用主干开发分支策略?

- 用 Google 搜索一下,会发现有个排名很靠前的分支策略,叫“A successful Git branching model”(简称 Git Flow),它真的好用吗?团队可以直接套用吗?

- GitHub 和 GitLab 这两个当下最流行的代码管理平台,各自推出了 GitHub Flow 和 GitLab Flow,它们有什么区别?适合我使用吗?

- 像阿里、携程和美团点评这样国内知名的互联网公司,都在用什么样的分支策略?

今天,我想再沿着当时的思考路径,和你一起回顾和总结一下,希望能够带你全面了解代码分支策略,帮助你做出合适的选择。

谈谈主干开发(TBD)

主干开发是一个源代码控制的分支模型,开发者在一个称为 “trunk” 的分支(Git 称 master) 中对代码进行协作,除了发布分支外没有其他开发分支。

Google 和 Facebook 都是采用“主干开发”的方式,代码一般直接提交到主干的头部,这样可以保证所有用户看到的都是同一份代码的最新版本。

“主干开发”确实避免了合并分支时的麻烦,因此像 Google 这样的公司一般就不采用分支开发,分支只用来发布。

大多数时候,发布分支是主干某个时点的快照。以后的改 Bug 和功能增强,都是提交到主干,必要时 cherry-pick (选择部分变更集合并到其他分支)到发布分支。与主干长期并行的特性分支极为少见。

由于不采用“特性分支开发”,所有提交的代码都被集成到了主干,为了保证主干上线后的有效性,一般会使用特性切换(feature toggle)。特性切换就像一个开关可以在运行期间隐藏、启用或禁用特定功能,项目团队可以借助这种方式加速开发过程。

特性切换在大型项目持续交付中变得越来越重要,因为它有助于将部署从发布中解耦出来。但据吉姆 · 伯德(Jim Bird)介绍,特性切换会导致代码更脆弱、更难测试、更难理解和维护、更难提供技术支持,而且更不安全。

他的主要论据是,将未经测试的代码引入生产环境是一个糟糕的主意,它们引发的问题可能会在无意间暴露出来。另外,越来越多的特性切换会使得逻辑越来越混乱。

特性切换需要健壮的工程过程、可靠的技术设计和成熟的特性切换生命周期管理,如果不具备这三个关键的条件,使用特性切换反而会降低生产力。

根据上面的分析,主干开发的分支策略虽然有利于开展持续交付,但是它对开发团队的能力要求也更高。

主干开发的优缺点如表 1 所示。

| 优点 | 缺点 |

|---|---|

| 1. 频繁集成,每次集成冲突少,集成效率高。 2. 能享受持续交付带来所有的好处。 3. 无需在分支之间做切换。 | 1. 太多的团队成员同时工作在主干上,到发布的时候就可能出现“一粒老鼠屎坏了一锅粥”这样的灾难。 2. 要借助特性切换等机制来保证线上运行的正确性,这会引入新的问题。 |

表 1 主干开发的优缺点

谈谈特性分支开发

和主干开发相对的是 “特性分支开发” 。在这个大类里面,我会给你分析 Git Flow、GitHub Flow 和 GitLab Flow 这三个常用的模型。

第一,Git Flow

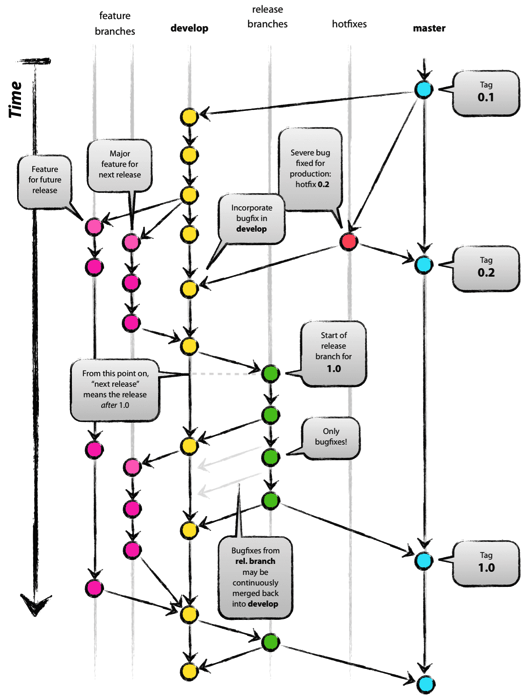

我们在 Google 上查关键词“branch model”(也就是“分支模型”),有一篇排名比较靠前的文章“A successful Git branching model”,它介绍了 Git Flow 模型。

Git 刚出来的那些年,可参考的模型不多,所以 Git Flow 模型在 2011 年左右被大家当作了推荐的分支模型,至今也还有项目团队在使用。然而,Git Flow 烦琐的流程也被许多研发团队吐槽,大家普遍认为 hotfix 和 release 分支显得多余,平时都不会去用。

图 1 Git Flow 示意图

第二,GitHub Flow

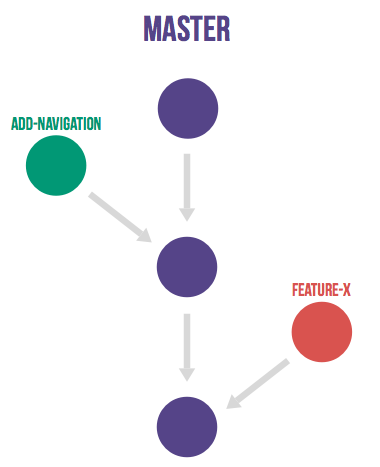

GitHub Flow 是 GitHub 所使用的一种简单流程。该流程只使用 master 和特性分支,并借助 GitHub 的 pull request 功能。

图 2 GitHub Flow 示意图

在 GitHub Flow 中,master 分支中包含稳定的代码,它已经或即将被部署到生产环境。任何开发人员都不允许把未测试或未审查的代码直接提交到 master 分支。对代码的任何修改,包括 Bug 修复、热修复、新功能开发等都在单独的分支中进行。不管是一行代码的小改动,还是需要几个星期开发的新功能,都采用同样的方式来管理。

当需要修改时,从 master 分支创建一个新的分支,所有相关的代码修改都在新分支中进行。开发人员可以自由地提交代码和提交到远程仓库。

当新分支中的代码全部完成之后,通过 GitHub 提交一个新的 pull request。团队中的其他人员会对代码进行审查,提出相关的修改意见。由持续集成服务器(如 Jenkins)对新分支进行自动化测试。当代码通过自动化测试和代码审查之后,该分支的代码被合并到 master 分支。再从 master 分支部署到生产环境。

GitHub Flow 的好处在于非常简单实用,开发人员需要注意的事项非常少,很容易形成习惯。当需要修改时,只要从 master 分支创建新分支,完成之后通过 pull request 和相关的代码审查,合并回 master 分支就可以了。

第三,GitLab Flow

上面提到的 GitHub Flow,适用于特性分支合入 master 后就能马上部署到线上的这类项目,但并不是所有团队都使用 GitHub 或使用 pull request 功能,而是使用开源平台 GitLab,特别是对于公司级别而言,代码作为资产,不会随意维护在较公开的 GitHub 上(除非采用企业版)。

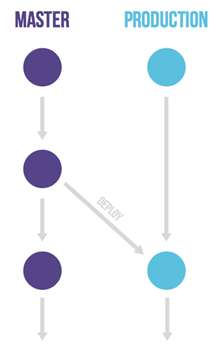

GitLab Flow 针对不同的发布场景,在 GitHub Flow(特性分支加 master 分支)的基础上做了改良,额外衍生出了三个子类模型,如表 2 所示。

| 分支模型 | 说明 | 图示 |

|---|---|---|

| 带生产分支 | 1. 无法控制准确的发布时间,但又要求不停集成的。 2. 需要创建一个 production 分支来放置发布的代码。 | 图 3 |

| 带环境分支 | 1. 要求所有代码都在逐个环境中测试通过。 2. 需要为不同的环境建立不同的分支。 | 图 4 |

| 带发布分支 | 1. 用于对外界发布软件的项目,同时需要维护多个发布版本。 2. 尽可能晚地从 master 拉取发布分支。 3. Bug 的修改应先合并到 master,然后 cherry pick 到 release 分支 。 | 图 5 |

表 2 GitLab Flow 的三个分支

图 3 带生产分支的 GitLab Flow

图 4 带环境分支的 GitLab Flow

图 5 带发布分支的 GitLab Flow

GitLab Flow 的特性分支合入 master 用的是“Merge Request”,功能与 GitHub Flow 的“pull request”相同,这里不再赘述。

通过 Git Flow、GitHub Flow 和 GitLab Flow(3 个衍生类别) 这几个具体模型的介绍,我给你总结一下特性分支开发的优缺点。如表 3 所示。

| 优点 | 缺点 |

|---|---|

| 1. 不同功能可以在独立的分支上做开发,消除了功能稳定前彼此干扰的问题。 2. 容易保证主干分支的质量:只要不把没开发好的特性分支合入主干分支,那么主干分支就不会带上有问题的功能。 | 1. 如果不及时做 merge,那么把特性分支合到主干分支会比较麻烦。 2. 如果要做 CI/CD,需要对不同分支配备不同的构建环境。 |

表 3 特性分支开发的优缺点

选出最适合的分支策略

上面我跟你讲到的分支模型,都是 IT 研发领域比较流行的。虽然有些策略带上了代码平台的标识,如 GitHub Flow,但并不意味着该策略仅限于 GitHub 代码平台使用,你完全可以在自己搭建的代码平台上使用这些策略。

接下来,我就总体归纳一下什么情况下应该选择什么样的分支策略。如表 4 所示。

| 序号 | 情况 | 适合的分支策略 |

|---|---|---|

| 1 | 开发团队系统设计和开发能力强。 有一套有效的特性切换的实施机制,保证上线后无需修改代码就能够修改系统行为。 需要快速迭代,想获得 CI/CD 所有好处。 | 主干开发 |

| 2 | 不具备主干开发能力。 有预定的发布周期。 需要执行严格的发布流程。 | Git Flow |

| 3 | 不具备主干开发能力。 随时集成随时发布:分支集成后经过代码评审和自动化测试,就可以立即发布的应用。 | GitHub Flow |

| 4 | 不具备主干开发能力。 无法控制准确的发布时间,但又要求不停集成。 | GitLab Flow(带生产分支) |

| 5 | 不具备主干开发能力。 需要逐个通过各个测试环境验证。 | GitLab Flow(带环境分支) |

| 6 | 不具备主干开发能力。 需要对外发布和维护不同版本。 | GitLab Flow(带发布分支) |

表 4 不同情况适用的代码分支策略

国内互联网公司的选择

GitLab 作为最优秀的开源代码平台,被多数互联网大公司(包括阿里、携程和美团点评等)所使用,这些大厂也都采用特性分支开发策略。当然,这些大公司在长期持续交付实践中,会结合各自公司的情况做个性化的定制。

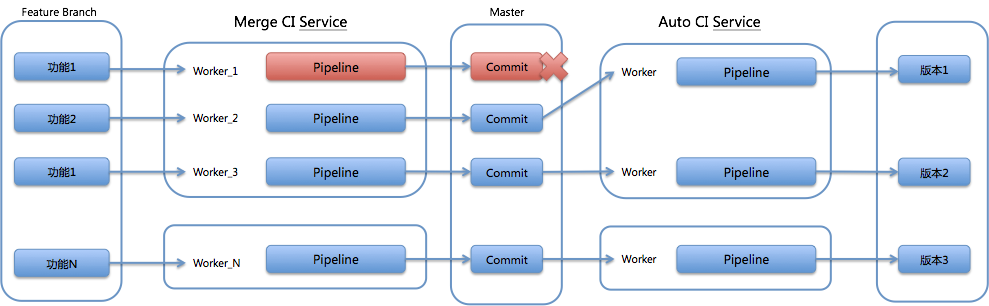

比如,携程公司在 GitHub Flow 的基础上,通过自行研发的集成加速器(Light Merge)和持续交付 Paas 平台,一起完成集成和发布。

再比如,阿里的 AoneFlow,采用的是主干分支、特性分支和发布分支三种分支类型,再加上自行研发的 Aone 协同平台,实现持续交付。

总结

今天,我主要给你介绍了各种代码分支策略的特性。

你应该已经比较清晰地理解了“主干开发”和“特性分支开发”两种策略的各自特性:

- “主干开发”集成效率高,冲突少,但对团队个人的开发能力有较高要求;

- “特性分支开发”有利于并行开发,需要一定的流程保证,能保证主干代码质量。

相信在没有绝对自信能力的情况下,面对绝大多数的场景,企业还是会选择“特性分支开发”的策略。所以,我给你介绍了几种主流的特性分支方法,并对比了各类策略的优劣,以及它们适用的场景。

接下来,你就可以根据自己所在项目的具体情况,参考今天的内容,裁剪出最适合自己团队的分支策略了。

思考题

- 开源性质的项目,为什么不适合用主干开发的分支策略?

- 如果你所在的团队只有 5 人,而且迭代周期为 1 周,你会采用什么样的分支策略?

05 手把手教你依赖管理

软件工程是多人合作的结果,我们在开发软件的时候经常会使用一些别人编写好的,比较成熟的库。

比如,早期的前端开发用到了 jQuery 库,那么通常的做法是去官网下载一个最新版本的 jQuery,然后放在自己本地的项目中。对于简单的前端项目来说,这样可以简单粗暴地达到目的。

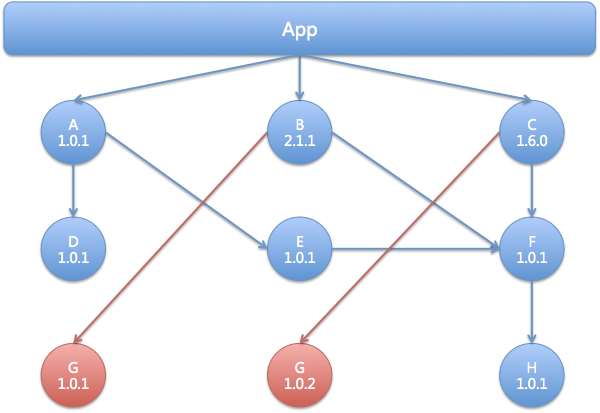

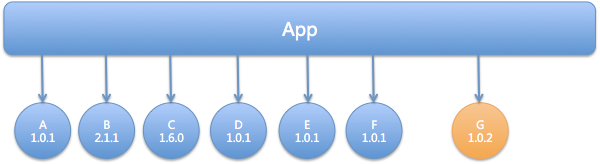

但当项目越来越庞大,除了 jQuery 之外,你还会依赖一些其他的第三方库。比如 Bootstrap 与 Chosen,这两个流行的前端库也都依赖 jQuery,如果这些第三方库依赖的 jQuery 版本一致还好,但大多数情况并没有这么乐观:

你的项目依赖的 jQuery 版本是 1.0.0 ,Bootstrap 依赖的版本是 1.1.0,而 Chosen 依赖的版本是 1.2.0,看上去都是小版本不一致,一开始并没有发现任何问题,但是如果到后期发现不兼容,可能就为时已晚了。

所以,你需要在确定依赖之前,就把整个系统的依赖全部梳理一遍,保证每个依赖都不会有冲突问题。

你可能会质疑,这个前端工程师一定是初级的,事先都不会确认 Bootstrap 和 Chosen 依赖的版本吗,直接选择依赖 jQuery 1.0.0 版本的不就行了?

这么说有一定道理,但是手工维护这些依赖是相当麻烦且容易出错的。随便找一个比较流行的开源软件,你都会发现它依赖了大量的第三方库,而这些第三方库又依赖着其他的第三方库,形成了一条十分复杂的依赖链。靠人工去解决这个依赖链一定会让你怀疑人生,因此你需要一些工具去管理项目的依赖。

你见过几种依赖管理工具?

其实,各大平台早已有一套自己的手段来解决上述的问题,仔细看看你常用的软件,你会发现其实工作当中已经充斥着各种各样的依赖管理工具,没有它们你将寸步难行。

操作系统的依赖管理工具,比如 CentOS 的 yum,Debian 的 apt,Arch 的 Packman,macOS 的 Homebrew; 编程语言的依赖管理工具,比如 Java 的 Maven, .Net 的 nuget,Node.js 的 npm,Golang 的 go get,Python 的 pip,Ruby 的 Gem 。

这些平台的解决思路都是将依赖放到共同的仓库,然后管理工具通过依赖描述文件去中央仓库获取相应的包。

一个典型的依赖管理工具通常会有以下几个特性:

- 统一的命名规则,也可以说是坐标,在仓库中是唯一的,可以被准确定位到;

- 统一的中心仓库可以存储管理依赖和元数据;

- 统一的依赖配置描述文件;

- 本地使用的客户端可以解析上述的文件以及拉取所需的依赖。

接下来我以 Maven 为例,跟你一起探究一下 Maven 会如何管理 Java 项目的依赖。

Maven 如何管理依赖?

Maven 是 Java 生态系统里面一款非常强大的构建工具,其中一项非常重要的工作就是对项目依赖进行管理。

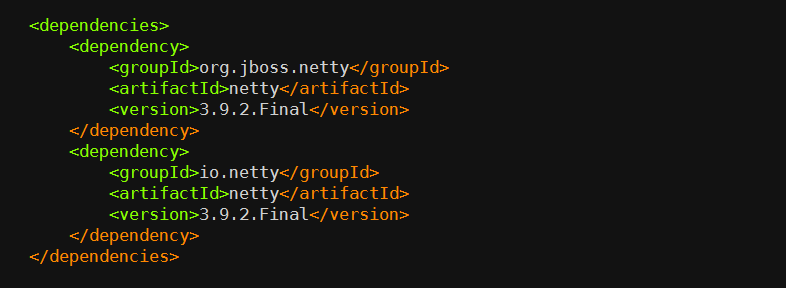

Maven 使用 XML 格式的文件进行依赖配置描述的方式,叫作 POM(Project Object Model ),以下就是一段简单的 pom.xml 文件片段:

在 POM 中,根元素 project 下的 dependencies 可以包含一个或多个 dependency 元素,以声明一个或者多个项目依赖。每个依赖可以包含的元素有:

- groupId、artifactId、version: 依赖的基本坐标;

- type: 依赖的类型,默认为 jar;

- scope: 依赖的范围;

- optional: 标记依赖是否可选;

- exclusions: 用来排除传递性依赖;

要想用好 Maven 管理依赖,你必须理解每一项的含义,而新手通常傻傻分不清楚。举个例子,依赖范围这一项,Maven 在不同的时期会使用不同的 classpath :

- 比如,junit 只有在测试的时候有用,那么将其设为 test scope 就可以;

- 再比如 ,servlet API 这个 jar 包只需要在编译的时候提供接口,但是实际在运行时会有对应的 servlet 容器提供,所以没必要打到 war 包中去,这时候只需要指定在 provided scope 就可以了。通过指定 provided scope 的方式可以让每个依赖各司其职,不用弄成“一锅粥”。

包管理工具还解决了依赖传递的问题,比如你的项目 A 依赖了 B,而 B 依赖了 C 和 D,那么在获取依赖的时候会把 B、C、D 都一起拉下来,这样可以节省大量的时间。

再让我们回到最开始的问题:依赖不一致该如何处理?通常,每个包管理工具都有一套自己的原则,Maven 的依赖仲裁原则如下。

第一原则: 最短路径优先原则。 比如,A 依赖了 B 和 C,而 B 也依赖了 C,那么 Maven 会使用 A 依赖的 C 的版本,因为它的路径是最短的。

第二原则: 第一声明优先原则。 比如,A 依赖了 B 和 C,B 和 C 分别依赖了 D,那么 Maven 会使用 B 依赖的 D 的版本,因为它是最先声明的。

根据这两个原则,Maven 就可以确定一个项目所有依赖的列表,但它处理依赖的方式还是有些简单粗暴。有时 Maven 的决定结果并不是你想要的,所以我们在使用 Maven 的时候还是要多加小心。

Maven 最佳实践

接下来,我跟你分享下,我平时使用 Maven 时总结的一些经验。

- 生产环境尽量不使用 SNAPSHOT 或者是带有范围的依赖版本,可以减少上线后的不确定性,我们必须保证,测试环境的包和生产环境是一致的。

- 将 POM 分成多个层次的继承关系,比如携程的 POM 继承树一般是这样:

corp pom

ctrip pom/qunar pom

bu pom

product pom

project parent pom

project sub module pom

这样做的好处是每一层都可以定义这一级别的依赖。 其中 ctrip pom/qunar pom 我们叫它为公司的 super-pom,每个项目必须直接或间接的继承其所在公司的 super-pom。这样做的好处是每一层都可以定义这一级别的依赖,便于各个层次的统一管理。

- 在父模块多使用 dependencyManagement 来定义依赖,子模块在使用该依赖时,就可以不用指定依赖的版本,这样做可以使多个子模块的依赖版本高度统一,同时还能简化子模块配置。

- 对于一组依赖的控制,可以使用 BOM(Bill of Materials) 进行版本定义。一般情况下,框架部门有一个统一的 BOM 来管理公共组件的版本,当用户引用了该 BOM 后,在使用框架提供的组件时无需指定版本。即使使用了多个组件,也不会有版本冲突的问题,因为框架部门的专家们已经在 BOM 中为各个组件配置了经过测试的稳定版本。 BOM 是一个非常有用的工具,因为面对大量依赖时,作为用户你不知道具体应该使用它们的哪些版本、这些版本之间是否有相互依赖、相互依赖是否有冲突,使用 BOM 就可以让用户规避这些细节问题了。

- 对于版本相同的依赖使用 properties 定义,可以大大减少重复劳动,且易于改动。上面的 pom.xml 片段,就是使用了 properties 来定义两个一样的版本号的依赖。

- 不要在在线编译环境中使用 mvn install 命令,否则会埋下很多意想不到并且非常难以排查的坑:该命令会将同项目中编译产生的 jar 包缓存在编译系统本地,覆盖 mvn 仓库中真正应该被引用的 jar 包。

- 禁止变更了代码不改版本号就上传到中央仓库的行为。否则,会覆盖原有版本,使得一个版本出现二义性的问题。

归根结底,这些经验都是为了两件事:减少重复的配置代码,以及减少不确定的因素发生。

有时候,你会听到来自业务开发部门同事传来报障的声音:“为什么我本地可以编译通过,而你们编译系统编译通不过?”难道 Maven 在工作的时候还看脸? 当然不是!

遇到这样的情况不要急,处理起来通常有如下“三板斧”:

- 确认开发操作系统,Java 版本,Maven 版本。通常情况下操作系统对 Java 编译的影响是最小的,但是偶尔也会遇到一些比如分隔符(冒号与分号)之类的问题。Java 和 Maven 的版本应尽量与生产编译系统保持一致,以减少不必要的麻烦。

- 如果确认了开发操作系统没问题,那么你可以把用户的项目拉到自己的本地,并且删除本地依赖的缓存,也就是删除 .m2 目录下的子目录,减少干扰,执行编译。若编译通不过,说明用户本地就有问题,让他也删掉自己本地的缓存找问题。如果可以编译通过,说明问题出在编译系统,进入第 3 步。

- 使用 mvn dependency 命令对比生产编译系统与本地依赖树的区别,检查编译系统本地是否被缓存了错误的 jar 包,从而导致了编译失败。有时候这种错误会隐藏得比较深,非常难查,需要很大的耐心。

总结

今天,我跟你聊了聊依赖的问题。你可以从中:

- 了解到依赖管理的复杂度是如何产生的;

- 学习到依赖管理的一些常规思路;

- 初步掌握通过 Maven 进行依赖管理的方式方法,及一些最佳实践。

同时我也与你一起分享了一些我的实际经验,希望能够对你在实际工作中有所帮助。

后续

理想是美好的,然而现实却很骨感,在实际过程中我们也遇到了一些问题,比如用户不遵守我们推荐的命名规则,或者不继承公司提供的 Super POM,或者框架组件升级而用户不愿意升级等等。

为了能够统一管理,我们在构建系统上增加了一些强制手段来做统一的约束,使用 Maven Enforcer 插件以及其他方式对构建过程实行大量检查,欲知详情,请听下回分解。

06 代码回滚,你真的理解吗?

什么是代码回滚?

在我正式开始今天的分享前,先给你讲两个核心概念:

- 包回滚是指,线上运行的系统,从现在的版本回滚到以前稳定的老版本。

- 代码回滚是指,Git 分支的指针(游标),从指向当前有问题的版本改为指向一个该分支历史树上没问题的版本,而这个版本可以是曾经的 commit,也可以是新建的 commit。

你是不是也遇到了问题?

在日常的代码管理中,困扰开发工程师最多,也是他们向我咨询得最多的问题就是:代码回滚的问题。这些问题,有的只是影响个人开发,而有的涉及了整个团队。我把这些问题进行了整理汇总,你可以看看是否也遇到过类似的问题?

- 今天上午我在自己的开发环境上拉了一条新分支,提交了 5 个 commit,最新提交的 3 个 commit 我不想要了,那我该怎么退回到这 3 个 commit 之前的那个 commit? 答:参考我在下面即将分享的“个人分支回滚”的内容。

- 我本地的分支通过 reset –hard 的方式做了代码回滚,想通过 push 的方式让远端的分支也一起回滚,执行 push 命令时却报错,该怎么办? 答:如果不加 -f 参数,执行 reset –hard 后,push 会被拒绝,因为你当前分支的最新提交落后于其对应的远程分支。push 时加上 -f 参数代表强制覆盖。

- 线上产品包已经回滚到昨天的版本了,我清清楚楚地记得昨天我把发布分支上的代码也 reset –hard 到对应的 commit 了,怎么那几个有问题的 commit 今天又带到发布分支上了?真是要命! 答:集成分支不能用 reset –hard 做回滚,应该采用集成分支上新增 commit 的方式达到回滚的目的。

- 我刚刚在 GitLab 上接纳了一个合并请求(Merge Request),变更已经合入到 master 上了,但现在我发现这个合并出来的 commit 有较大的质量问题,我必须把 master 回滚到合并之前,我该怎么办? 答:可以在 GitLab 上找到那个合并请求,点击 revert 按钮。

- 刚刚线上 A 产品 V6.2 的包有问题,我已经把 A 的产品包回退到 V6.1 版本了,请问发布分支上的代码也要回滚到 V6.1 对应的 commit 吗? 答:你可以在下文“哪些情况下需要回滚代码?”和“哪些情况下包的回滚无需回滚代码?”中找到答案。

- 产品包的回滚可以在我们公司持续交付云平台上执行,平台能不能也提供代码一键回滚的功能?这样我们回滚代码能相对轻松一些。 答:针对已上线发布的版本,我认为持续交付平台提供一键回滚的方式还是有必要的。这么做可以规范集成分支上线后代码回滚的行为,也能减少人为失误。具体做法可以参考我在下面给你分享的“集成分支上线后回滚”的内容。

上面这六个问题,除了前两个问题外,剩下的四个问题都可能影响到整个团队,因此回滚代码时须站在团队的立场,采用合适的方式进行回滚。

接下来,我就一一为你解答这些问题。

哪些情况下需要回滚代码?

在代码集成前和集成后,都有可能需要回滚代码。

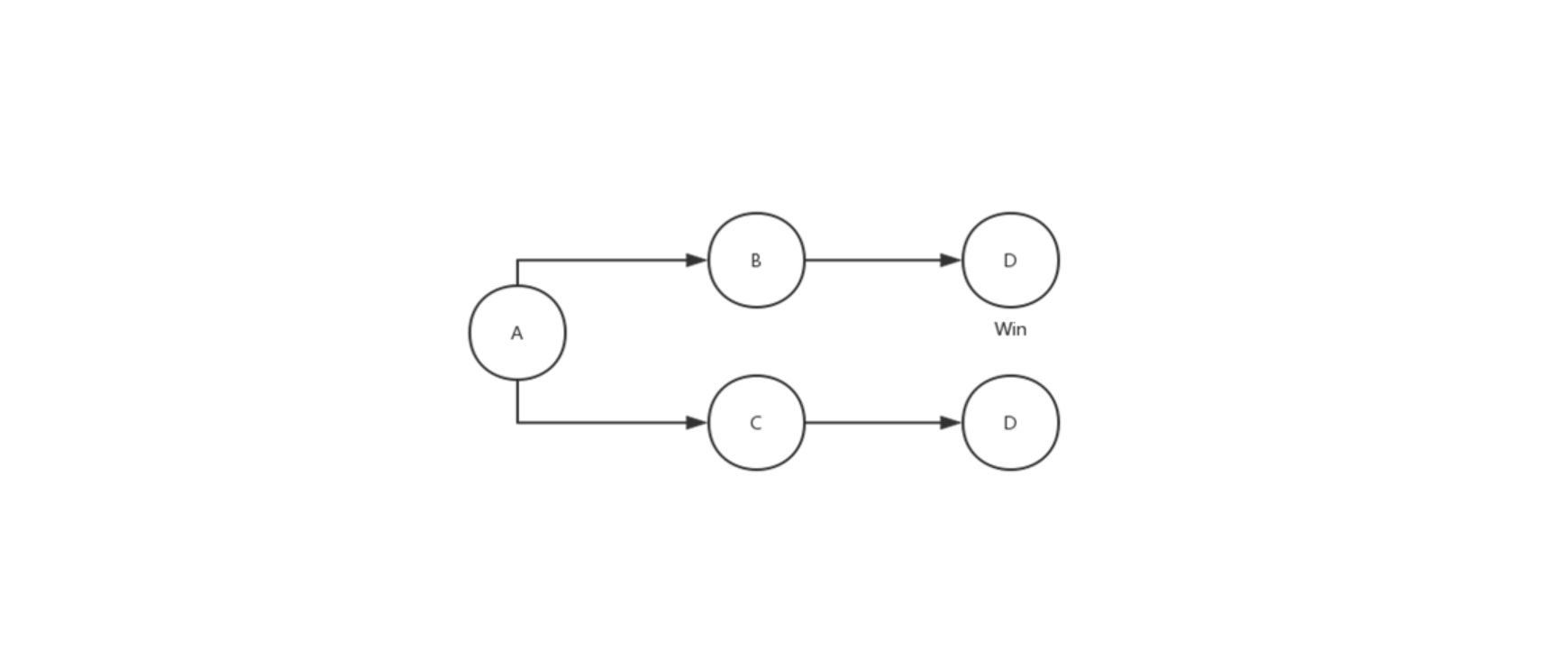

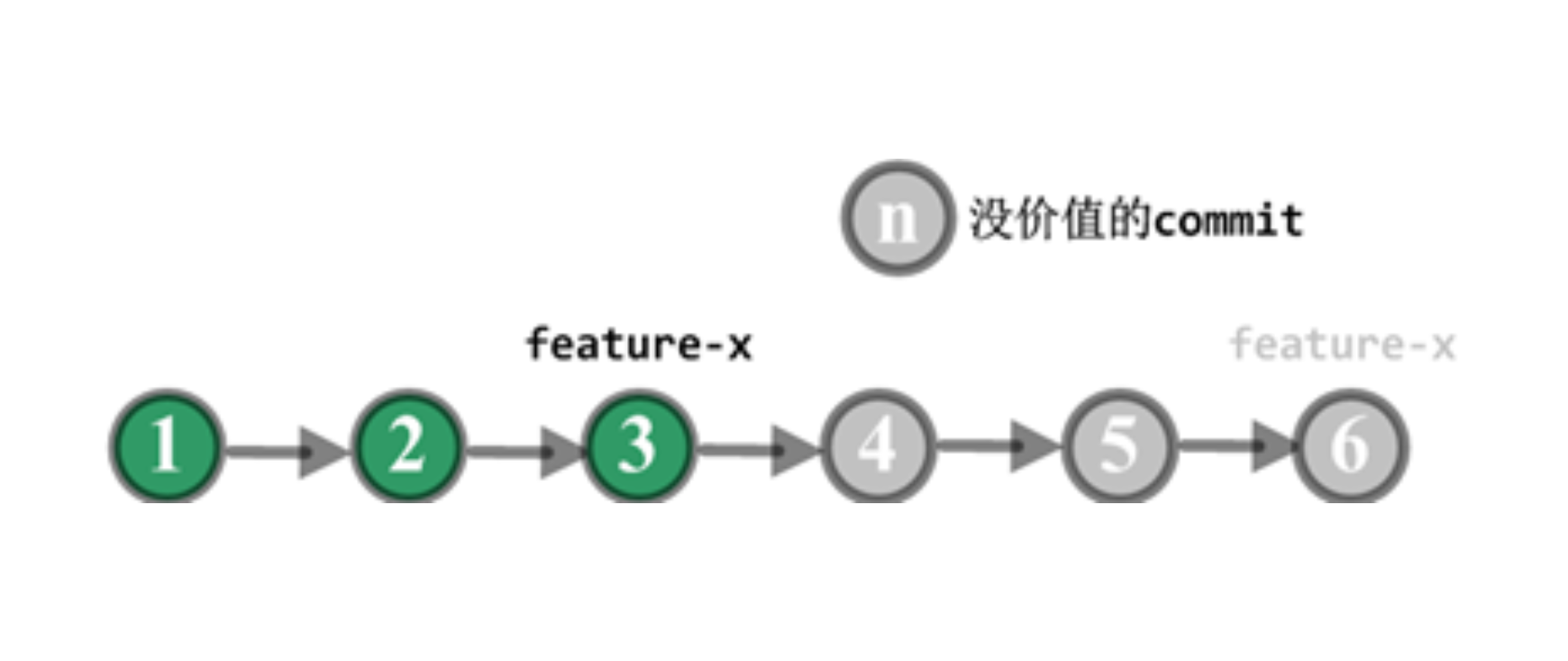

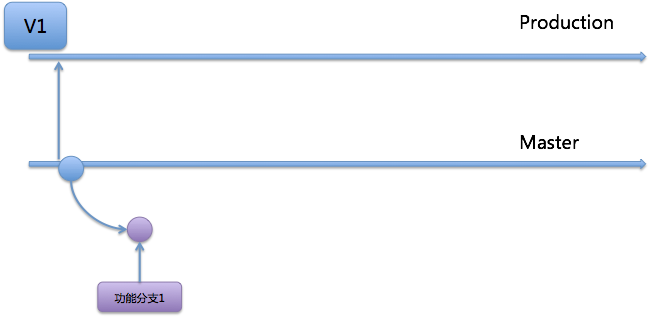

第一种情况:开发人员独立使用的分支上,如果最近产生的 commit 都没有价值,应该废弃掉,此时就需要把代码回滚到以前的版本。 如图 1 所示。

图 1 个人分支回滚

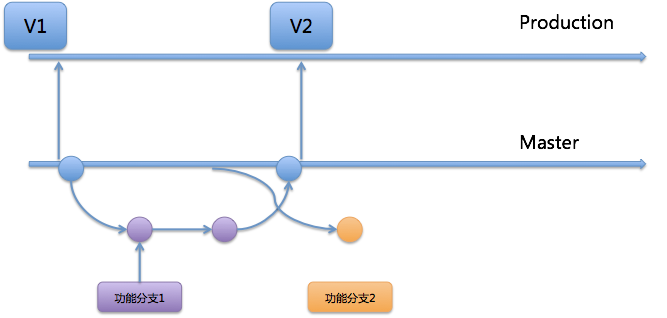

第二种情况:代码集成到团队的集成分支且尚未发布,但在后续测试中发现这部分代码有问题,且一时半会儿解决不掉,为了不把问题传递给下次的集成,此时就需要把有问题的代码从集成分支中回滚掉。 如图 2 所示。

图 2 集成分支上线前回滚

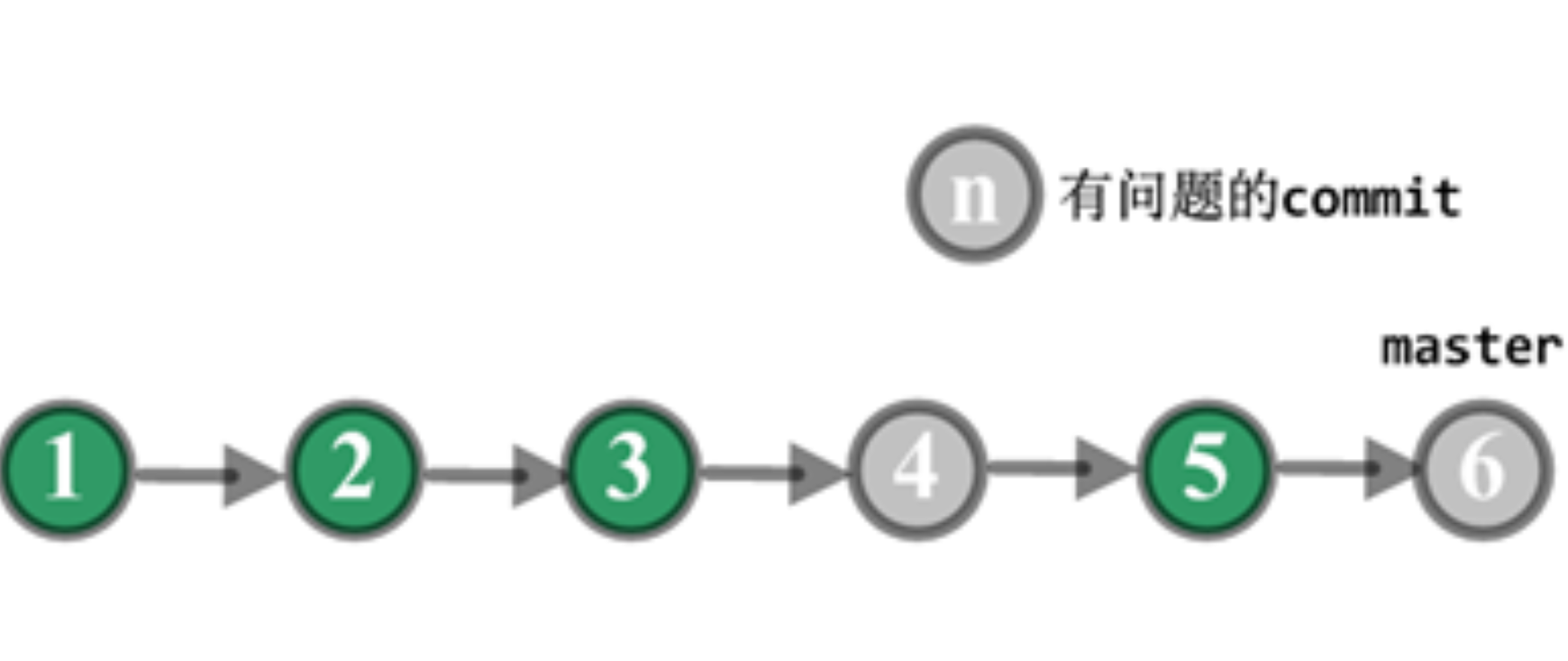

第三种情况:代码已经发布到线上,线上包回滚后发现是新上线的代码引起的问题,且需要一段时间修复,此时又有其他功能需要上线,那么主干分支必须把代码回滚到产品包 V0529 对应的 commit。 如图 3 所示。

图 3 集成分支上线后回滚

哪些情况下包的回滚无需回滚代码?

- 线上回滚后,查出并不是因为源代码有问题。

- 下次线上发布,就是用来修复刚才线上运行的问题。

代码回滚必须遵循的原则

集成分支上的代码回滚坚决不用 reset –hard 的方式,原因如下:

- 集成分支上的 commit 都是项目阶段性的成果,即使最近的发布不需要某些 commit 的功能,但仍然需要保留这些 commit ,以备后续之需。

- 开发人员会基于集成分支上的 commit 拉取新分支,如果集成分支采用 reset 的方式清除了该 commit ,下次开发人员把新分支合并回集成分支时,又会把被清除的 commit 申请合入,很可能导致不需要的功能再次被引入到集成分支。

三种典型回滚场景及回滚策略

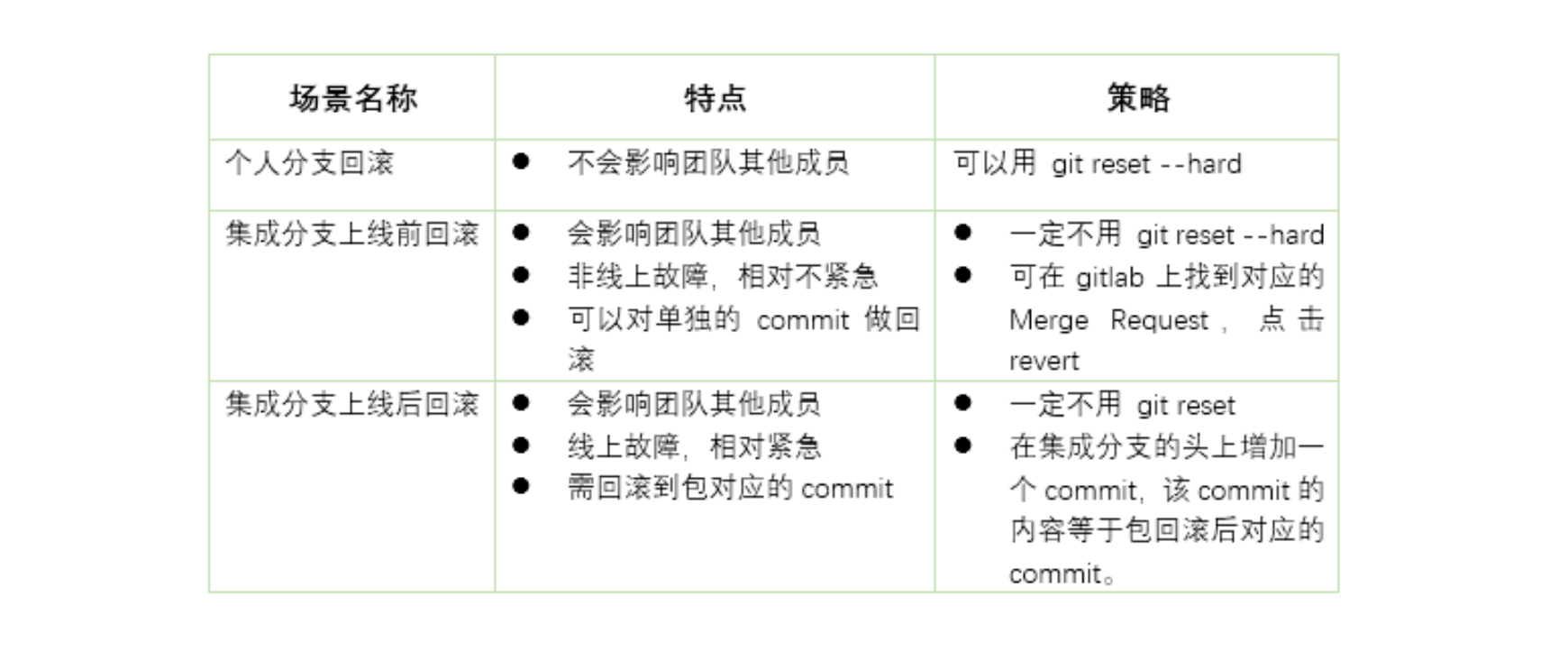

在上面的内容中,我给你提到了个人分支回滚、集成分支上线前的回滚,以及集成分支上线后的回滚,这三种需要代码回滚的场景,它们具有一定的代表性。

现在,我就先以表 1 的形式,针对不同场景为你归纳不同的处理策略。后面的章节中,我再为你具体介绍每种场景的处理步骤。

表 1 需要代码回滚的三种场景对应的处理策略

第一,个人分支回滚

同图 1 个人分支回滚

针对图 1 的情况:

- feature-x 分支回滚前 HEAD 指针指向 C6 。

- 在个人工作机上,执行下面的命令:

$ git checkout feature-x

$ git reset --hard C3 的 HASH 值

如果 feature-x 已经 push 到远端代码平台了,则远端分支也需要回滚:

$ git push -f origin feature-x

第二,集成分支上线前回滚

同图 2 集成分支上线前回滚

针对图 2 中集成分支上线前的情况说明:

- 假定走特性分支开发模式,上面的 commit 都是特性分支通过 merge request 合入 master 产生的 commit。

- 集成后,测试环境中发现 C4 和 C6 的功能有问题,不能上线,需马上回滚代码,以便 C5 的功能上线。

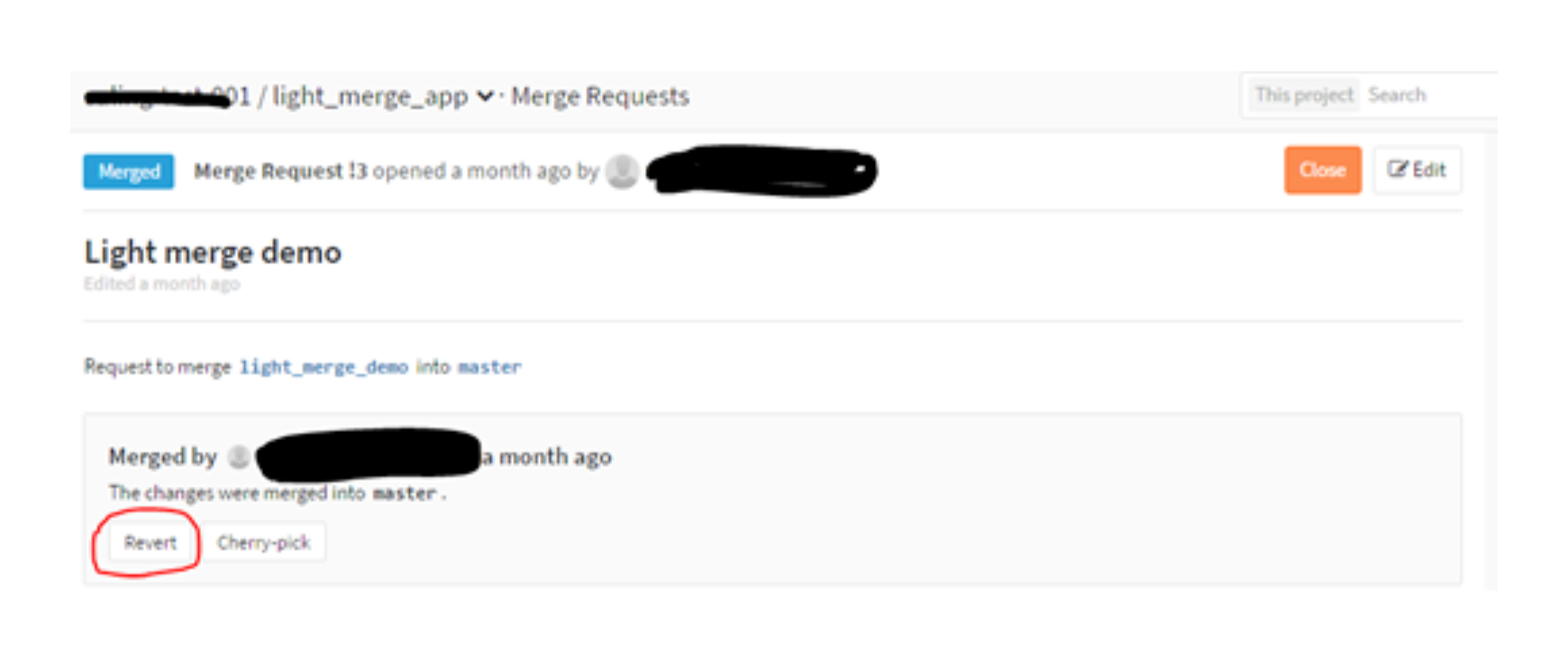

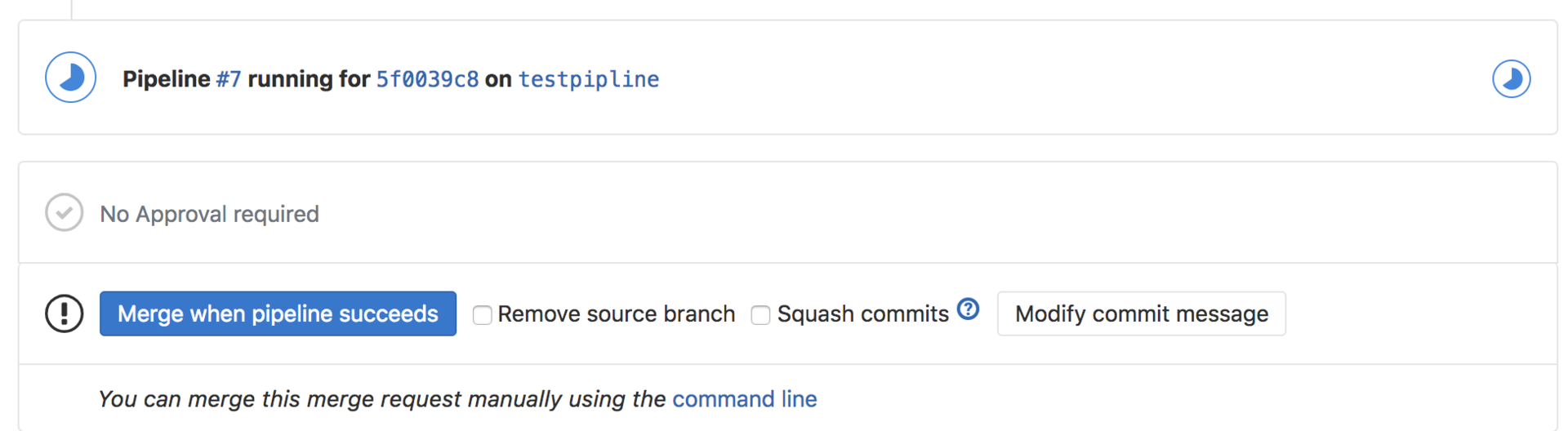

- 团队成员可以在 GitLab 上找到 C4 和 C6 合入 master 的合并请求,然后点击 revert 。如图 4 所示。

图 4 用 revert 方式实现回滚

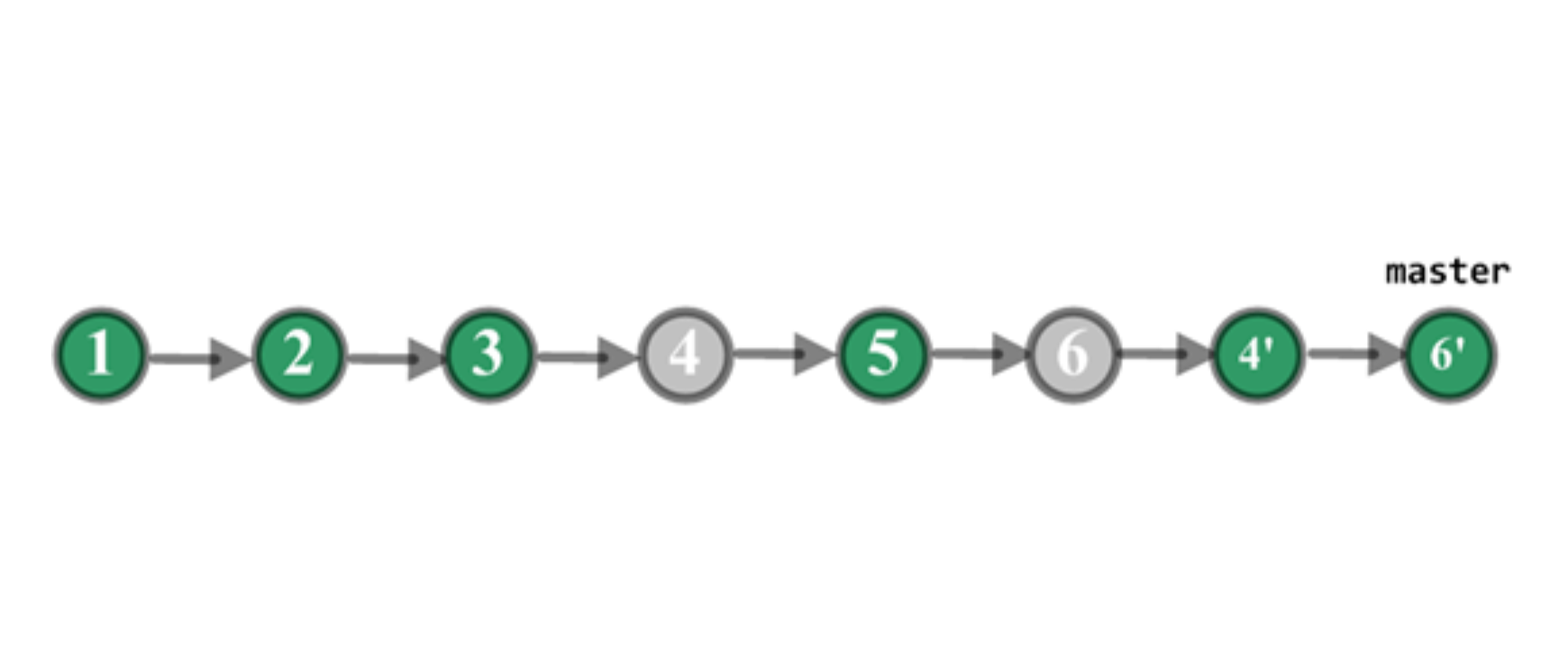

回滚后 master 分支变成如图 5 所示,C4’是 revert C4 产生的 commit,C6’是 revert C6 产生的 commit。通过 revert 操作,C4 和 C6 变更的内容在 master 分支上就被清除掉了,而 C5 变更的内容还保留在 master 分支上。

图 5 回滚后的示意图

第三,集成分支上线后回滚

同图 3 集成分支上线后回滚

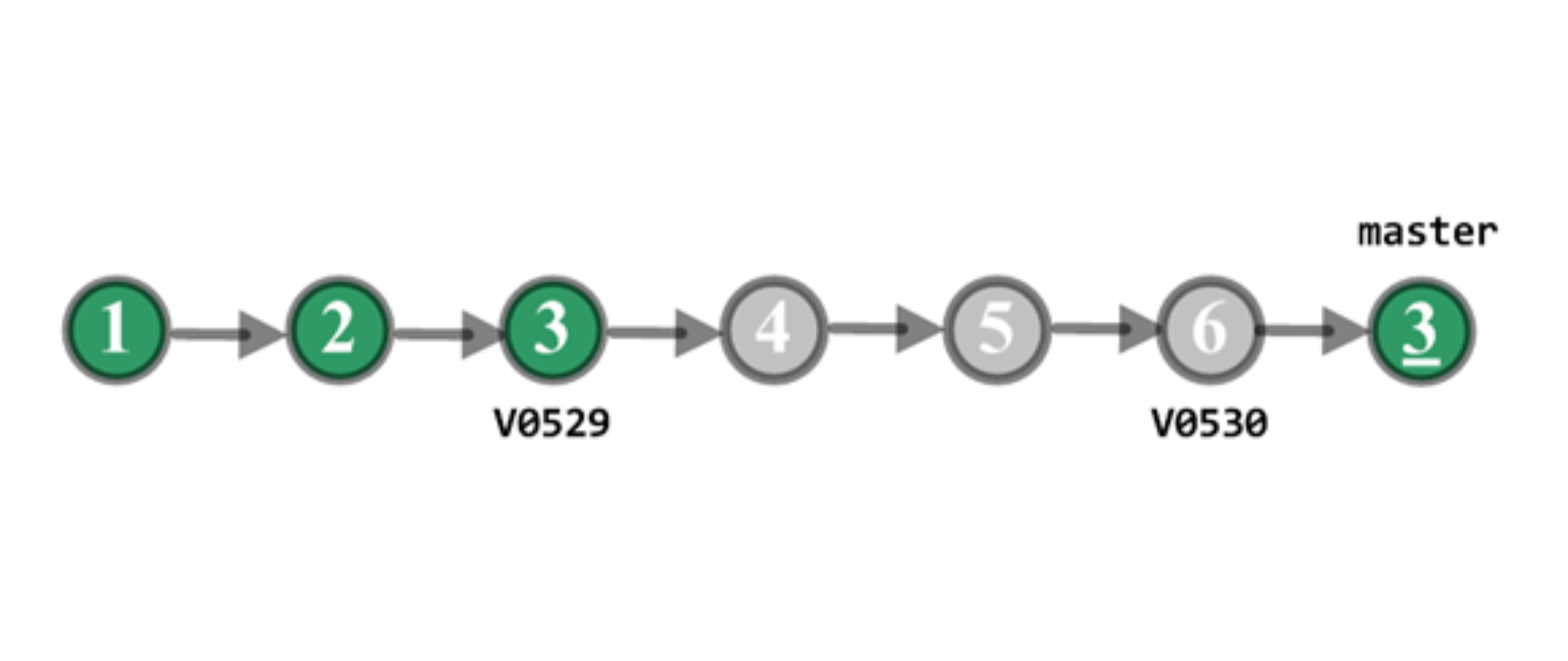

我先跟你说明一下图 3 中的具体情况:

- C3 打包并上线,生成线上的版本 V0529,运行正确。之后 C6 也打包并上线,生成线上版本 V0530,运行一段时间后发现有问题。C4 和 C5 并没有单独打包上线,所以没有对应的线上版本。

- 项目组把产品包从 V0530 回滚到 V0529,经过定位,V0530 的代码有问题,但短时间不能修复,于是,项目组决定回滚代码。

- C4 和 C5 没有单独上过线,因此从线上包的角度看,不能回滚到 C4 或 C5,应该回滚到 C3。

- 考虑到线上包可以回滚到曾发布过的任意一个正确的版本。为了适应线上包的这个特点,线上包回滚触发的代码回滚我们决定不用 一个个 revert C4、C5 和 C6 的方式,而是直接创建一个新的 commit,它的内容等于 C3 的内容。

- 具体回滚步骤:

$ git fetch origin

$ git checkout master

$ git reset --hard V0529 # 把本地的 master 分支的指针回退到 V0529,此时暂存区 (index) 里就指向 V0529 里的内容了。

$ git reset --soft origin/master # --soft 使得本地的 master 分支的指针重新回到 V05javascript:;30,而暂存区 (index) 变成 V0529 的内容。

$ git commit -m "rollback to V0529" # 把暂存区里的内容提交,这样一来新生成的 commit 的内容和 V0529 相同。

$ git push origin master # 远端的 master 也被回滚。

回滚后如图 6 所示。

图 6 回滚后的示意图

C3’的内容等于 C3,master 分支已清除 C4、C5 和 C6 的变更。

现在 master 又回到了正确的状态,其他功能可以继续上线。

如果要修复 C4、C5 和 C6 的问题,可以在开发分支上先 revert 掉 C3’ ,这样被清除的几个 commit 的内容又恢复了。

总结

代码回滚在持续交付中与包回滚一样,也是不可缺少的一项活动。但它并不是简单地去执行 Git 的 reset 或 revert 命令就可以搞定的事情。

除了开发的个人分支上存在回滚的情况外,我们还会遇到集成分支上需要回滚的情况;对于集成分支的回滚,又可以分为上线前和上线后两种情况;因为紧急程度和上线情况的不同,我们必须采用不同的回滚策略。

我围绕着开发工程师在代码管理中,最常遇到的 6 个问题,分别为你介绍了代码回滚的概念,梳理了需要回滚及不需要回滚的情况,分析了回滚的类别及其不同的回滚策略,提炼了回滚原则,希望能对你的实际工作有所帮助,保持正确的回滚姿势。

思考题

那么,接下来就是留给你的思考题了。

- 集成分支上线前,如果发现新提交的 5 个 commit 有 3 个需要回滚,请问,除了点击合并请求中的 revert 按钮这种方法外,还可以怎么做?

- 采用特性分支开发的一个项目,每个特性分支合入到 master 时都会产生一个合并的 commit,而且该项目是禁止直接向 master 做 push 操作的。可是该项目的 master 分支却存在多个非合并产生的 commit,请问这些 commit 很可能是怎么产生的?

- 持续交付平台如果要提供一键代码回滚的功能,每次回滚都要生成一个新的 commit 吗?即使以前已经产生过同内容的 commit 了,也要重建新的 commit 么?

07 “两个披萨”团队的代码管理实际案例

在亚马逊内部有所谓的“两个披萨”团队,指的是团队的人数不能多到两个披萨饼还不够吃的地步。也就是说,团队要小到让每个成员都能做出显著贡献,并且相互依赖,有共同目标,以及统一的成功标准,这样团队的工作效率才会高。

现在有很多互联网公司喜欢采用“两个匹萨”团队的模式,你可能很好奇,这些团队通常是如何实施代码管理的?

当前国内互联网公司通常采用特性分支开发的模式,我在第四篇文章《一切的源头,代码分支策略的选择》中,为你详细介绍了这种模式,下面我就以这种模式为例,为你解开困惑。

以迭代周期为一周的项目为例,我将按照从周一到周五的时间顺序,通过整个团队在每天的工作内容,跟你分享项目任务分配,分支创建、集成与分支合并、上线,包括分支删除的关系。你可以从中了解互联网公司研发团队日常代码管理的真实情况,体会团队为了提高研发效率,在代码管理上做出的创新与改进。

背景

周一上午 11:30,“复仇者” 团队的周会结束,会议室里陆续走出了 6 名工程师:

- “钢铁侠”:5 年一线开发经验,现任“复仇者”项目经理及产品负责人;

- “美国队长”:6 年开发经验,负责“复仇者”项目的技术架构,兼开发工作;

- “绿巨人”:3 年开发经验,全栈开发;

- “雷神”:3 年开发经验,全栈开发;

- “蜘蛛侠”:1 年开发经验,负责几个成熟模块的维护;

- “黑寡妇”:资深测试工程师,负责系统集成与测试。

其他同事泡咖啡喝茶的时候,“钢铁侠”在公司的 GitLab 上已经把 issue 分配给了团队成员,预示着忙碌又充实的一周要开始了。

周一下午

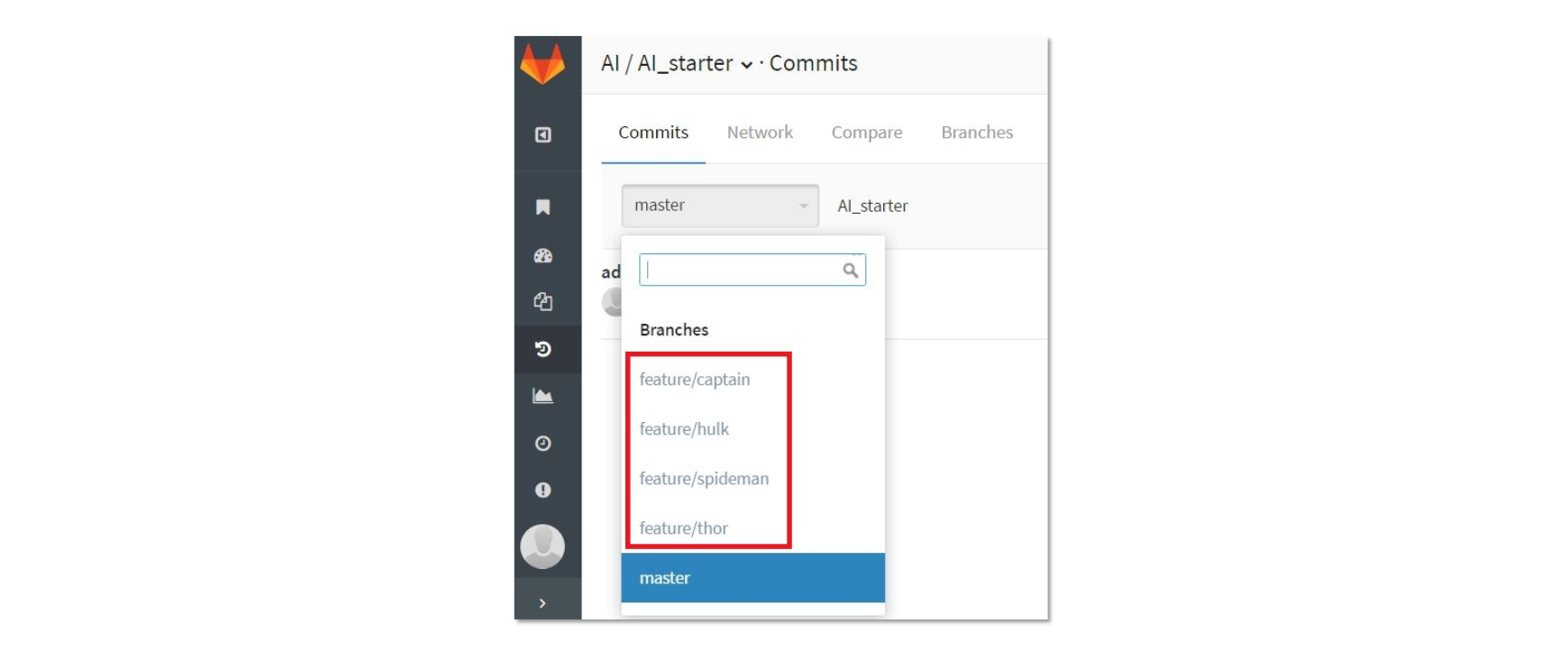

“美国队长”“绿巨人”“雷神”“蜘蛛侠”这 4 名开发人员早已熟悉团队的工作流程,午休之后,他们纷纷打开 GitLab 界面,在待办事项上找到自己的 issue,查看无误后,直接根据 issue 建好了新的特性分支。

每个新分支代表了一个具体的任务,待四人建好新分支后,“钢铁侠”不由得微微一笑,心想:哈哈,任务都被大伙儿认领了,看样子,他们下午就要开工啦。这 4 名开发人员新建的 4 个分支,如图 1 所示。

图 1 开发人员新建的 4 个分支

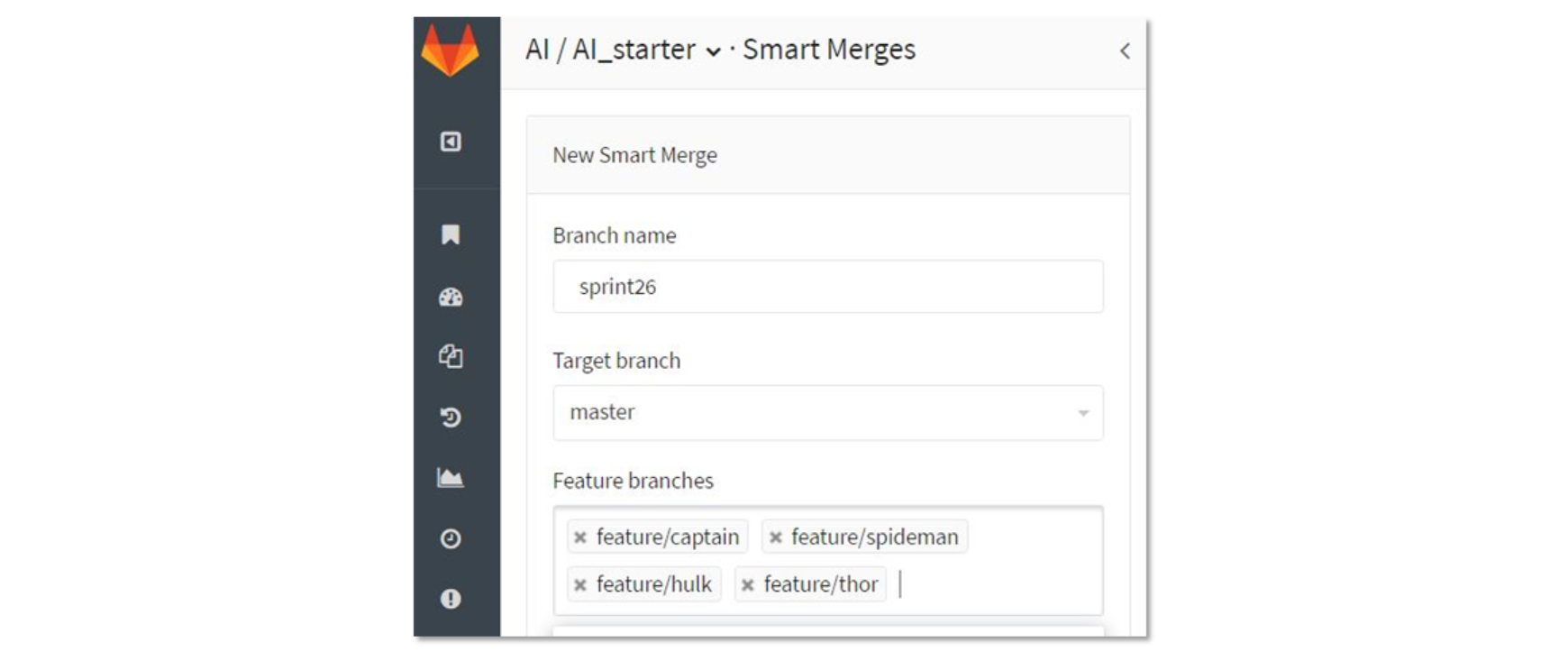

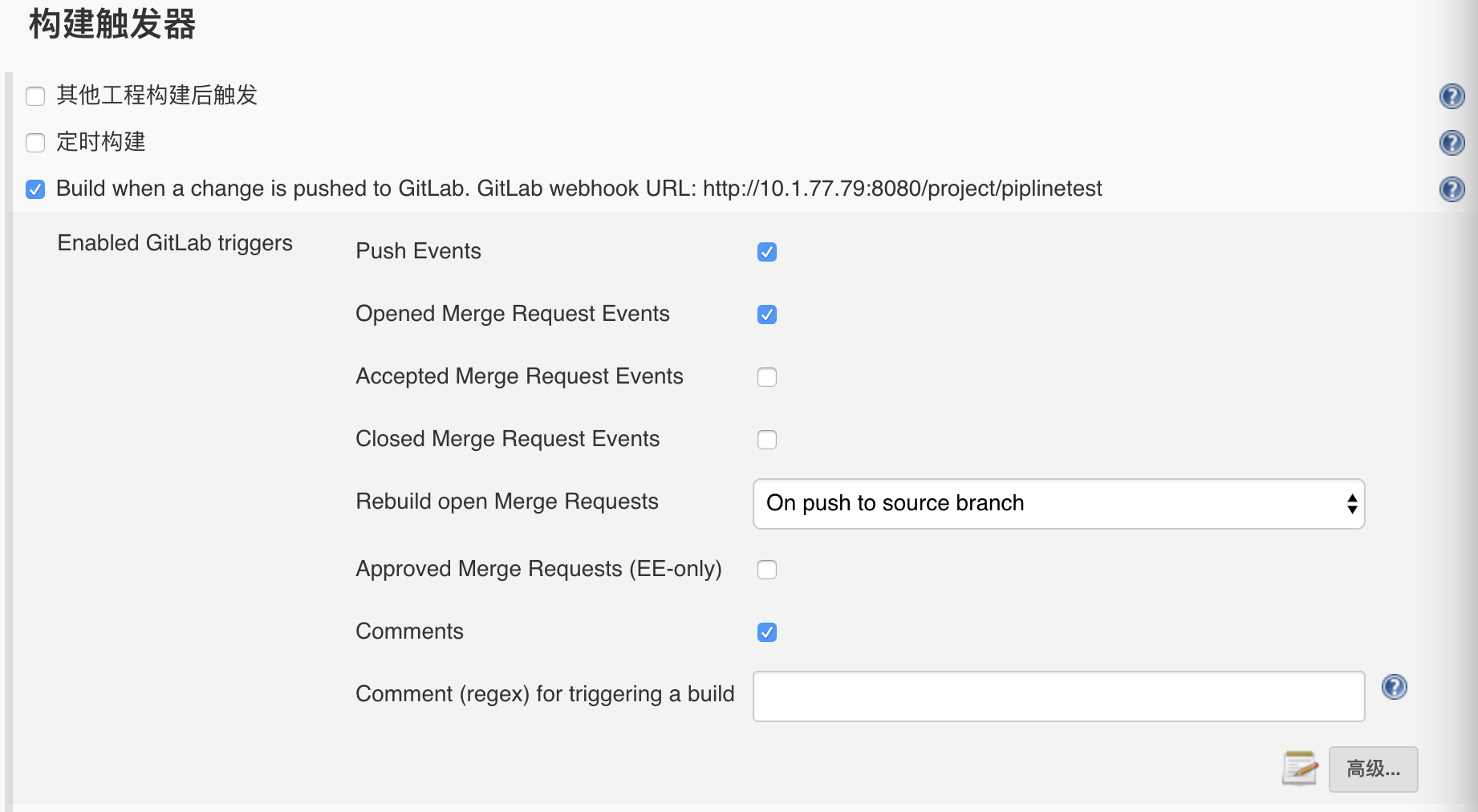

这时,资深测试工程师“黑寡妇”也没闲着,开始查看起本周计划完成的 issue,整理出功能点、性能要求和粗粒度的接口列表,基本明确了测试范围。随后,她在公司 GitLab 平台上为本周迭代设置好了“Smart Merge”,如图 2 所示。

图 2 配置 Smart Merge

要是有新人加入团队,“黑寡妇”肯定会向他推荐这个“Smart Merge”(Smart Merge是我和几个好友一同开发的 GitLab 插件,其作用是高效地解决分支合并的一系列问题)。高效的工作习惯使得“黑寡妇”早已整理好了说明文档,以便随时分享给其他同事。

有了 Smart Merge,任何一个分支的变更会自动触发合并,一旦出现冲突,开发人员就会立刻收到邮件通知。

周一下班前,4 位开发人员分别把各自的本地分支 push 到了 GitLab 平台。集成后没有冲突,大家开开心心回家了。

周二

“美国队长”起了个大早,9 点半就到公司了,昨天他已经实现了核心功能,今天要完善这些功能并升级 API。他忙了个把小时,本地开发自测完成,并把本地 feature/captain 分支 push 到了 GitLab 服务器。

一分钟不到,“美国队长”的邮箱收到了 GitLab 发来的通知,告诉他刚提交的某两个文件和 feature/hulk 分支发生了冲突。

“美国队长”知道肯定是黑寡妇创建的 Smart Merge 帮助自己快速发现了冲突,他直接用 GitLab 的 compare 功能对比了 feature/captain 和 feature/hulk 这两个分支,找到了冲突所在的行。

通过分析,“美国队长”判断出 feature/hulk 的变更是合适的,这个冲突应该由他解决掉。

“美国队长”选择在本地对自己的分支执行 git rebase -i ,把引入冲突的 commit 进行了变更,自测通过后,再次把 feature/captain 分支 push 到了 GitLab 。为了确保冲突的问题已经被解决,他打开了 Smart Merge,发现状态是“已合并”(Merged) ,这才端起杯子泡咖啡去了。

上午 10:00 前后,“绿巨人”等人也陆陆续续到公司了。团队已经约好了协作节奏:每周四下班前完成一个迭代的上线。

通常周二下午开发人员要把每个 issue 的基本功能开发好,“黑寡妇”周二下午会给 Smart Merge 配置好持续交付的环境,一旦某个分支 push 后,自动完成分支合并,然后自动编译、打包,并部署到测试环境。

在测试环境上,除了跑自动化测试外,“黑寡妇”也会手工做一些集成测试和性能测试。

周二下午,“美国队长”开始 review 大家的代码,他把本周开发的 4 个分支,在 GitLab 上分别创建了 4 个 merge request,目标分支都是 master 。

“美国队长”觉得 GitLab 的 review 功能很完善,交互也很便捷。这时,其他 3 名开发人员,忙着写代码和自测。“黑寡妇”除了搭建测试环境外,还补充了自动化测试的用例。

周三

经过周一和周二的努力,本周的基本功能均已实现,“黑寡妇”开始对系统实施集成测试,并做一些压力测试。

上午测试时,“黑寡妇”发现在某些场景下系统存在较大的延迟,这个问题在上周的版本中并不存在。她判断是本周新引入的功能导致了这个问题,但一下子又很难确定是怎么引起的。

于是,“黑寡妇”决定修改 Smart Merge 的配置,把嫌疑最大的分支剔除掉后再打包测试。通过这样的方式,最后查出是 feature/thor 这个分支引入的问题,她把测试情况详尽地告诉了“雷神”。

大半个下午雷神都在查问题,到下午四点钟时,问题终于被“雷神”修复了,他把 feature/thor 分支做了 push,然后向“黑寡妇”求助,请她合入自己的分支后再帮忙做测试。

“黑寡妇”把“雷神”的分支重新加回到 Smart Merge 中,并把编译包重新部署到了测试环境。经过测试验证:延时大的问题真的不见了。

下班前,“黑寡妇”召集项目组开了个简短的质量会议,大家商量后认为本周计划内的四个开发任务集成后没有大的质量问题,周四可以一起上线。

会后,“黑寡妇”看了看本周的四个合并请求,“美国队长”对四个请求意见都是赞成合入 master,Sonar 检查也都合格,加上自己测下来质量也过关,于是,她果断地接受了四个合并申请。

在回家前,master 对应的最新 commit 已经顺利地编译、打包后被发到用户验收测试环境,“黑寡妇”对这个环境启动了自动化测试服务。

至此,测试加修复 Bug,忙碌了一整天,大家终于可以回家休息了。

周四

“黑寡妇”一早上班时,首先查看了自动化测试的结果,显示 master 分支构建出的包符合质量要求。于是,她又对没有设计自动化测试用例的部分,进行了手工测试,发现几个界面上存在文字描述的问题,随后通知开发做修复。

开发在本地分支上修复问题后 push 到 GitLab,再次发起合并请求,“黑寡妇”逐个接受了这几个 Fix 的请求。

到中午时分,用于上线的产品包终于生成了。

等到发布窗口开启时,“黑寡妇”通过公司的发布系统把合格的产品包发布到了线上。观察一段时间,线上运行都正常。

对应本次上线,“黑寡妇”及时给 master 打了 tag,然后把本周成功发布的消息通知到项目组,并向“钢铁侠”做了汇报。

“钢铁侠”看大伙儿忙碌了这么多天,豪爽地请大家喝果汁,并告诉大家他又有几个紧急的用户需求,嘱咐大伙下周继续努力。

周五

通常在这一天,项目组会一起清理过期的分支,删除本周已合并到 master 的分支。而对于下周开发的新分支,项目组约定统一从 master 上拉取。另外,利用这一天,项目组也会召开回顾和改进会议,以讨论解决目前的一些已有问题的方案,这些讨论即包含工作流程问题,也包含代码和系统等问题。

总结

我介绍了由 6 人组成的“两个披萨”团队代码管理的实践,通过周一到周五的具体活动,你可以看到采用特性分支开发的团队是如何创建分支、集成分支和删除分支的,希望能对你的日常工作也有所帮助。

思考题

假设有 A、B、C 三个功能依次被合并到 master 并准备上线,此时发现 A 功能有问题,不能上线,而 B 和 C 则必须上线,此时你会采取什么办法来解决?

08 测试环境要多少?从现实需求说起

在整个持续交付生命周期中,测试环境的易用程度会直接影响软件的交付速度,但因为以下两点,它又是最被容易忽略的一环。

- 我们总是把环境理想化,忽略了其管理的难度;

- 我们也很少设立专职的环境管理员,导致环境长期处于混乱状态。

通常,我们在项目初期并不会关注测试环境的问题,然而在回顾时却发现在环境问题上浪费的时间非常惊人:硬件资源申请困难,测试环境配置繁琐,测试应用更新困难,基础设施稳定性差,服务调用异常,多项目并行造成互相干扰等等问题。

而不管你是开发人员还是测试人员,相信你都或多或少地碰到过这些问题。

在接下来的《环境管理》系列文章中,我会和你聊聊构建一整套好的测试环境的关键点以及具体实施方案。今天,我就先跟你说说和测试环境相关的两个问题:

- 测试环境的结构一般是怎样的?

- 什么才是好的测试环境?

互联网公司测试环境的结构

当公司规模较小时,测试环境的维护相对容易。开发和测试共用一套数据库缓存等基础设施,因为应用数量不多,开发环境可以是单机的,无论是手动或半自动化的更新测试环境的应用,花费的时间都还在可接受范围内。

这时,公司环境的结构很简单,分为开发环境,测试环境,生产环境即可。

但实际上,我看到的大多数公司的研发过程及配套环境并没有这么简单,一般都会存在 5 套以上的大环境以及更多的子环境,每个环境的机器数量可能有数十台甚至更多。

那么为什么会需要这么多套环境呢?我把主要原因概括为了以下两个方面。

- 纵向上看,人员的增多提高了项目的并行度,如果这时还使用一套环境的话,就会发生以下问题:

- 开发同学在 debug 一个困难问题时,发现下游的应用突然就不可用了;

- 测试同学在跑了 10 多分钟测试脚本后,发现应用已经被开发更新掉了。 这样的体验是让人崩溃的。

- 横向上看,公司的应用架构逐渐转为微服务化,完整的应用数量很容易就达到了几百甚至几千个的量级,建立一套独立而完整的环境变得越来越复杂,往往是研发团队想要构建一套新的环境却构建不出来。

所以,目前互联网公司常见的环境模型一般分为开发环境,功能测试环境,验收测试环境,预发布环境,生产环境这五个大套环境。

第一,开发环境

微服务架构下,单机已经无法完整地运行业务应用,这就需要开发环境内包含一套完整的业务应用依赖以及相关的基础设施,以保证业务开发同学能在本地完成开发测试。

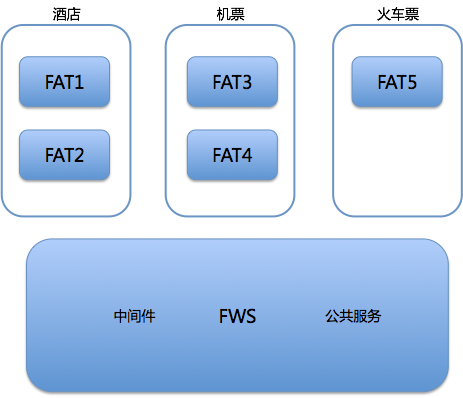

第二,功能测试环境

在开发环境下,每个下游依赖应用都只有一个可用的 stable 版本。而在实际的开发过程中,由于项目的并行开发,往往会同时存在多个可依赖的版本。而每个项目组的同学在测试时,都希望测试过程中的关键依赖应用是可以被独占的,版本是固定的,不会被其他项目组干扰。

所以,一套独立的功能测试环境就很有必要了。通常,互联网企业会通过中间件的方式分割出一块隔离区域,在功能测试环境中创建多个子环境来解决这个问题。

第三,验收测试环境

验收测试环境和功能测试环境是完全隔离的。当功能测试通过后,你可以在验收测试环境进行最终的验收。

它除了可以用作测试之外,还可以用作产品展示。所以,除了测试和开发人员,产品经理也是验收测试环境的主要使用者。

第四,预发布环境

到了预发布阶段,应用已经进入了生产网络,和真实的生产应用共享同一套数据库等基础设施。预发布是正式发布前的最后一次测试,在这个环境中往往可以发现线下环境中发现不了的 Bug。这个环境的运维标准等同于生产环境,一般不允许开发人员直接登录机器。

根据不同的业务需求和部署策略,不同公司对预发布环境的实现也有所不同:

- 一种比较常见的方式是,将金丝雀发布作为预发布,从接入真实流量的集群中挑选一台或一小组机器先进行版本更新,通过手工测试以及自动化测试和监控系统验证,降低新版本发布的风险。

- 另一种做法是,独立出一组始终不接入真实流量的机器,调用在预发布环境中形成闭环。

相对于第一种方式,第二种方式对生产环境的影响更小,但需要额外的资源和维护成本。

第五,生产环境

生产环境是用户真实使用的环境,对安全性和稳定性的要求最高。

什么是好的测试环境?

在和你分享什么是好的测试环境前,建议你先思考一下开发环境、功能测试环境、验收测试环境、预发布环境这四种测试环境形成的原因是什么,这样有利于你更好的理解好的测试环境的含义。

首先,搭建测试环境的目的是保证最终交付的软件质量,但每套测试环境的用户并不完全一样:

- 开发环境的用户是开发同学;

- 功能测试环境的主要用户是测试同学;

- 验收测试环境的用户是产品经理和测试同学;

- 预发布环境的使用者是测试同学,但收益者却是运维同学。

而每种角色对于产品研发流程中的需求也是不同的:

- 开发同学关注研发效率;

- 测试同学关注测试的可靠性;

- 产品经理更关注的是真实的用户体验和产品的完整性;

- 预发布环境的需求其实来自于运维同学,他们需要保证生产环境的稳定性,减少生产环境的变更,所以需要将预发布环境与线下环境完全隔离。

如果你是一位测试环境治理工程师,在规划测试环境以及开发和实施工具的时候,最关键的就是要考虑到不同环境的主要用户是谁,环境要做成什么样才能满足用户在研发流程中的需求。当用户不用发愁环境问题时,研发效率也就自然而然地上去了。

当然,不论一套环境用户是测试同学还是开发同学,以下几个需求都是必须被做到的。

- 可得性,即在开发一个新项目时,能快速获取构建一个环境需要的机器,基础设施。最好的情况是,能随时可得,随时归还。

- 快速部署,即在搭建新环境时,能以最快的速度构建出一整套完整的环境。测试环境的部署很频繁,在代码提交后,能在很短的时间内构建代码,在环境上更新,就能更早开始测试。

- 独立性,即一个环境在使用过程中,可以不受其他项目测试人员的干扰。

- 稳定性,即不会因为下游服务,基础设施的异常,造成测试中断、等待。

- 高仿真,主要分为两个方面:“测试数据真实”,即能在测试环境构建出真实的测试用例;“环境真实”,即基础服务的架构和行为与线上环境保持一致,避免因为环境不一致造成测试结果不一致。

但是,毕竟各个环境的用户和使用场景不同,它们的需求也是有差别的。 比如,相对于开发环境,验收测试环境对测试数据的仿真性要求会更高,而开发环境的灵活性,决定了不会过于严格的维护测试数据的真实性。

所以,如何评价一个好的测试环境,就是看它是否最终满足了核心使用者的需求。

总结

通常,互联网公司的环境会包括:开发环境、功能测试环境、验收测试环境、预发布环境和生产环境这 5 套。

测试环境的目的是要保证最终将交付的软件产品的质量,所以好用的测试环境,不能从规模、性能和作用的角度来评判,而应该是从它能否满足用户需求去保证软件质量的角度进行定义,于是得出:

当一个环境可以满足其真正核心用户的需求时, 就是一个好用的测试环境。

除此之外,你还需要理解,环境是昂贵的,不仅涉及单一的机器资源成本,环境副本数的增加也意味着更难管理,更复杂的流程,所以仅仅考虑单套使用者的体验是不够的。

那么,在我的下一篇文章中,将会分享多环境带来的成本问题,以及如何在成本、效率、可管理之间权衡取舍。

思考题

- 请你思考一下测试环境中最让你痛苦的一点是什么?

- 如果让你来优化测试环境, 你会如何去改善这最让你痛苦的一点?

09 测试环境要多少?从成本与效率说起

在上一篇文章中,我分享了互联网公司测试环境的常见结构,以及对用户来说什么样的测试环境才是好用的。然而对测试环境来说,只是高效好用还不够,还要考虑到成本问题。

效率和成本永远是一对矛盾体。今天,我就从成本和效率出发,和你聊聊构建测试环境时,还需要考虑的其他维度。

测试环境的成本

谈到环境成本,你很自然地就会想到云计算,《持续交付:发布可靠软件的系统方法》一书出版时,云计算还是一个时髦的概念,而 8 年后的今天,云技术已经非常成熟了。

今天,部分传统企业和互联网企业都在选择混合云架构,而创业公司选择公有云已经有了点模式化的意味。公有云非常好地满足了 DevOps 的“基础设施即代码”的理念,哪怕你完全不使用公有云,那在环境中整合开源的私有云技术依然能为你带来不少便利。

然而,云计算并非“银弹”,我们上云后,在成本上,还是有很多值得去思考和做的事情。

尤其是当环境数量增加时,你很容易就可以想到成本会增加,但是你可能并不明白要增加哪些方面的成本,以及会增加多少的问题。那么,接下来,我就跟你聊聊当环境数量增加时,你需要考虑的成本有哪些呢?

首先是机器资源成本

保证环境的独立性,是你构建更多套环境的一个主要原因。但是,一套独立的、拥有完整链路的环境成本是非常高的。

那么,以阿里云的价格为例,我来跟你一起算算这笔账。假设一个只有 100 个应用的微服务架构环境,选取单应用单机 2 核 4G 内存的低配置实例方式进行部署,单实例的年价格在 2000 元左右,100 个实例的话,一年的花费就是 20 万元左右。

而这只是最保守的计算,随着服务规模的增加,以及更多环境的需要,整体花费上涨两个数量级也是很正常的。

这样的问题在开发环境和集成环境的表现是最明显的。为了保证这两套环境的独立性,你必然需要有很高的环境副本数。但无论如何,你都不可能让每一个开发和测试人员都拥有一套完整环境的硬件资源。

可见,每一套环境的机器资源成本都很大,而且随着需求的增加成比例增长。

其次是管理成本

管理成本,包括维护环境的可用性,配置的管理成本,和测试数据的维护成本三个维度。

- 维护多套环境的第一要点是,维护环境的可用性。 与云时代之前相比,容器技术已经解决了很多问题。比如,服务器操作系统级别的依赖的标准化更容易了;当出现硬件故障时,迁移和恢复服务也更加方便了。 但是,容器技术并没有解决故障定位的问题。微服务架构下集群的节点数量多, 调用链复杂,你不再能确定到底是环境问题,还是程序本身的 Bug,也就导致定位故障更加困难了。 所以,更多套环境就意味着更大的集群规模,出现故障的几率会随之增加,而解决故障也会占用你更长的工作时间。

- 维护多套环境的另一大成本是,配置的管理成本。 配置是环境管理中最核心的内容,创建一套环境时,为了保证它真正的独立可用,不仅要保证应用可以成功运行,还要保证应用在基础设施的配置是正确的。比如集成测试环境下部署了一个应用的多个平行项目,就需要有办法保证测试人员能访问到正确的应用。 如果是 Web 应用,你就要考虑把应用绑定到不同的域名,这样就会增加域名管理的成本;如果是一个 service 应用,你就要考虑到这些 service 不会被其他项目的、无关环境中的应用调用到,同时也不会调用到其他错误的服务。 每多一套环境,就会多一套这样的配置,而且这些配置都需要在各类基础设施中生效。

- 维护多套环境的第三大成本是,测试数据的维护成本。 测试数据也是环境中极为重要的一个组成部分。当并行环境的数量变多后,数据的维护同样是让人头疼的问题。 为了保证环境的高仿真,哪些环境共用一套数据库,以及测试数据的更新在多套环境中怎么执行等等,都需要非常高的管理成本。

最后是流程成本

流程成本主要包括沟通成本和测试成本两个方面。

- 沟通成本 每增加一套环境,你都需要考虑团队成员如何在新环境上沟通协作。谁在占用,何时退出这些信息,你都需要第一时间告知团队。当环境的数量变得非常多以后,做好这些事的难度就很大了。

- 测试成本 在开发环境,集成测试环境,验收测试环境,预发布环境,生产环境这样的结构下,核心功能的测试流程就至少会执行五次。每引入一套新的环境,测试流程都会变得更加复杂。

如何调解效率和成本的矛盾?

现在你应该已经意识到,因为增加一套环境带来的成本竟然有那么多。但是为了提高持续交付的效率,隔离的多套环境又是必不可少的。

那么,你究竟应该怎样去规划和设计环境呢?

第一,公共与泳道的

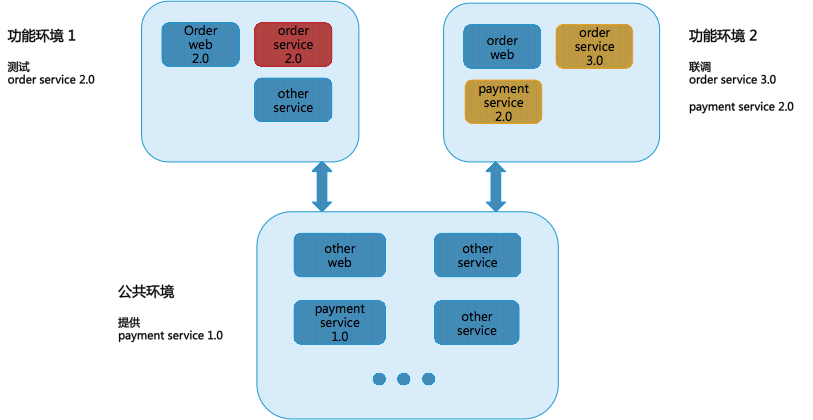

第一个关键点是抽象公共环境,而其中的公共服务基本都属于底层服务,相对比较稳定,这是解耦环境的重中之重。 比如我们经常会将中间件,框架类服务,底层业务公共(账户,登陆,基本信息)服务部署在这套公共环境下。

在公共环境的基础上,可以通过泳道的方式隔离相关测试应用,利用 LB 和 SOA 中间件对路由功能的支持,在一个大的公共集成测试环境中隔离出一个个独立的功能测试环境,那么增加的机器成本就仅与被并行的项目多少有关系了。

为了帮助你理解,我跟你分享一个具体的案例。

比如,你有一个新的下单流程需要测试。你可以将“下单 web 2.0”和“下单 service 2.0”抽离出来,如图中的“功能环境 1”所示。并保证被剥离出的“下单 service 2.0”只能被当前环境内的 web 服务器调用。而“下单 service 2.0”所依赖调用的“支付 service 1.0”则放在公共环境中。

于此同时,如图中所示的“功能环境 2”,可以同时支持“下单 service 3.0”这个并行版本与一个新版本的“支付 service 2.0”进行联调,此环境是不会调用公共环境中的“支付 service 1.0”的。

通过这种方式,你就可以解决并行开发和并行测试的问题了。

第二,避免产生多套公共环境

从原则上讲,集成环境中只要有一套公共环境就足够了。但有时候,你会发现项目的范围特别广,依赖应用或者影响应用特别多,特别是一些底层服务的改动或者重构等。在这种情况下,如果把依赖它的所有服务都部署起来,就很有可能变成第二、第三套公共环境了。

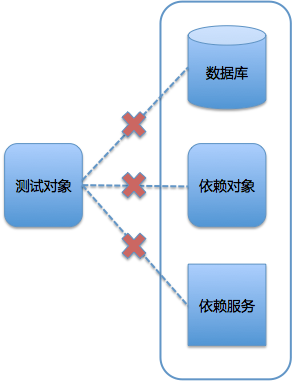

这种情况下,你可以通过 mock service 来模拟大多数服务,这样就可以达到测试环境的最小集合了。关于 mock service 如何做,我会在后续的讲解中,为你详细解释。

第三,减轻配置的复杂度

而对于减轻环境配置的复杂度来说,你可以从以下两个方面着手:

- 制定一套统一配置的解决方案;

- 要让环境自己说话,有效减少配置项。

比如,对于数据库,对于不同的测试需求,我们可能会在公共的数据库和独立的数据库之间进行频繁切换;又比如,我们可以在启动应用时自动配置正确的数据库。那么无论有多少套环境,配置也不是一件难事。

关于减轻配置的复杂度,我也会在专栏后续的讲解中,给你详细分析如何实现。

总结

我们究竟需要多少套环境,这个问题的答案应该是这样的:在大环境(开发、集成、验收)的数量上,你要考虑环境的核心用户是谁,环境的核心价值是什么。在环境的核心价值没有冲突时,尽量减少大环境的数量。

有些公司就通过功能分支直接上线的分支策略,对每个分支, 都创建一整套的功能测试环境,并在分支上线后快速释放。以这样的方式,精简了验收测试环境,即大环境的产生。但其代价是发布过程分支之间必须是串行的,即一个分支的上线会阻塞其他分支的上线。

而在每个大环境的子环境上(也就是按照测试需求被剥离出来的功能环境),你必须保证它的副本数可以满足用户测试的隔离需求。比如,在集成测试环境,只产生一套公共环境,并通过工具,支持隔离的功能测试环境的快速建立和销毁,让环境可以按需分配。

思考题

当你需要一套性能测试环境时,是独立出一套大环境还是作为一个子环境依附于某个大环境比较好?

10 让环境自己说话,论环境自描述的重要性

在前两篇文章中,我从现实需求、成本与效率的角度,分析了对环境管理者来说最重要的一个问题,即到底需要多少套环境来支撑持续交付。如果你已经从中能掌握了一些环境管理的窍门,那么你基本就可以搞定对环境管理的宏观把控了。

但是,除了宏观的把控和管理外,即使只有一套环境,你还是有可能陷入无穷无尽的细节工作中。因为在日常的环境管理过程中,环境配置才是工作的重头和难点。那么今天,我就来跟你详细说说有关环境配置的问题。

从我的实践经验看,要想把环境配置这件事做好,就是要做到让环境自己能说话。

要做到这点,首先需要定义配置的范围。

从面向的目标来看,环境配置大体上可以分为两大部分:

- 以环境中每台服务器为对象的运行时配置;

- 以一个环境为整体目标的独立环境配置。

服务器运行时配置

以一个 Java Web 应用为例,需要哪些运行时配置呢?

- 安装 war 包运行依赖的基础环境,比如 JDK,Tomcat 等。

- 修改 Tomcat 的配置文件,关注点主要包括:应用的日志目录,日志的输出格式,war 包的存放位置。Tomcat 的 server.xml 配置包括:连接数、 端口、线程池等参数。

- 配置 Java 参数,包括 JVM 堆内存的 xmx、xmn 等参数,GC 方式、参数,JMX 监控开启等。

- 考虑操作系统参数,比较常见的一个配置是 Linux 的文件句柄数,如果应用对网络环境有一些特殊要求的话,还需要调整系统的 TCP 参数等配置。

经过上面这 4 步,一个简单的运行时环境的配置就算是完成了, 可以开始运行一个程序了。是不是感觉有点复杂呢?

而这,对正常的运行时配置管理来说,只不过是冰山一角而已。

我们不光要考虑单个实例初始化配置,还要考虑每次 JDK、Tomcat 等基础软件的版本升级引起的运行时配置的变更,而且这些变更都需要被清晰地记录下来,从而保证扩容出新的服务器时能取到正确的、最新的配置。

另外,对于一个集群的服务器组来说,还需要强制保证它们的运行时配置是一致的。

独立环境配置

独立环境配置的主要目的是,保证一个环境能够完整运作的同时,又保证足够的隔离性,使其成为一个内聚的整体。

所以,要让一个环境能够符合需求的正常运作,你需要考虑的内容包括:

- 这个环境所依赖的数据库该如何配置,缓存服务器又该如何配置。

- 如果是分布式系统,或者 SOA 架构的话,就需要考虑服务中心、配置中心等一系列中间件的配置问题。

其中,最为重要的是配置中心的配置。只有先访问到正确的配置中心,才能获取到其他相关的环境配置或者应用配置信息。也就是说,如果配置中心的配置错了,那么环境就会陷入混乱状态。

- 要考虑访问入口问题。 这套环境的入口在哪里?是一个站点还是一个服务入口? 如果是一个站点的话,那这个站点的访问域名就需要被特殊配置。如果这是一个内部环境的话,那么这个内部域名的 DNS 解析也需要被配置。如果这套环境中有多个 Web 应用,那么你就要考虑 7 层路由的配置问题了。

- 还要配置环境对应的基础服务,比如监控,短信,搜索等。

读到这里,如此多的与环境有关的配置,有没有让你觉得太复杂了。

再想象一下,如果你的环境要承载多种语言栈,各类应用依赖的基础软件也不同,环境和环境之间有各种关联设置,数据库的连接分配,环境中负载均衡的设置,等等。是不是让你感觉有些焦虑?

如果每天都要和这样的工作做斗争,那简直就是一场噩梦。更别提在这样的环境下,完成持续交付了,那简直就是难如登天。

虽然环境配置有这么多糟心的待处理事项,但是环境本身也是一个非常强大的工具,本身包含非常多的信息,如果这些糟心的事情环境能和你一起来解决,那就简单了,也就是我所说的让环境自己来说话,那么接下来就看看怎么做到吧。

环境一定要标准化

解决复杂问题的办法,无非是先将其分解,再将其简单化,对环境配置这个难题来说也是同样的道理。想要解决它,首先得要想办法分解、简化它。

最好的简化方法,莫过于标准化了。所谓标准化,就是为了在一定范围内获得最佳秩序,对实际的或潜在的问题制定共同、可重复使用的规则。

标准化也就是让环境学会了一门统一的语言,是自己说话的前提。

按照这个思路,我们首先可以实现对语言栈的使用、运行时配置模板、独立环境配置的方法等的标准化:

- 规定公司的主流语言栈;

- 统一服务器安装镜像;

- 提供默认的运行时配置模板;

- 统一基础软件的版本,以及更新方式;

- 在架构层面统一解决环境路由问题;

- 自动化环境产生过程。

看到这里,你可能感觉需要标准化的内容也是多种多样的,而且每个公司的具体情况也不同,那么标准化实施起来也必定困难重重。

从我的实践经验来看,建议你在实施持续交付的同时,去推动形成以下几个方面的规范:

- 代码及依赖规范;

- 命名规范;

- 开发规范;

- 配置规范;

- 部署规范;

- 安全规范;

- 测试规范。

其实,不管是持续交付还是架构改造,标准先行都是技术实施的前提条件。

约定大于配置

讲到这里,你可能也会疑惑了,和环境有关的内容实在是太多了,即使有了标准化,怎么可能都通过配置实现呢?

举个例子,代码的部署路径,标准化后所有服务器的路径都应该遵循这个标准,但是不可能在每台服务器上都去定义一个配置文件或环境变量来标示它,也没有这个必要。

实际上,你也从来都没有疑惑过部署路径的问题,因为从你来到公司起,它就已经是约定俗成了。而且,每家公司都是这样的,难道不是吗?

像代码的部署路径这种情况,我们就把它叫作“约定大于配置”,在实际工作中,还有很多类似的场景,你完全可以利用这套方法,简化环境配置。

比如,每个环境的域名定义,可以遵循以环境名作为区分的泛域名实现;又比如,可以用 FAT,UAT 这样的关键词来表示环境的作用;又比如,可以约定单机单应用;再比如,可以约定所有服务的端口都是 8080。

“约定大于配置”的好处是,除了简化配置工作外,还可以提高沟通效率。 团队成员一旦对某项内容形成认知,他们的沟通将不再容易产生歧义。

“约定大于配置”相当于赋予了环境天生的本能,进一步加强了环境的自我描述能力。

让环境自己能开口说话

有了环境标准化,以及约定大于配置的基础,你就可以顺利地让环境自己开口说话了。

也就是说,通过环境的自描述文件,让环境能讲清楚自己的作用、依赖,以及状态,而不是由外部配置来解释这些内容。

以一台服务器为例,一旦生成,除了不能控制自己的生死外,其他运行过程中的配置,都应该根据它自身的描述来决定。

那么,如何让服务器自己说话呢?

首先,需要定义 Server Spec。

这是重中之重,在服务器生成时,写入它自己的描述文件。我们通常把这个文件命名为“Server Spec”。在这个文件里,记录了这台服务器的所有身份信息,包括:IDC,型号,归属环境,作用,所属应用,服务类型,访问路径等。

其次,解决配置中心寻址。

中间件根据 Server Spec 的描述,寻找到它所在环境对应的配置中心,从而进一步获取其他配置,如数据库连接字符串,短信服务地址等等。

最后,完成服务自发现。

其实这就是一个服务自发现的过程。根据服务类型,访问路径等,还可以自动生成对应的路由配置,负载均衡配置等。

总结来说,我们是在尝试把环境配置的方向调个个儿:由原来外部通过配置告知环境应该干什么,转变成环境根据自身的能力和属性,决定自己应该去干什么。

这种尝试,标志着环境配置能力的质的飞跃。一台服务器可以实现自描述,你同样就可以把这个方法推广到所有服务器中。同理,一个环境可以实现自描述,你就可以把自描述的方式扩展到所有环境中。

从此,环境配置将变得不再艰难。

总结

我主要围绕环境配置的问题,讲了它的内容和一些特性,以及简化和优化的一些方案。

一定要意识到,环境配置是非常复杂的,直接影响你的环境治理能力,而环境治理能力又直接影响着持续交付的能力。但是我们还是可以通过:标准化、约定、自描述等方式去简化和优化环境配置工作。

我们的目标是,让环境自己能说话。

思考题

在你的公司,这些环境配置相关的工作由谁来完成?又由谁来为他们制造工具和提高工作效率?

11 “配置”是把双刃剑,带你了解各种配置方法

很多人分不清配置和配置管理,但其实它们是完全不同的概念。

配置管理: 是通过技术或行政手段对软件产品及其开发过程和生命周期进行控制、规范的一系列措施。 它的目标是记录软件产品的演化过程,确保软件开发者在软件生命周期的各个阶段都能得到精确的产品配置信息。

配置: 是指独立于程序之外,但又对程序产生作用的可配变量。也就是说,同一份代码在不同的配置下,会产生不同的运行结果。

从上面的定义中,你可以看到配置和配置管理有着本质上的不同:配置管理服务于软件研发过程,而配置则服务于程序本身。

作为一名程序员,开发时经常要面对不同的运行环境:开发环境、测试环境、生产环境、内网环境、外网环境等等。不同的环境,相关的配置一般不一样,比如数据源配置、日志文件配置,以及一些软件运行过程中的基本配置等。

另外,你也会遇到一些业务上的,以及逻辑上的配置。比如,针对不同地域采取不同的计费逻辑,计费逻辑又要根据这些地域的需要随时调整。

如果我们把这些信息都硬编码在代码里,结果就是:每次发布因为环境不同,或者业务逻辑的调整,都要修改代码。而代码一旦被修改,就需要完整的测试,那么变更的代价将是巨大的。

因此,我们往往会通过“配置”来解决这些问题。

但是,“配置”本身也很讲究。在什么阶段进行配置,采用什么手段进行配置,都将直接影响持续交付的效果。

那么,接下来我就跟你详细聊聊各种配置方法。

构建时配置

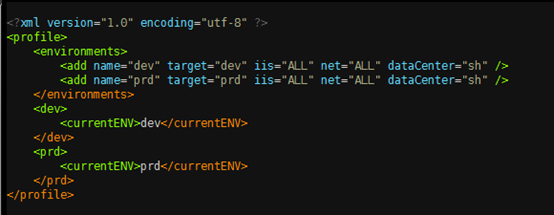

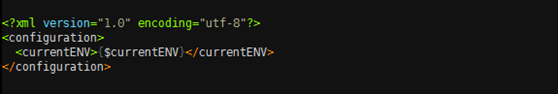

以 Maven 为例,实现多环境的构建可移植性需要使用 profile。profile 是一组可选的配置,可以用来设置或者覆盖配置默认值。通过不同的环境激活不同的 profile,可以实现构建的可移植性。 我们可以看一个简单使用示例:

这段代码定义了 dev 和 prod 两个 profile(没有定义任何其他配置,实际使用中可按需定义任何配置),并且使用了 echo 插件验证 profile 是否生效,通过运行。

maven initialize –Pdev

或

maven initialize –Pprod

然后,可以看到输出:

[INFO] profiles.active = dev

或

[INFO] profiles.active = prod

其中, dev 是默认激活的,也就是说如果不填写任何 –P 参数,或者 –P 参数不为 dev 或者 prod,都会使用 dev 作为默认的 profile。

这样在代码构建时,你就可以根据具体需要选择对应的 profile 了。

这个方案看起来很简单, 但也有两个缺点:

- 它依赖于某个特定的构建工具,而且使用方法不统一。 什么意思呢?如果你不使用 Maven 作为构建工具,这个配置功能就失效了;而且对于跨平台、跨语言栈的支持也不友好。

- 每次都要重新编译,浪费计算资源。 即使你只是替换一些配置文件,并没有改动任何代码,但为了让配置生效,还是需要完成代码的整个构建过程,这就会在编译上花费大量的计算资源。

因此,为了解决这两个问题,通常会把“打包”这个过程拆解出来,并将它插入构建之后,接下来我就介绍一下“打包时配置”。

打包时配置

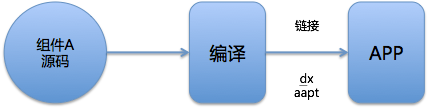

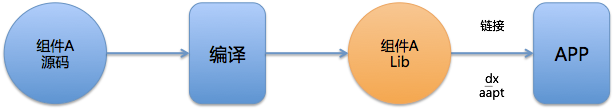

“打包”,是我在多年持续交付实践中总结出的一个非常重要的概念。我把打包过程与构建过程脱离,也就是说构建成功后,并不立即打包。而是把打包安排在发布之前,打包完成之后立即发布,打包就与发布过程形成了一个整体。

为什么要独立分离出打包这个步骤呢?你可能会问,Maven 在构建过程中不是已经完成了 package 步骤吗?

正因为构建时配置,需要针对多个 profile 编译多次,而持续交付有一个核心概念,即:一次构建多次部署。打包就是为了解决这个问题而被发明的。

打包时配置的基本思想是:构建时完全不清楚程序所要部署的环境,因此只完成最基本的默认配置;而发布时清晰地知晓环境信息,因此可根据环境信息,进行相关配置的替换。

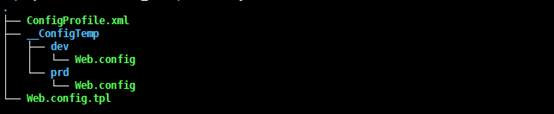

在携程,我们开发了一个叫作 ConfigGen 的工具,用以替换配置文件。 这样,你就不需要每次更改配置时,都重新编译整个代码,大幅缩短了整个发布流程的时间, 而且 ConfigGen 完全基于 XML,适用于任何语言。

ConfigGen 的使用也很简单,只要一个 ConfigProfile.xml 文件即可,dev 和 prd 指两个入参,根据这两个入参分别定义了 currentENV 的具体值,如下图所示。

其中,currentENV 节点便是该环境下的变量,然后在项目下面创建一些 TPL 文件,该文件就是最终生成的配置文件的模板,其中的占位符将根据之前 xml 中配置的值进行替换。比如,Web.config.tpl,如下图所示。

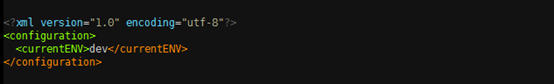

运行 ConfigGen 后,会在当前项目下生成一个 __ConfigTemp 目录,该目录下包含 dev 和 prd 两个目录,如下图所示。

所得到的 dev/Web.config 文件就是 Web.config.tpl 生成的最终配置文件。

从图中可以看出,Web.config 已经正确替换了 currentENV 变量。 __ConfigTemp 里面的配置文件目录结构与项目中 TPL 文件的目录结构是一致的。

利用类似于 ConfigGen 这样的工具,可以在打包阶段很好地解决不同环境的配置问题。但还是会有解决不了的痛点:

打包时配置,需要借助发布的力量使配置生效。而实际场景中,只是修改了配置就要发布代码往往是不被接受的。特别是,如果你还不具备很成熟的持续部署能力,那将会是很头痛的事情。

因此,为了更好地解决配置问题,绝大多数的互联网企业会推荐使用“配置中心”。如果你所在的公司还没有成熟的配置中心,那么我推荐尽快使用开源系统来搭建配置中心。下面,我就分享一下,配置中心是如何工作的。

运行时配置

随着程序功能的日益复杂,程序的配置日益增多,各种功能的开关,参数的配置,服务器的地址,等等不断增加到系统中。而且应用对程序配置的期望值也越来越高,需要配置系统能够:

- 修改后实时生效;

- 支持灰度发布;

- 能分环境、分集群管理配置;

- 有完善的权限、审核机制。

在这样的大环境下,传统的配置文件、数据库等方式已经越来越无法满足开发人员对配置的管理需求;另外,对于数据库连接串,各个服务之间的 API Key 等机密配置,如果放在代码里也会引起安全的问题。

针对以上的种种需求和问题,我们采用系统化、服务化的思想,引入了配置中心,尝试彻底解决配置问题。

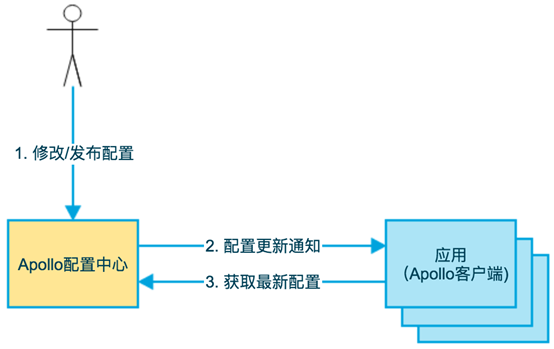

以携程为例,我们自研了 Apollo 配置中心,(目前该项目已经在 GitHub 开源)用以满足上述需求。

如下图所示,即是 Apollo 的基础模型:

- 用户在配置中心对配置进行修改并发布;

- 配置中心通知 Apollo 客户端有配置更新;

- Apollo 客户端从配置中心拉取最新的配置,更新到本地配置并通知应用重新载入配置。

Apollo 系统有几个特别突出的能力,能够很好地解决配置的问题:

- 统一管理不同环境、不同集群的配置,通过一个管理平台可以达到管理多个环境或集群配置的效果,省时省力;

- 配置修改实时生效(热发布),不再需要重启服务,与应用运行生命周期完全解耦;

- 版本发布管理,方便配置变更后的比对和追溯,配置变更有迹可循;

- 支持配置的灰度生效,减少配置错误所带来的故障影响;

- 客户端配置信息监控,这样有利于管理员进行集中式管理;

- 提供 Java 和 .Net 原生客户端。

使用配置中心的运行时配置,应该说是现在绝大多数企业选择的解决方案。而且,面对微服务的技术趋势,它也有一定的技术优势。比如,Apollo 就是 Spring Cloud 推荐使用的开源配置中心解决方案。

Apollo 有详尽的文档,其功能基本可以覆盖绝大多数业务对配置的需求,因此,我建议你也可以基于这套开源系统来搭建一套自己的配置中心,解决配置难题。

回滚是配置永远的痛

虽然配置中心已经很强大了,但是你也要清晰地认识到,配置中心不是万金油,比如对于版本回滚的情况:

当你使用构建配置和打包配置时,配置是随着代码的一起发布的。这样的话,如果代码回滚了,配置自然而然的也会跟着一起回滚,旧版本的代码和旧版本的配置在绝大多数情况下是兼容的。但如果你用了配置中心,配置就不会随着代码回滚,就可能引发意想不到的问题。

此时,先回滚配置还是先回滚代码就成了一个死循环的问题。最好的办法是保证配置与代码的兼容性,这有点类似于数据库的 schema 变更。 比如,只增加配置不删减配置、不改变配置的数据类型而是新增一个配置等方法。同时,也要做好代码版本与配置版本的对应管理。

那你可能会问,是不是只要做到代码和配置一起回滚就行了呢?其实不是,配置是一个很复杂的问题,像之前所说,绝大多数情况下,回滚配置能够兼容,但也有不行的时候。

比如,修改了数据库连接串的配置,代码回滚后还是要用最新的配置,如果配置也一起回滚了,反而会出现错误。

所以,对于配置回滚这个复杂问题,没有一劳永逸的办法, 只能根据实际情况选择最适合自己的方案。

但是,我有一个推荐做法就是,每次回滚时,将可能发生变化的配置进行 diff 操作,由负责回滚的具体人根据结果去做最后的判断。

总结

在这篇文章中,我和你讨论了三种配置方案:

- 构建时配置:会增加构建成本;

- 打包时配置:依赖发布生效;

- 运行时配置:配置中心,便于管理和维护。

我的建议是:业务相关的配置尽量放在运行时的配置中心服务里。

同时,一定要注意配置的回滚问题。因为,无论是回滚还是不回滚,它没有标准答案,这个复杂问题必须按当时情况作出相对应的处理。

思考题

在日常开发或者维护的系统中,你还遇到过哪些配置需要管理?你又是如何管理这些配置的呢?

12 极限挑战,如何做到分钟级搭建环境?

在上两篇文章中,我介绍了环境管理中最关键的几个概念,环境的标准化,让环境自己说话以及环境配置的几种方法。

今天,我分享的主题就是,如何从零出发, 实现一套完整的环境创建。并且尝试挑战一下,如何做到分钟级交付。毕竟,天下武功,无坚不摧,唯快不破。

环境构建流水线

当开发人员向你申请一套新环境时,作为测试环境的维护者,你首先需要明确打造环境构建流水线需要关注的三大内容:

虚拟机环境准备,根据环境的应用数、每个应用需要的硬件配置,准备好环境的硬件资源。

应用部署流水线,在标准化的虚拟机上进行应用部署,当出现问题时如何容错。

环境变更,在 SOA 或微服务的架构体系下,常常会因为测试的需求,将几套环境合并或拆分,创建环境时,你需要考虑如何高效地完成这些操作。

ol>

接下来,我会针对这三大内容进行展开,带你快速搭建一套环境。

-

虚拟机环境准备

在部署应用之前,我们首先需要创建应用部署的虚拟机环境。目前在携程,我们使用 OpenStack 做物理机和虚拟机的初始化的工作。

-

- 当物理机接到机架上以后,打开交换机端口,等待机器被发现后,调用 Nova 进行物理机基本的硬件配置。

- 物理机环境准备完毕后,从 OpenStack 获取虚机所需的镜像、网络等信息,调用 OpenStack API 进行虚拟机部署。虚拟机配置的一个关键点是,如何对网络进行配置。 携程的测试环境使用的是大二层的网络架构,配置简单。但如果你对测试环境的网络规划是,需要做每个测试环境的独立的网段切分的话,配置会更复杂。

- 虚拟机初始化后,需要在虚拟机上进行一些基础软件比如 JDK,Tomcat 的安装和配置。业界一般采用的方式是,通过自动化的配置管理工具来进行操作。 目前,市场上主流的开源配置管理工具有 Puppet、Chef、Ansible、SaltStack 等。这几款工具都能帮助你很好地处理配置问题,当然它们也有自己独特的设计思想,实现语言也不同,你可以根据自己的技术背景和要管理的环境情况挑选适合自己的工具。

讲到这里,你肯定会有疑问。虚拟机的初始化流程已经这么复杂了,这个过程已经远远不是分钟级了,那我在文章开始部分说的分钟级是如何实现的呢?

我的建议是,采用资源池的方案。你可以根据用户平时使用虚拟机的情况,统计每天虚拟机申请和销毁的具体数量,预先初始化一定量的虚拟机。 这样用户从上层的 PaaS 平台创建环境时,就不用等待初始化了,可以直接从资源池中获取虚拟机,这部分的时间就被节省下来了。

但是,采用资源池的方式也有一定的复杂性,比如机型多、资源使用率难以预先估计等问题,当然这些问题对云计算来说,可以被轻松搞定。

-

应用部署流水线

由于不同公司的中间件和运维标准不同,部署流水线的差异也会很大,所以这里我只会从单应用部署标准化、应用部署的并行度,以及流水线的容错机制,这三个关键的角度,分享如何提速环境的搭建。

-

- 单应用部署标准化,这是整个环境部署的基础。对一套测试环境而言,每个应用就像是环境上的一个零件,如果单个应用无法自动发布或者发布失败率很高,那么整个环境就更难以构建起来。而如何实现一个好的发布系统,提升单应用部署速度,我会在后面的文章中详细介绍。

应用部署的并行度,为了提高环境的部署速度,需要尽可能得最大化应用部署的并行度。理想的情况下,环境中的所有应用都可以一次性地并行部署。 然而,做到一次性并行部署并不容易,需要保证:应用都是无状态的,并且可以不依赖别的应用进行启动,或者仅仅依赖于基础环境中的应用就可以启动,且可以随时通过中间件进行调用链的切换。 在携程,我们力求做到所有应用都可以一次性并行部署,但这条运维标准并不通用。 当我们需要更复杂的应用部署调度规则时,一个原则是将应用部署的次序、并行方式的描述交给开发人员去实现,并基于 DevOps 的理念,即调度策略和规则可以通过工具代码化,保证同一套环境反复创建的流水线是一致的。

流水线的容错机制

。对于环境构建工具,通常的做法是力求做到全面的标准化、代码化。但是因为环境的创建本身是一个非常复杂的工作流,在创建过程总会有一些异常中断整个流程。比如,某个应用启动失败了。 而对于这些工作流中的异常,我们应该如何处理呢?

- **第一种方法是,错误中断法。** 创建环境过程中,各种资源申请、应用部署出现问题时,我们将工作流快照下来,然后收集所有的异常信息,返回给用户。由用户判断当前的情况,等用户确认问题已经得到解决后,可以触发一次快照重试,继续被中断的流程。 - **第二种方法是,优先完成法。** 创建环境过程中发生错误时,先进行几次重试。如果重试依然发生错误的话,就忽略当前错误,先走完剩余的流程,等所有的流程都走完了,再一次性将错误返回给用户。 从整体速度上来看,第二种优先完成的处理方式是更优的,而且也会更少地打断用户。只是方式二需要保证的关键原则是:所有的部署脚本的操作都是幂等的,即两次操作达成的效果是一致的,并不会带来更多的问题。 -

环境变更

实现了应用部署流水线后,创建环境的主流程,即虚机准备和应用部署已经完成,环境已经可以工作了。但还是不能忽略了后续环境变更的需求和工作。一般情况下,研发人员变更环境主要有以下 4 种场景。

-

- 已经有一套新环境,当有新项目时,开发人员会挑选部分应用,组成一个独立的子环境。这里的重点是,要保证子环境和完整环境的调用是互相隔离的。

- 当存在多个子环境时,可能在某个时间点需要做多个项目的集成,这时开发人员需要合并多个环境。

- 和合并的情况相反,有些情况下,开发人员需要将一个子环境中的应用切分开来,分为两个或者多个环境分别进行隔离测试。

- 已经存在一个子环境,当多个并行项目时,开发人员会克隆一套完整的子环境做测试。

对于这 4 个场景,我们需要关注的是在多并行环境的情况下应用拓扑图,包括用户访问应用的入口、应用之间调用链的管理,以及应用对数据库之类的基础设施的访问。

-

- 用户访问应用的入口管理。 以最常用的访问入口(域名)为例,我推荐的做法是根据约定大于配置的原则,当环境管理平台识别到这是一个 Web 应用时,通过应用在生产环境中的域名、路由,环境名等参数,自动生产一个域名并在域名服务上注册。 这里需要注意的是,域名的维护尽量是在 SLB(负载均衡,Server Load Balancer)类似的软负载中间件上实现,而不要在 DNS 上实现。因为域名变更时,通过泛域名的指向,SLB 二次解析可以做到域名访问的实时切换。而如果配置在 DNS 上,域名的变更就无法做到瞬时生效了。

- 应用之间调用链的管理。 对于 service 的调用关系,我在《“配置”是把双刃剑,带你了解各种配置方法》这篇文章中,提到了携程开源的配置中心 Apollo 的实现策略,所有的服务调用的路由都是通过环境描述文件 server.spec 自发现的,你只要保证文件的环境号、IDC 等属性是正确的,整个调用链就不会被混淆。 同时,服务调用中间件需要可以做到自动判断,被隔离的环境内是否有需要被调用的服务,并在当前环境以及基础环境中间进行自动选择,以保证服务被正确调用到。

- 对数据库的访问。 一是,数据库连接串的维护问题,与 SOA 调用链(即服务之间的调用关系)的维护类似,完全可以借鉴;二是,数据库的快速创建策略。 对于数据库中的表结构和数据,我们采取的方式是根据生产中实际的数据库结构,产生一个基准库,由用户自己来维护这个基准库的数据,保证数据的有效性。并在环境创建时,提供数据库脚本变更的接口,根据之前的基准库创建一个新的实例,由此保证环境中的数据符合预期。

对于环境的创建和拆分,最主要的问题就是如何复制和重新配置环境中的各个零件。环境创建,就是不断提高虚拟机准备和应用部署两个流水线的速度和稳定性;环境拆分,则需要关注以上所说的三个最重要的配置内容。

而环境的合并需要注意的问题是,合并后的环境冲突。 比如,两套环境中都存在同一个服务应用,而两者的版本是不一致的;又或者,两个环境各自配置了一套数据库。此时该如何处理呢。

因为环境的描述已经被代码化了,所以我们解决这些问题的方式类似于解决代码合并的冲突问题。在环境合并前,先进行一次环境的冲突检测,如果环境中存在不可自动解决的冲突,就将这些冲突罗列出来,由用户选择合适的服务版本。

如何高效、自动化地实现环境变更的关键点还是在于,我在前面几篇文章中提到的如何管理和实现应用配置和环境配置,以及如何配合环境管理在速度上的需求。

-

总结

对于如何快速搭建一套环境,我从虚拟机环境准备、应用部署流水线和环境变更,这三个方面给你总结了一些常见问题和原则:

-

- 可以使用虚拟机资源池,提升获取机器资源的速度;

- 合理打造并行的应用部署流水线,是进一步提升环境创建速度的方法;

- 利用配置等方式快速达到环境变更需求,可以再次有效地提升整个环境部署的效率。

-

思考题

你所在的公司,新环境应用部署的流水线是怎样的?如果要进一步提速的话,还有哪些优化空间呢?

13 容器技术真的是环境管理的救星吗?

在上一篇文章中,我分享了基于虚拟机打造自动化流水线中的一些常见问题和原则。随着计算机技术的发展,交付方式也在不断地演进和变更。而基于虚拟机的交付方式,正在被基于容器的交付方式所替代。

今天,如果你在一个较大的科技公司,你必定会遇到的如下的场景:

- 多个技术栈;

- 多个不同类型的应用;

- 不同的开发环境和运行环境。

因此,你所面对的交付场景也会变得越来越复杂,带来的挑战也会越来越大。

此外,敏捷研发的流行,使得低成本、高效率的解决研发问题的方式成为主流,因此复杂的交付的场景,显然就会成为拖油瓶。

加之,传统交付方法,已经很难满足这样快速迭代的交付需求,服务交付方式、快速部署、环境隔离、环境一致性等诸多问题亟待解决。

因此,在过去很长一段时间内,持续交付本身也陷入一个发展瓶颈。各规模的团队、企业都承认持续交付是一个好方案,但却都不敢试。其实,主要原因还是,持续交付在技术上没有得到突破性的发展。

但是,容器的出现和兴起,为微服务、CI/CD、DevOps 带来了新的可能性,使得持续交付又有了向前发展的动力,同时也带来了新的挑战。

那么,容器的出现到底为持续交付带来了哪些契机和挑战呢?我在这篇文章中,将和你讨论:为什么说容器是持续交付最重要的利器之一,是环境管理的将来式,这个问题,助你借助容器构建自己的持续交付体系。

什么是容器

在传统模式下的开发到部署流程是这样的:

- 在本地电脑上安装开发应用所需要的库文件、扩展包、开发工具和开发框架,完成开发工作;

- 本地开发完成后,将开发好的应用部署到测试环境进行测试;

- 一切就绪后,再把应用部署到生产环境。

但问题是,你该如何保证开发、测试和生产这三套环境,甚至更多套环境是完全一致的呢?再有就是,环境的变更问题,虽说“百分之九十九的故障是由变更导致的”是一句废话,但也是一句实话,你又该如何确保每套环境的变更是一致的呢?

而容器的出现,似乎解决了这些问题。

正如 Docker 官网解释的:

容器镜像是软件的一个轻量的、独立的、可执行的包,包括了执行它所需要的所有内容:代码、运行环境、系统工具、系统库、设置。

这代表着,一旦一个应用被封装成容器,那么它所依赖的下层环境就不再重要了。

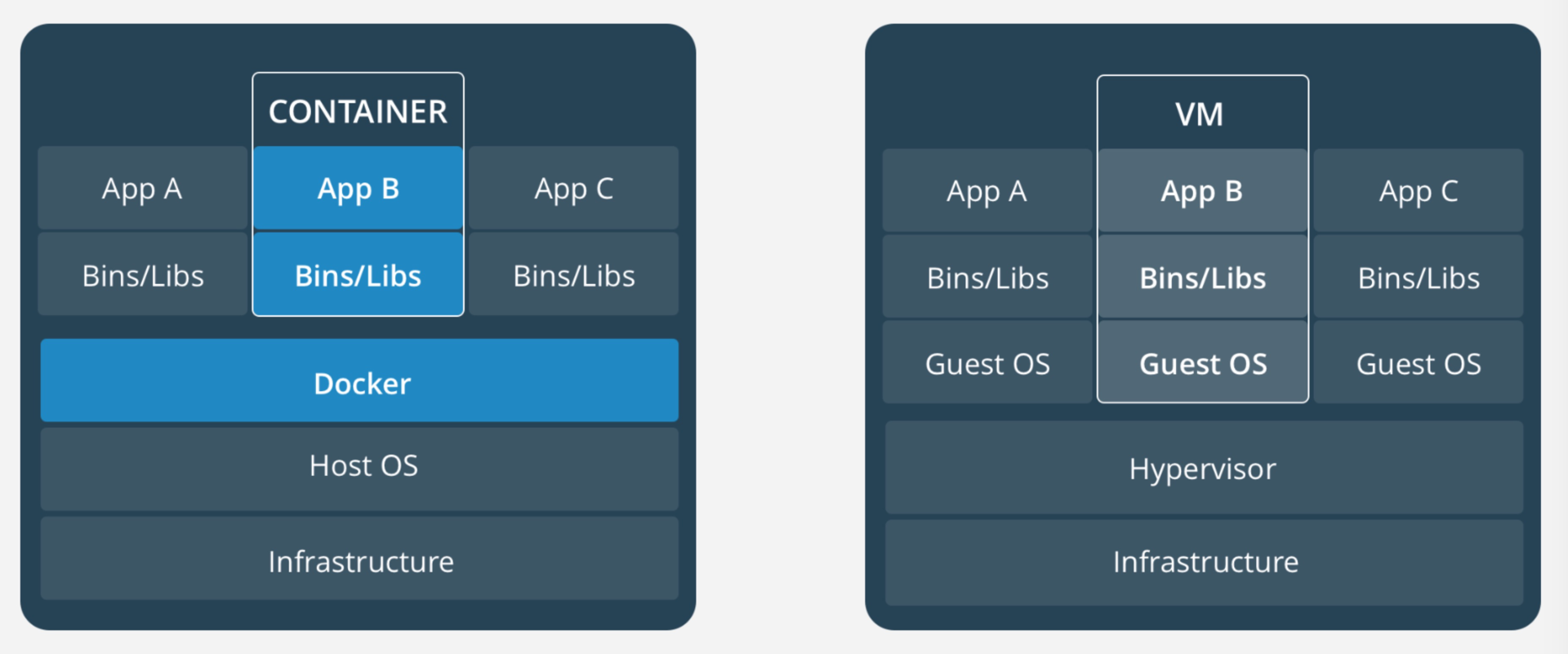

那么,容器和虚拟机到底有什么区别呢?

引自https://www.docker.com/what-container

容器是一个在 App 层的抽象,整合了运行的应用软件代码以及它的依赖、环境。许多个这样的容器可以运行在同一台宿主机上,并与其他容器共享这台宿主机的系统内核。而且,每一个容器实例,都运行在自己独立的进程中,与其他实例隔离。

虚拟机是一种将一台服务器转变成多台服务器的物理硬件设备的抽象。Hypervisor 软件是虚拟机的主要部分,它使得一台物理设备上可以运行多个虚拟机。

每个虚拟机都是一个完整操作系统的拷贝,再搭建一层 runtime,最后供应用程序运行。通常一个虚拟机大小都要超过 10 GB。

容器和虚拟机的主要差异,包括三个方面:

- 首先,多个容器可以共享同一个宿主机的内核,所以容器的体积要比虚拟机小很多,这就使得容器在分发和存储上比较有优势;

- 其次,启动容器不需要启动整个操作系统,所以容器部署和启动速度更快、开销更小,也更容易迁移,这使得容器拥有更强的恢复能力;

- 最后,容器连带代码和环境一起部署的方式,保证了它所包含的程序的运行依赖不会被变更,这就使得容器有效解决了不同环境不同结果的问题。

了解了容器的基本概念,我接下来跟你说说,容器可以对持续交付产生什么影响。

重新定义交付标准

没有容器之前,交付标准包括软件环境(也就所谓的机器)和软件代码两部分。交付系统更关注的是软件代码,环境一旦产生后,我们就不再关心或者很难再干预用户后期是如何对其做变更的了。

也就是说,环境的变更没有版本,没有记录,甚至当事人也会忘记当时变更了什么, 不言而喻,这会带来很多未知的安全隐患。

而,容器技术统一了软件环境和软件代码,交付产物中既包括了软件环境,又包括了软件代码。也就是说,容器帮我们重新定义了交付标准。

那么,容器技术到底是如何做到的呢?被重新定义后的交付,又有哪些特点呢?

第一,交付结果一致

容器镜像可以把软件的运行环境以及代码打包在一起,因此可以基于同一个镜像,在不同的地方生成一模一样的运行环境,也就是说单个镜像的交付结果不可变。

当然,单个容器只能提供一个服务,而实际场景下,应用都是跑在 SOA 或微服务的框架下的。所以,还需要利用如 Mesos 或 Kubernetes 这样的编排系统,将多个容器组织起来,并固化编排过程。

基于这两个特性,一旦形成了固定的容器镜像和对应的编排(也成为应用模板),那在不同的环境下,一定可以重复部署,且部署结果保持一致。

第二,交付自动化

容器镜像及容器编排技术很好地解决了 CI 和 CD 问题:

- CI 方面,与传统方式的不同只在于,原先交付的是安装包或软件包,而容器交付的则是镜像;

- CD 方面,与传统方式相比则有了长足的进步。 对传统方式而言,部署和安装方式与软件类型、开发方式有直接关系,存在多种多样的可能。 而容器技术则没有这样的问题,唯一的方式就是拉起容器镜像。这就大大简化了部署的复杂度,而且在编排系统的支持下,完成 CD 越来越容易了。

第三,交付个性化

传统的交付模式,往往因为环境的初始化问题,只能完成有限种类的交付。运维部门很难为所有的应用做出统一的环境模板,比如需要哪些软件依赖、需要哪些系统配置、部署的步骤是怎样的等等,要统一这些模板,就需要协调多个部门共同完成,难度可想而知。

对于一些受众比较少的程序语言,或者一个仅仅想部署一套开源软件的需求是很难满足的,大多数情况下,需要用户自己去申请虚拟机,然后按照官方提供的文档一步一步安装环境。这样操作,非常麻烦,更别提后续的更新了。

但是,有了容器之后,我们可以使用统一的接口完成任何应用的部署,几乎可以很好地满足所有的个性化需求。

第四,交付版本控制

对于容器来说,遵循的是不可变基础设施(Immutable Infrastructure)的理念,也就是说任何变化,包括代码、环境、配置的变更,都需要重新制作镜像,产生一个新的版本。这与版本往往只和代码变更有关的传统方式有所不同。

那么,这样的变化到底是好是坏呢?

变还是不变,这是个问题

不可变基础设施(Immutable Infrastructure),是 Chad Fowler 在 2013 年提出的一个很有前瞻性的构想:

在这种模式中,任何基础设施的实例(包括服务器、容器等各种软硬件)一旦创建之后便成为一种只读状态,不可对其进行任何更改。如果需要修改或升级某些实例,唯一的方式就是创建一批新的实例来替换它。

这种思想与不可变对象的概念完全相同。

而容器相比于虚拟机体积小和启动快的优势,正好符合了不可变基础设施这一模式的核心思想。

不可变基础设施模式的好处显而易见,主要包括以下三个方面:

- 很多与 runtime 相关的配置工作都可以被简化,这让持续集成与持续部署过程变得更流畅。

- 它也更易于应对部署环境间的差异及版本,进行更有效、全面的管理。

- 对回滚来说,更是得到了充分的保证,只要原先版本的镜像存在,它就一定能被恢复。

虽然不可变基础设施模式能够带来非常多的好处,但是其实现的难度也很高,你需要一套完全不同的版本管理系统,纳入所有的变更,重新定义版本、变更和发布。如何做到这些,我会在后续的文章中为你详细介绍。

但是,这种模式在我看来也是略微违反人性的(人们往往是想怎么简单怎么来)。试想如果你仅有一台机器,只是想升级一下 cURL 的版本,你觉得是直接在容器里更新方便,还是更改 Dockerfile 重打镜像走完一整套发布流程更方便呢?

容器不是银弹

正如上面所说,不可变基础设施模式对运维人员来说绝对是福音,为企业实现持续交付保驾护航。但是,对普通用户来说,这种模式有时候却是一种折磨,不可能有完美的标准化容纳所有的个性化,我们必须为个性化需求做准备。

目前,很多业务开发人员的观念还停留在使用虚拟机的阶段,从虚拟机迁移到容器时,我们也是拼了命地把容器的使用体验向虚拟机靠近,尽量让用户感觉就是在用虚拟机。

初衷是好的,但是这种做法却不能让用户真正认识并理解容器。

在迁移前期,我们经常会遇到这样的案例:由于个别应用对环境的个性化需求,用户需要登录虚拟机安装一些软件,或者更新一些配置。迁到容器后,他们依然这么做,但是结果让他们失望,因为每次应用部署后,之前的环境变更就都消失了。这无疑让他们非常沮丧,就好比写了几个小时的代码忘记了保存。

我们虔诚地遵循了不可变基础设施模式,但是又没有很好地告知用户这一原则。因此,我们不得不提供各种各样的方式让用户完成 “不可变中的可变” 与 “标准化中的个性化”,甚至我们必须在不同的环境使用不同的镜像。

而这,与我们认为的容器交付的理想状态是有差距的。虽然如此,但如何达成这样的目的,我也会在之后的文章中为你具体介绍。

总结

在这篇文章中,我介绍了容器如何代替虚拟机帮助我们应对持续交付的新挑战,但也阐述了使用容器技术实施持续交付的一些不足。

首先,容器是一种轻量级、可移植、自包含的软件打包技术,使应用程序几乎可以在任何地方以相同的方式运行。

然后,我分别从交付结果一致、交付自动化、交付个性化和交付版本控制这 4 个方面重新定义了基于容器的交付标准。

最后,我又从变和不变两个方向,阐述了容器能解决一些已有的问题,但它并不是银弹,它同样会带来问题,而这些问题,则需要改造和重新设计既有的持续交付模式来解决。

思考题

你所在的公司是否已经容器化了?如果已经容器化了,是如何平衡应用标准化与个性化的?对于有状态应用,又该如何使用容器进行交付呢?

14 如何做到构建的提速,再提速!

在前面几篇文章中,我分享了很多关于构建的观点,然而天下武功唯为快不破,构建的速度对于用户持续交付的体验来说至关重要。

在实施持续交付的过程中,我们经常会遇到这样的情况:只是改了几行代码,却需要花费几分钟甚至几十分钟来构建。而这种情况,对于追求高效率的你我来说,是难以容忍的。

那么,今天我就带你一起看看,还有哪些手段可以帮助构建提速。

升级硬件资源

构建是一个非常耗时的操作,常常会成为影响持续交付速度的瓶颈。原因是,构建过程,会直接消耗计算资源,而且很多构建对硬件的要求也非常高。那么,升级硬件资源就是构建过程提速的最为直接有效的方式。

需要注意的是,这里的硬件资源包括 CPU、内存、磁盘、网络等等,具体升级哪一部分,需要具体情况具体分析。

比如,你要构建一个 C 语言程序,那么 CPU 就是关键点。你可以增加 CPU 的个数或者提升 CPU 主频以实现更快的编译速度。

再比如,你要用 Maven 构建一个 Java 应用,除了 CPU 之外,Maven 还会从中央仓库下载依赖写在本地磁盘。这时,网络和磁盘的 I/O 就可能成为瓶颈,你可以通过增加网络带宽提升网络吞吐,使用 SSD 代替机械硬盘增加磁盘 I/O ,从而到达提升整个构建过程速度的目的。

总之,当你使用成熟的构建工具进行构建时,如果无法通过一些软件技术手段提升软件本身的构建速度,那么根据构建特点,有针对性地升级硬件资源,是最简单粗暴的方法。

搭建私有仓库

构建很多时候是需要下载外部依赖的,而网络 I/O 通常会成为整个构建的瓶颈。尤其在当前网络环境下,从外网下载一些代码或者依赖的速度往往是瓶颈,所以在内网搭建各种各样的私有仓库就非常重要了。

目前,我们需要的依赖基本上都可以搭建一套私有仓库,比如:

- 使用 createrepo 搭建 CentOS 的 yum 仓库;

- 使用 Nexus 搭建 Java 的 Maven 仓库;

- 使用 cnpm 搭建 NodeJS 的 npm 仓库;

- 使用 pypiserver 搭建 Python 的 pip 仓库;

- 使用 GitLab 搭建代码仓库;

- 使用 Harbor 搭建 Docker 镜像仓库

- ……

除了提升构建时的下载速度外,更重要的是,你还可以用这些工具存储辛勤工作的成果,保护知识产权。

总之,搭建私有仓库一定物超所值。当然,维护和管理这一大批工具需要投入不少人力和经济成本,在公司 / 团队没有成一定规模的前提下,会有一定的负担。

所以,如果你的团队暂时没有条件自己搭建私有仓库的话,可以使用国内已有的一些私有仓库,来提升下载速度。当然,在选择私有仓库时,你要尽量挑选那些被广泛使用的仓库,避免安全隐患。

使用本地缓存

虽然搭建私有仓库可以解决代码或者依赖下载的问题,但是私有仓库不能滥用,还是要结合构建机器本地的磁盘缓存才能达到利益最大化。

如果每次依赖拉取都走一次网络下载,一方面网络下载的速度通常会比本地磁盘慢很多,另一方面在构建量很大时,并发请求会导致私有仓库出现网卡打爆或者出现莫名其妙的异常,从而导致所有的构建过程变得不稳定,甚至影响其他工具的使用。

所以,妥善地用好本地缓存十分重要。这里说的“妥善”,主要包括以下两个方面:

- 对于变化的内容,增量下载;

- 对于不变的内容,不重复下载。

目前,很多工具都已经支持这两点了。

对于第一点,项目的源码是经常变化的内容,下载源码时,如果你使用 Git 进行增量下载,那么就不需要在每次构建时都重复拉取所有的代码。Jenkins 的 Git 插件,也默认使用这种方式。

对于第二点,Maven 每次下载依赖后都会在本地磁盘创建一份依赖的拷贝,在构建下载之前会先检查本地是否已经有依赖的拷贝,从而达到复用效果。并且,这个依赖的拷贝是公共的,也就是说每个项目都可以使用这个缓存,极大地提升了构建效率。

如果你使用 Docker,那么你可以在宿主机上 mount 同一个依赖拷贝目录到多个 Slave 容器上,这样多个容器就可以共享同一个依赖拷贝目录。你可以最大程度地利用这一优势,但要注意不要让宿主机的磁盘 I/O 达到瓶颈。

规范构建流程

程序员的祖训说:Less is More,Simple is Better,这与大道至简的含义不谋而合。

程序的追求是简约而不简单,但随着业务越来越复杂,构建过程中各种各样的需求也随之出现,虽然工具已经封装了很多实用的功能,但是很多情况下,你都需要加入一些自定义的个性化功能,才能满足业务需求。

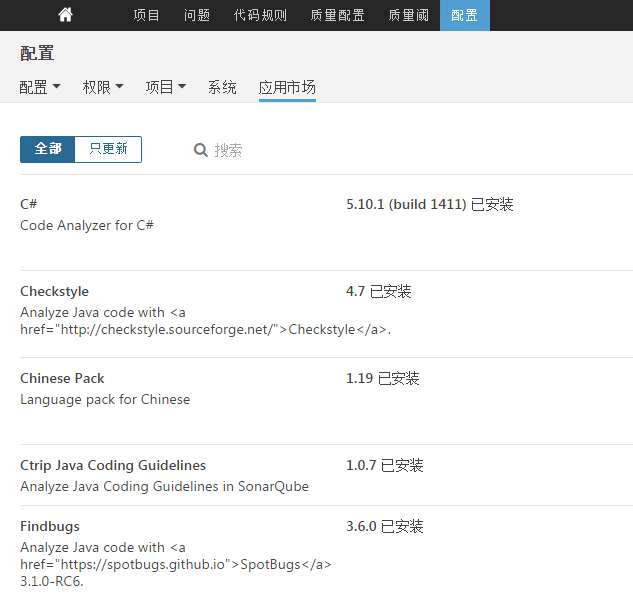

在携程,Java 构建过程中就有大量的额外逻辑,比如 Enforcer 检查、框架依赖检查、Sonar 检查、单元测试、集成测试等等,可以说是无所不用其极地去保证构建产物的质量。

因此,当前复杂的构建过程再也回不到仅仅一条 mvn 或者 gcc 命令就能搞定的年代。而这一套复杂的流程下来必定会花费不少时间,让程序员们有更多喝茶和去厕所的时间。

追求高效的同时,又不舍弃这些功能,是一个现实而又矛盾的命题,我们能否做到二者兼顾呢?答案,当然肯定的。

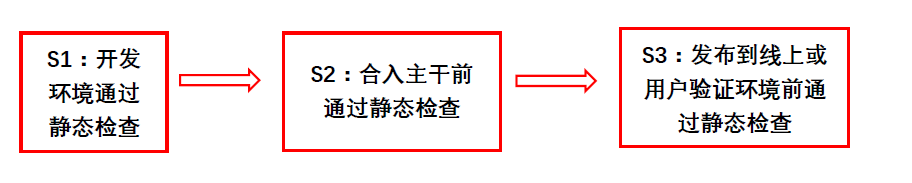

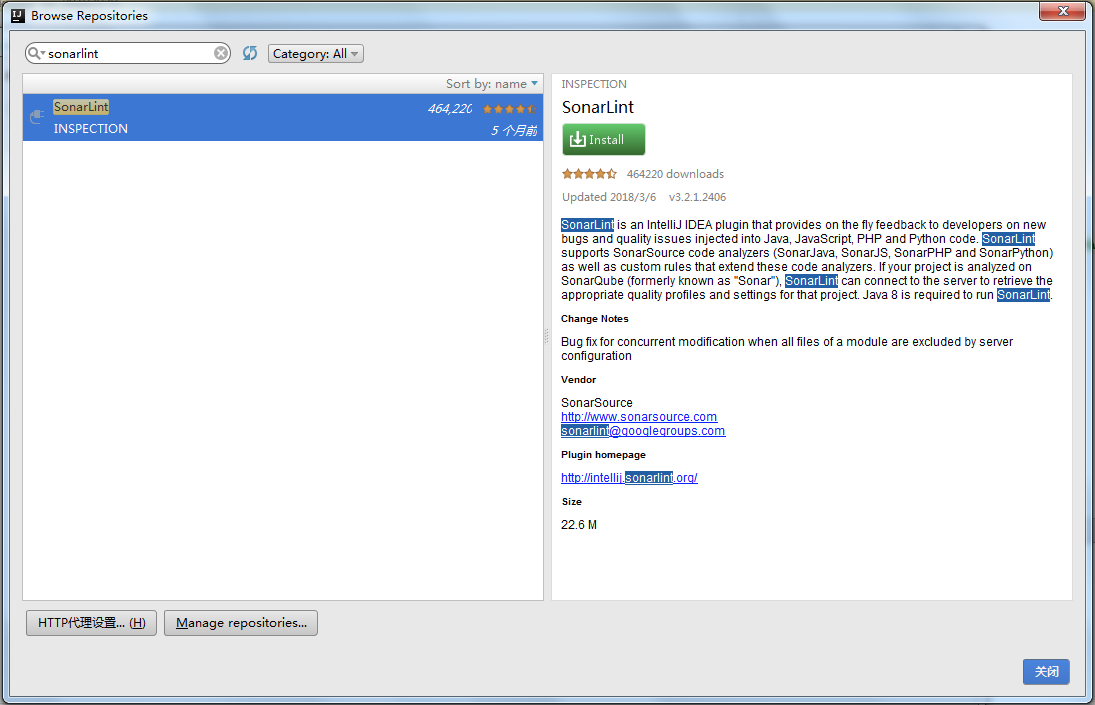

以 Java 构建为例,Enforcer 检查、框架依赖检查、Sonar 检查、单元测试、集成测试这些步骤,并没有放在同一个构建过程中同步执行,而是通过异步的方式穿插在 CI/CD 当中,甚至可以在构建过程之外执行。

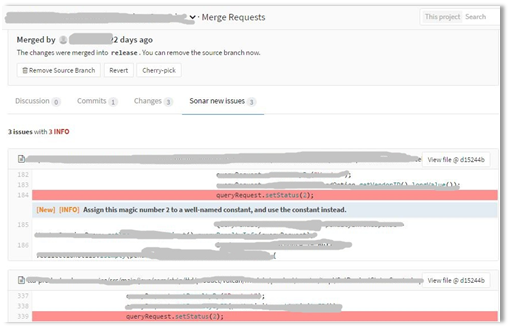

比如, Sonar 扫描在代码集成阶段执行,用户在 GitLab 上发起一个合并请求(Merge Request),这时只对变更的代码进行对比 Sonar 扫描,只要变更代码检查没有问题,那么就可以保证合并之后主干分支的代码也是没问题的。

所以,用户发布时就无需再重复检查了,只要发布后更新远端 Sonar Qube 的数据即可,同时,这个过程完全不会影响用户的构建体验。

通过以上一些规范构建流程的做法,可以进一步提高构建速度。

善用构建工具

正如我前面所说的,目前很多构建工具已经具备了非常多的功能来帮助我们更好地进行构建,因此,充分理解并用好这些功能就成了我们必须要掌握的武林绝学。

以 Maven 为例,我来带你看看有哪些提速方式,当然其他的构建工具,如 Gradle 等也都可以采用类似的方法:

- 设置合适的堆内存参数。 过小的堆内存参数,会使 Maven 增加 GC 次数,影响构建性能;过大的堆内存参数,不但浪费资源,而且同样会影响性能。因此,构建时,你需要反复试验,得到最优的参数。

- 使用 -Dmaven.test.skip = true 跳过单元测试。 Maven 默认的编译命令是 mvn package,这个命令会自动执行单元测试,但是通常我们的构建机器无法为用户提供一套完整的单元测试环境,特别是在分布式架构下。因此如果单元测试需要服务依赖,则可以去掉它。

- 在发布阶段,不使用 Snapshot 版本的依赖。 这就可以在 Maven 构建时不填写 -U 参数来强制更新依赖的检查,省下因为每次检查版本是否更新而浪费的时间。

- 使用 -T 2C 命令进行并行构建。 在该模式下 ,Maven 能够智能分析项目模块之间的依赖关系,然后并行地构建那些相互间没有依赖关系的模块,从而充分利用计算机的多核 CPU 资源。

- 局部构建。 如果你的项目里面有多个没有依赖关系的模块,那么你可以使用 -pl 命令指定某一个或几个模块去编译,而无需构建整个项目,加快构建速度。

- 正确使用 clean 参数。 通常情况下,我们建议用户在构建时使用 clean 参数保证构建的正确性。clean 可以删除旧的构建产物,但其实我们大多数时间可能不需要这个参数,只有在某些情况下(比如,更改了类名,或者删除了一些类)才必须使用这个参数,所以,如果某次变更只是修改了一些方法,或者增加了一些类,那么就不需要强制执行 clean 了。

总之,如果你能熟练运用各种构建工具,那么你的效率一定会比其他人高,你的构建速度一定比其他人快。

总结

我介绍了五种常见的构建提速的方式,分别是:

- 升级硬件资源,最直接和粗暴的提速方式;

- 搭建私有仓库,避免从外网下载依赖;

- 使用本地缓存,减少每次构建时依赖下载的消耗;

- 规范构建流程,通过异步方式解决旁支流程的执行;

- 善用构建工具,根据实际情况合理发挥的工具特性。

然而,每个公司持续交付的构建流程不太一样,面临的问题与挑战也都不太一样,所以在优化前,一定要先了解问题原因,再对症下药。

思考题

你所在公司的构建流程是什么样的?是否也面临性能的问题?你又是是如何解决这些问题的?

15 构建检测,无规矩不成方圆

在这个专栏的第 5 篇文章《手把手教你依赖管理》中,我介绍了构建 Java 项目的一些最佳实践,同时也给你抛出了一个问题:如果用户偷懒不遵循这些规范该怎么办?

所谓没有规矩不成方圆,构建是持续交付过程中非常重要的一步,而好的构建检测则可以直接提升交付产物的质量,使持续交付的流水线又快又稳。所以,也就有了 Maven 构建中的大杀器:Maven Enforcer 插件。

什么是 Maven Enforcer 插件?

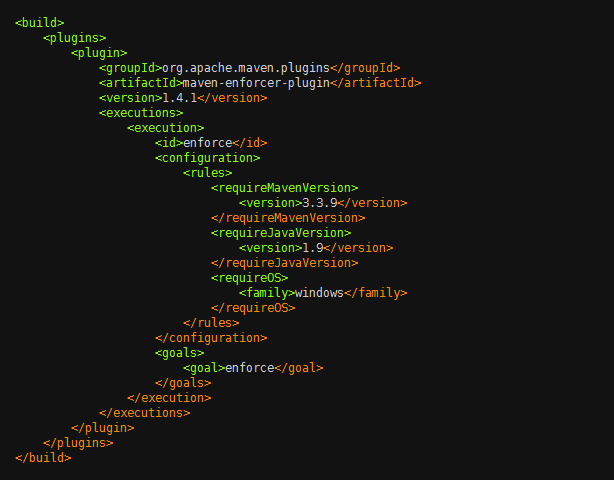

Maven Enforcer 插件提供了非常多的通用检查规则,比如检查 JDK 版本、检查 Maven 版本、检查依赖版本,等等。下图所示就是一个简单的使用示例。

上述的配置会在构建时(准确的说是在 validate 时)完成三项检查:

- requireMavenVersion 检查 Maven 版本必须大于 3.3.9;

- requireJavaVersion 检查 JDK 版本必须大于等于 1.9;

- requireOS 检查 OS 必须是 Windows 系统。

如果你使用 Java 1.8, Maven 3.3.3, 在 Linux 上构建, 便会出现如下的错误:

- Rule 0: org.apache.maven.plugins.enforcer.RequireMavenVersion failed with message: Detected Maven Version: 3.3.3 is not in the allowed range 3.3.9.

- Rule 1: org.apache.maven.plugins.enforcer.RequireJavaVersion failed with message: Detected JDK Version: 1.8.0-77 is not in the allowed range 1.9.

- Rule 2: org.apache.maven.plugins.enforcer.RequireOS failed with message: OS Arch: amd64 Family: unix Name: linux Version: 3.16.0-43-generic is not allowed by Family=windows

从而导致构建失败。

那么,是否有办法在所有应用的构建前都执行 Enforcer 的检查呢。

我在专栏的第 5 篇文章《手把手教你依赖管理》中,也已经介绍了在携程内部,一般 Java 应用的继承树关系,每个项目都必须继承来自技术委员会或公司层面提供的 super-pom。携程在 super-pom 之上又定义了一层 super-rule 的 pom,这个 pom 中定义了一系列的 Enforcer 规则。 这样,只要是集成了 super-pom 的项目,就会在构建时自动运行我们所定义的检查。

也许你会问了, 如果用户不继承 super-pom 是不是就可以跳过这些规则检查了?是的, 继承 super-pom 是规则检查的前提。

但是,我们不会给用户这样的机会, 因为上线走的都是统一的构建系统。

构建系统在构建之前会先检查项目的继承树,继承树中必须包含 super-pom, 否则构建失败。并且,构建系统虽然允许用户自定义 Maven 的构建命令,但是会将 Enforcer 相关的参数过滤掉,用户填写的任何关于 Enforcer 的参数都被视为无效。Enforcer 会被强制按照统一标准执行,这样就保证了所有应用编译时都要经过检查。

因为携程的构建系统只提供几个版本的 Java 和 Maven,并且操作系统是统一的 Linux CentOS 版本,所以就不需要使用之前例子中提到的三个检查,一定程度的缩小标准化范围,也是有效的质量保证手段。

了解了 Maven Enforcer 插件,我再从 Maven Enforcer 内置的规则、自定义的 Enforcer 检查规则,以及构建依赖检查服务这三个方面,带你一起看看构建监测的“豪华套餐”,增强你对交付产物的信心。

丰富的内置的 Enforcer 规则

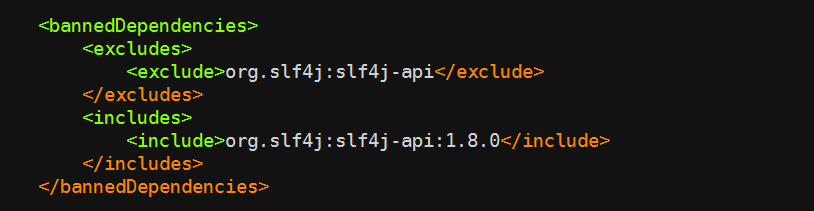

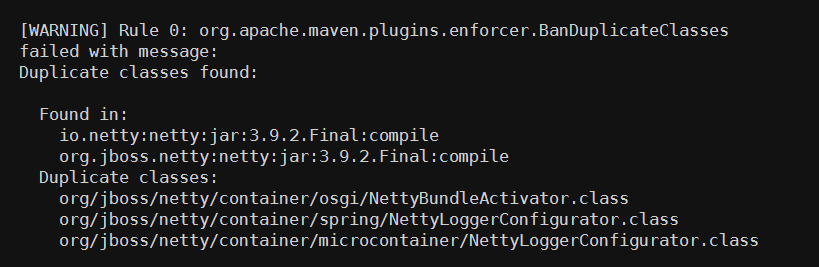

Maven Enforcer 提供了非常丰富的内置检查规则,在这里,我给你重点介绍一下 bannedDependencies 规则、dependencyConvergence 规则,和 banDuplicateClasses 规则。

第一,bannedDependencies 规则

该规则表示禁止使用某些依赖,或者某些依赖的版本,使用示例:

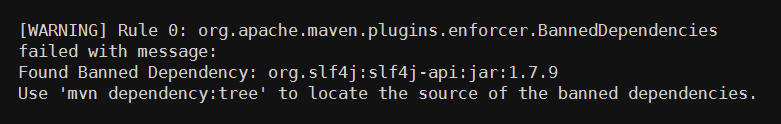

该代码检查的逻辑是,只允许使用版本大于等于 1.8.0 的 org.slf4j:slf4j-api 依赖,否则将会出现如下错误:

bannedDependencies 规则的常见应用场景包括:

- 当我们知道某个 jar 包的某个版本有严重漏洞时,可以用这种方法禁止用户使用,从而避免被攻击;

- 某个公共组件的依赖必须要大于某个版本时,你也可以使用这个方法禁止用户直接引用不兼容的依赖版本,避免公共组件运行错误。

第二,dependencyConvergence 规则

在《手把手教你依赖管理》一文中,我介绍了 Maven 的依赖仲裁的两个原则:最短路径优先原则和第一声明优先原则。

但是,Maven 基于这两个原则处理依赖的方式过于简单粗暴。毕竟在一个成熟的系统中,依赖的关系错综复杂,用户很难一个一个地排查所有依赖的关系和冲突,稍不留神便会掉进依赖的陷阱里,这时 dependencyConvergence 就可以粉墨登场了。

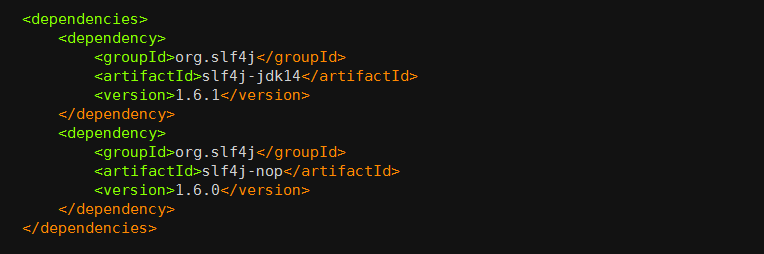

dependencyConvergence 规则的作用是: 当项目中的 A 和 B 分别引用了不同版本的 C 时, Enforce 检查失败。 下面这个实例,可以帮你理解这个规则的作用。

org.slf4j:slf4j-jdk14:1.6.1 依赖了 org.slf4j:slf4j-api:1.6.1, 而 org.slf4j:slf4j-nop:1.6.0 依赖了 org.slf4j:slf4j-api:1.6.0,当我们在构建项目时, 便会有如下错误:

这时就需要开发人员介入了,使用 dependecy 的 exclusions 元素排除掉一个不合适的版本。 虽然这会给编程带来一些麻烦, 但是非常必要。因为,我始终认为你应该清楚地知道系统依赖了哪些组件, 尤其是在某些组价发生冲突时,这就更加重要了。

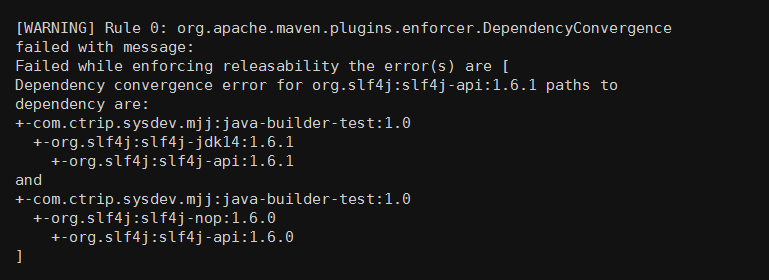

第三,banDuplicateClasses 规则

该规则是 Extra Enforcer Rules 提供的,主要目的是检查多个 jar 包中是否存在同样命名的 class,如果存在编译便会报错。 同名 class 若内容不一致,可能会导致 java.lang.NoSuchFieldError,java.lang.NoSuchMethodException 等异常,而且排查起来非常困难,因为人的直觉思维很难定位到重复类这个非显性错误上,例如下面这种情况:

org.jboss.netty 包与 io.netty 包中都包含一个名为 NettyBundleActivator 的类,另外还有 2 个重复类:spring/NettyLoggerConfigurator 和 microcontainer/NettyLoggerConfigurator。

当激活了 banDuplicateClasses 规则之后,Enforcer 检查,便会有如下的报错:

通常情况下,用户需要排除一个多余的 jar 包来解决这个问题,但有些情况下两个 jar 包都不能被排除,如果只是个别类名冲突了,那么可以通过 ignoreClasses 去忽略冲突的类,类名可以使用通配符(*),如: org.jboss.netty.container.*。

但是,用户不能随意更改这个配置,因为它必须得到一定的授权,否则随意忽略会产生其他不确定的问题。因此我们将这个插件做了一些改动,通过 API 来获取 ignoreClasses 的内容。当用户有类似的需求时,可以提交 ignoreClasses ,但必须申请,经过 Java 专家审批之后才可忽略掉。

自定义的 Enforcer 检查规则

除了上述的官方规则,实际上携程还做了若干个扩展的规则,如:

- CheckVersion,用于检查模块的版本号必须是数字三段式,或者带有 SNAPSHOT 的数字三段式;

- CheckGroupId,用于检查 GroupId 是否符合规范,我们为每个部门都分别指定了 GroupId;

- CheckDistributionManagementRepository,用于检查项目的 distributionManagement 中的 repository 节点,并为每个部门都指定了他们在 Nexus 上面的 repositroy;

- CheckSubModuleSaveVersion,用于检查子模块版本号是否与父模块版本号一致。

以上,便是携程基于 Maven Enforcer 在构建检查上的一些实践,你可以借鉴使用。

但是,有时候 Maven Enforcer 也无法满足我们所有的需求,比如,它无法完成非 Java 项目的检查。因此,我们还有一个通用的依赖检查服务。

构建依赖检查服务

其他语言, 比如 C#,NodeJS 等,没有 Maven Enforcer 这样成熟的工具来做构建时的依赖检查。对于这类语言我们的做法是:构建后,收集该项目所有的依赖及其版本号,将这些数据发送给依赖检查服务 Talos,Talos 根据内置的规则进行依赖检查。Talos 是一套携程自研的,独立的,组件依赖检查系统,其中包含的检查逻辑,完全可以自由定义。

而且,Talos 依赖检查的逻辑更新非常灵活,可以直接在平台内使用 Java 代码在线编写检查逻辑,提交后便可实时生效。

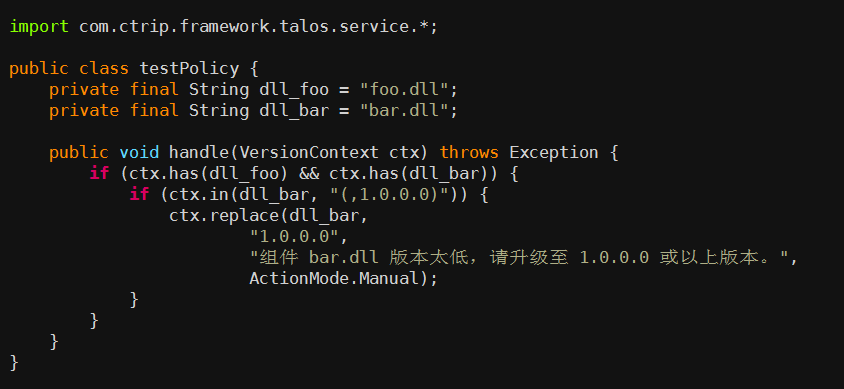

以下是一段 .NET 项目检查逻辑的示例代码:

该逻辑的含义是: 当项目的依赖存在 foo.dll 和 bar.dll 时,bar.dll 的版本号必须大于 1.0.0.0。看, 是不是非常方便快捷通用!

这样一套组合拳下来,构建检测以及项目依赖的问题已不再那么让人望而生畏了。因此,工欲善其事必先利其器, 好的工具可以解放大量的生产力,最重要的是构建检测后的交付让你我更有信心了。有条不紊的流程与规范,就像一列高速列车下的枕木,时刻保证着整个系统稳定而可靠地推进。

总结与实践

我围绕着构建检测,和你一起学习并介绍了:

- Maven Enforcer 插件可以帮我们更好地完成编译检测;

- 可以使用内置的 Maven Enforcer 规则,覆盖常规检测;

- 可以使用自定义 Maven Enforcer 检查规则的方式,增加版本号规则等的检查;

- Maven Enforcer 之外,你还可以自己丰富一些例如依赖版本检测这样的服务,以提高检测效果。

Maven Enforcer 提供了非常丰富的内置检查规则,感兴趣的话,你可以通过https://maven.apache.org/enforcer/enforcer-rules/index.html 以及 http://www.mojohaus.org/extra-enforcer-rules/ 逐个尝试这些规则,并说说哪些规则是你工作总最最需要的。

16 构建资源的弹性伸缩

在前面的文章中,我已经介绍了构建在整个持续交付过程中扮演的重要角色,并且详细讨论了依赖管理和构建检测等方面的内容。在这篇文章中,我将带你搭建一套高可用、高性能的构建系统。

持续集成工具

目前市面上已经有很多持续集成工具了,它们已经替我们解决了很多实际问题,所以我们也就没有必要去再重复造轮子了。这些持续集成工具,最流行的应属 Travis CI、Circle CI、Jenkins CI 这三种。

第一,Travis CI

Travis CI 是基于 GitHub 的 CI 托管解决方案之一,由于和 GitHub 的紧密集成,在开源项目中被广泛使用。

Travis CI 的构建,主要通过 .travis.yml 文件进行配置。这个 .travis.yml 文件描述了构建时所要执行的所有步骤。

另外,Travis CI 可以支持市面上绝大多数的编程语言。但是,因为 Travis 只支持 GitHub,而不支持其他代码托管服务,所以官方建议在使用前需要先具备以下几个条件:

- 能登录到 GitHub;

- 对托管在 GitHub 上的项目有管理员权限;

- 项目中有可运行的代码;

- 有可以工作的编译和测试脚本。

Travis CI 的收费策略是,对公共仓库免费,对私有仓库收费。

第二,CircleCI

CircleCI 是一款很有特色,也是比较流行的,云端持续集成管理工具。CircleCI 目前也仅支持 GitHub 和 Bitbucket 管理。

CircleCI 与其他持续集成工具的区别在于,它们提供服务的方式不同。CircleCI 需要付费的资源主要是它的容器。

你可以免费使用一个容器,但是当你发现资源不够需要使用更多的容器时,你必须为此付费。你也可以选择你所需要的并行化级别来加速你的持续集成,它有 5 个并行化级别(1x、4x、8x,、12x,和 16x)可供选择,分别代表利用几个容器同时进行一个项目的构建,如何选择就取决于你了。

第三,Jenkins CI

Jenkins 是一款自包含、开源的用于自动化驱动编译、测试、交付或部署等一系列任务的自动化服务,它的核心是 Jenkins Pipline 。Jenkins Pipline 可以实现对持续交付插件的灵活组合,以流水线的方式接入到 Jenkins 服务。

Jenkins 还提供了一整套可扩展的工具集,程序员可以通过代码的方式,定义任何流水线的行为。另外,经过多年的发展,Jenkins 已经包含了很多实用的第三方插件,覆盖了持续交付的整个生命周期。

目前,绝大多数组织都选择了 Jenkins 作为内部的持续集成工具,主要原因是:

- 代码开源, 插件完善,系统稳定;

- 社区活跃,成功实践与网上资源比较丰富;

- Jenkins Pipeline 非常灵活好用。

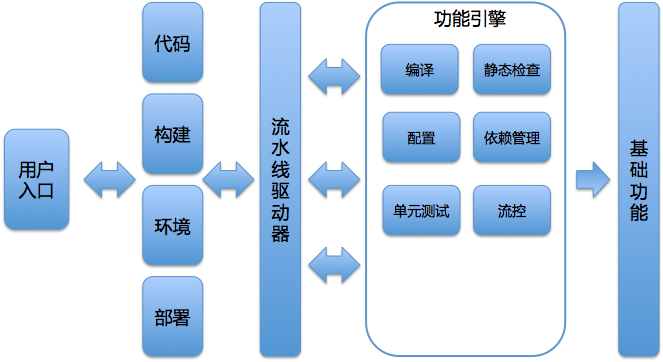

大致了解了集成工具之后,携程和绝大部分企业一样,选择了最开放、最易于扩展的 Jenkins 作为集成构建的引擎,而且分别从实现横向的 Master 高可用和纵向的 Slave 弹性伸缩两方面,使构建系统更为强大和高效。

Jenkins Master 高可用架构的

目前普遍的 Jenkins 搭建方案是:一个 Jenkins Master 搭配多个 Jenkins Slave。大多数情况下,这种方案可以很好地工作,并且随着构建任务的增加,无脑扩容 Jenkins Slave 也不是一件难事。另外,不管是 Linux Slave 还是 Windows Slave ,Jenkins 都可以很好地支持,并且非常稳定。

但是,随着业务的增长,微服务架构的流行,持续交付理念的深入人心,构建会变得越来越多,越来越频繁,单个 Jenkins Master 终究会成为系统中的瓶颈。

遗憾的是,开源的 Jenkins 并没有给我们提供一个很好的 Master 高可用方案,CloudBees 公司倒是提供了一个高可用的插件,但是价格不菲。

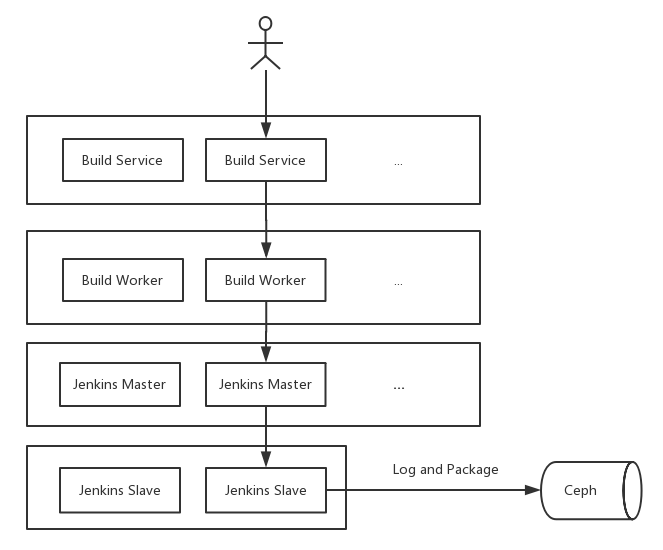

所以,为了鱼与熊掌兼得,最终携程决定自己干。下面是我们构建系统的基本架构:

图 1 携程 Jenkins Master 高可用架构

携程的解决思路是在 Jenkins 上面再封装两层: Build Service 暴露构建的 HTTP 接口,接收请求后将任务丢给异步队列 Build Worker,Build Worker 根据不同的策略将任务分发给符合条件的 Jenkins Master。

这里的分发条件,可以是编译任务的平台或语言,比如可以将基于 Windows 和 Linux 的任务分别放在不同的 Jenkins Master 上,也可以将 Java 构建和 NodeJS 构建任务放在不同的 Jenkins Master 上。

除此之外,携程的这个构建系统还可以满足的一种需求是:一些比较复杂且重要的业务线,有时也会提出独立构建资源的需求,以达到独占编译资源的目的。

总而言之,构建任务分发的策略可以是非常灵活的:构建 Worker 和 Jenkins Master 之间有“心跳监测”,可以时刻检查 Jenkins Master 是否还健康,如果有问题就将任务分发到其他等价的 Jenkins Master 上,并给相关人员发送告警通知。

这种拆解 Jenkins Master 主要有以下几个好处:

- 每个 Job 都可运行在至少两个 Jenkins Master 之上, 保证高可用;

- 根据不同的策略将 Job 做 Sharding, 避免积压在同一个 Master 上;

- Jenkins Master 按需配置,按需安装不同的插件,便于管理。

利用这套方案,携程就可以做到 Master 层面的伸缩了。这套方案的实现成本并不是很大,简单易懂,小团队也完全可以掌握和实施。

Jenkins Slave 弹性伸缩方案

解决了 Jenkins Master 的高可用问题,接着就要去思考如何才能解决 Slave 资源管理和利用率的问题了。因为,你会发现一个组织的集成和构建往往是周期性的,高峰和低谷都比较明显,而且随着组织扩大,幅度也有所扩大。所以,如果按照高峰的要求来配备 Slave 实例数,那么在低谷时,就很浪费资源了。反之,又会影响速度,造成排队。

因此,我们需要整个 Slave 集群具有更优的弹性:既要好管理,又要好扩展。在携程,我们尝试过多种虚拟机方案,比如全 Windows 类型、金映象方案等等。最后,根据容器的特性,选择了容器作为解决方案。期间也经历了 Mesos 到 K8s 的两套方案。

第一,最初的虚拟机

在最初构建种类不多并且场景不复杂的情况下,我们的 Slave 全部使用 Windows 虚拟机。

我们把所需的构建软件像大杂烩一样一股脑地安装在虚拟机上,比如,编译 .NET 所需的 MSBuild ,编译 Java 所需的 Maven。我们维护着一份啰嗦冗长的安装手册,并小心翼翼地这些文档保存在服务器上。

这时,最怕的就是构建环境的变更,比如某个软件要升级,要添加对某个新软件的支持。这些变更需要我们对所有机器的操作都重来一遍,甚至还需要关机重启,十分费时折腾。

后来,我们尝试了将虚拟机维护成镜像,并使用 SaltStack 做自动化变更。虽然日子好过了点,但升级一次环境还是需要投入不少人工成本。另外,文档的更新始终一件苦差事,从来不敢怠慢就怕某次变更没有记录在案。

你我都清楚,写文档从来都不像写代码那么舒服。程序员最讨厌的两件事也都和文档相关:一是给自己的软件写文档,二是别人的软件没有文档。

这让我们非常困扰,我们做的是 DevOps 与持续交付,但是自己的工具管理却如此混乱无章,这也使我们感觉十分蒙羞与窘迫。

第二,容器化的甜头

随着容器越来越流行,我们发现:使用容器镜像保存构建环境是一个非常不错的选择。相对于虚拟机,容器技术主要有以下几个优势:

- 使用 Dockerfile 描述环境信息相对于之前的文档更加直观,并且可以很自然地跟 Git 结合做到版本化控制,先更新 Dockerfile 再更新镜像是很自然的事。

- 镜像更容易继承,你可以配置一个 Base 镜像,然后根据不同的需求叠加软件。比如,你的所有构建都需要安装 Git 等软件,那么就可以把它写到 Base 镜像里面。

- Docker 镜像可以自由控制,开发人员可以自己推送镜像,快速迭代。重建容器的代价比重建虚拟机小得多,容器更加轻量,更容易在本地做测试。

目前,携程的构建系统已经支持了包括: Java, NodeJS,Golang,Erlang,Python 等多种语言的构建,并且维护起来非常轻松,完全没有负担。

在尝到了 Linux 容器带来的甜头之后,我们毅然决然地开始研究 Windows 容器技术。经过不断地尝试与探索,终于把它应用到了生产环境,并且取得了非常不错的效果,目前为止运行也十分稳定。

第三,让资源弹起来

容器化在很大程度上解决了运维成本的问题,虽然通过 Docker 管理容器比虚拟机要方便一些,但是管理大量的容器却也没那么得心应手。

此外,我们之前使用容器的方式几乎和使用虚拟机一样,也就是所谓的 “胖容器”,一旦创建,不管用不用,它都在那里。而构建是一个周期性的行为,一般跟着程序员的工作时间走:工作日比周末多,白天比晚上多,甚至还有明显的午饭和晚饭空闲期。

后来 Mesos 与 Kubernetes 等主流的容器集群管理工具渐渐浮出水面,出现在我们的视野中。

基于 Borg 成熟经验打造的 Kubernetes,为容器编排管理提供了完整的开源方案,并且社区活跃,生态完善,积累了大量分布式、服务化系统架构的最佳实践。在 2017 年, 携程尝试将 Jenkins 和 Kubernetes 集成在了一起 。

目前,Jenkins 社区已经提供了一个 Kubernetes 插件,而且是免费的,使得 Jenkins 与 K8s 的集成变得非常简单轻松。

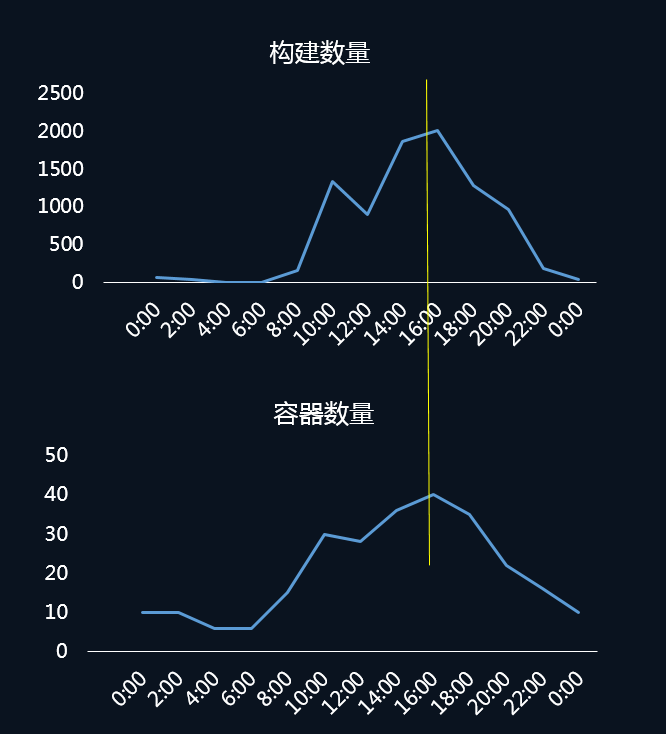

图 2 构建数量与容器数量对比

上图就是我们某台宿主机 24 小时的构建数量与所创建容器的对比图,可以看出两条曲线呈现的趋势基本是一致的。我们在夜晚闲置的资源上,调度了一些其他的离线 Job,大幅提升了资源利用率。

所以,携程利用容器技术,也顺利实现了 Slave 节点的弹性伸缩。对于中小型企业,初期完全可以利用 Jenkins 及其 Kubernetes 插件,做到 Slave 节点的资源弹性伸缩。至于与离线 Job 混部,因为要考虑的因素较多,可以在应用容器化之后再考虑。

总结与实践

我主要介绍了几种流行的持续集成工具,以及基于 Jenkins 的高可用构建系统的一些基本设计理念和我们系统的演变过程。

- 通常建议使用成熟的 CI 产品(比如,Travis CI、Circle CI、Jenkins CI)来作为平台的基础;

- 虽然这些 CI 工具是成熟产品,但面对日新月异的技术需求,高可用和伸缩问题还是要自己解决;

- 通过请求分发等设计,可以实现 Master 节点的横向伸缩及高可用问题;

- 利用容器技术,可以解决 Salve 节点的弹性伸缩和资源利用率问题。

最后,你可以尝试搭建一套 Jenkins 与 Kubernetes 服务,让你的任务跑在动态创建出来的容器上,并思考一下这个方案有没有什么缺点和不足。

17 容器镜像构建的那些事儿

随着容器发布越来越流行,持续交付最后一公里的产物,逐渐由之前的代码包变成了容器镜像。然而,容器镜像构建与传统的代码构建有很多不同之处,也增加了很多新鲜的技术领域和内容需要我们去学习。

所以,今天我们就一起来聊聊容器镜像构建的那些事儿,打通容器镜像构建的各个环节。

什么是容器镜像?

在虚拟机时代就有镜像的说法,当我们创建一个虚拟机时,通常会去网上下载一个 ISO 格式的虚拟机镜像,然后经过 VirtualBox 或者 VMware 加载,最终形成一个包含完整操作系统的虚拟机实例。

而容器镜像也是类似的意思,只不过它不像虚拟机镜像那么庞大和完整,它是一个只读的模板,一个独立的文件系统,包含了容器运行初始化时所需要的数据和软件,可以重复创建出多个一模一样的容器。

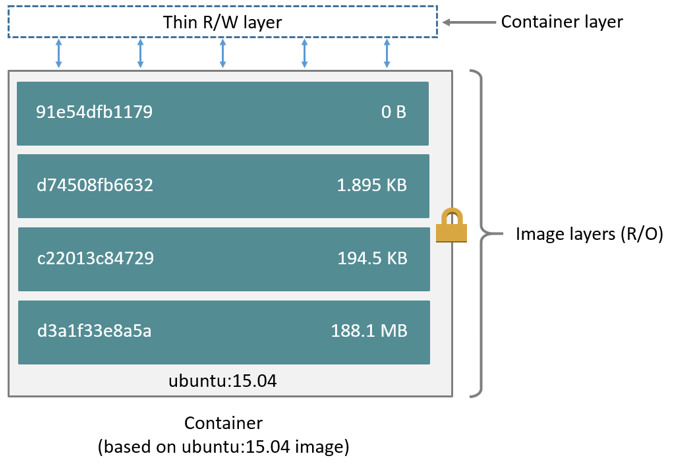

容器镜像可以是一个完整的 Ubuntu 系统,也可以是一个仅仅能运行一个 sleep 进程的独立环境,大到几 G 小到几 M。而且 Docker 的镜像是分层的,它由一层一层的文件系统组成,这种层级的文件系统被称为 UnionFS。下图就是一个 Ubuntu 15.04 的镜像结构。

引用自 docker docs:images and layers

图中的镜像部分画了一个锁的标记,它表示镜像中的每一层都是只读的,只有创建容器时才会在最上层添加一个叫作 Container layer 的可写层。容器运行后的所有修改都是在这个可写层进行,而不会影响容器镜像本身。

因为这一特性,创建容器非常节省空间,因为一台宿主机上基于同一镜像创建的容器只有这一份镜像文件系统,每次创建多出来的只是每个容器与镜像 diff 的磁盘空间。而虚拟机每增加一个实例,都会在宿主机上占用一个完整的镜像磁盘空间。

什么是 Dockerfile

了解了什么是容器的镜像,以及与虚拟机镜像的区别后,可以清楚地看到:容器都是基于镜像产生的,没有镜像就没有容器。那么,我们应该怎么创建一个镜像呢?

Docker Hub上提供了非常多的常用镜像,比如 Ubuntu 镜像,CentOS 镜像,或者仅仅是一个包含 Java 程序的镜像,你可以通过 docker pull 命令把它们下载到本地使用。当然你也可以自己在本地通过 docker build 制作镜像。

如果你想要修改或者加工这些镜像,可以找到文件系统中对应的 layer 目录,然后进行修改。按照这种方式操作的话,如果我要添加一个文件还好说,但如果要安装一个软件,那就要拷贝一堆文件到各个目录中,相当麻烦。

如果真要这样操作的话,容器镜像也就不会有今天如此庞大的用户群体了。Docker 帮我们解决这个问题的方式,就是提供了 Dockerfile。

简单来说,Dockerfile 第一个好处就是,可以通过文本格式的配置文件描述镜像,这个配置文件里面可以运行功能丰富的指令,你可以通过运行 docker build 将这些指令转化为镜像。

比如,我要更改 Ubuntu 镜像安装一个 Vim 编辑器,那么我的 Dockerfile 可以这样写:

FROM ubuntu

RUN apt-get install vim -y

其中,FROM 指令说明我们这个镜像需要继承 Ubuntu 镜像,RUN 指令是需要在镜像内运行的命令。

因为 Ubuntu 镜像内包含了 apt-get 包管理器,所以相当于启动了一个 Ubuntu 镜像的容器,然后在这个容器内部安装 Vim。这期间会产生一个新的 layer,这个新的 layer 包含安装 Vim 所需的所有文件。

运行 docker build 后会产生一个新镜像,我们可以通过 docker tag 给这个新镜像起一个名字,然后 docker push 到仓库,就可以从仓库下载这个镜像了,后续的其他镜像也可以继承这个镜像进行其他改动。

镜像就是这样通过 Dockerfile 一层一层的继承,不断增加新的内容,直到变成你想要的样子。

Dockerfile 的另外一个好处就是可以描述镜像的变化,通过一行命令就可以直观描述出环境变更的过程,如果再通过 git 进行版本控制,就可以让环境的管理更加可靠与简单。

了解了 Dockerfile 之后,你就可以利用它进行代码更新了,最主要的步骤就以下三步:

- 将代码包下载到构建服务器;

- 通过 Dockerfile 的 ADD 命令将代码包加载到容器里;

- Docker build 完成新的镜像。

镜像构建优化

原则上,我们总是希望能够让镜像保持小巧、精致,这样可以让镜像环境更加清晰,不用占用过多空间,下载也会更快。

那么,如何做好镜像的优化呢?你可以从 3 个方面入手:

- 选择合适的 Base 镜像;

- 减少不必要的镜像层的产生;

- 充分利用指令的缓存。

为什么第一条说要选择合适的 Base 镜像呢?因为,这是最直接和有效的方式。

举个例子就更好理解了。比如,我只想运行一个 Java 进程,那么镜像里就只有这个 Java 进程所需的环境就可以了,而没必要使用一个完整 Ubuntu 或者 CentOS 镜像。

关于第二点,减少不必要的镜像层,是因为使用 Dockerfile 时,每一条指令都会创建一个镜像层,继而会增加整体镜像的大小。

比如,下面这个 Dockerfile:

FROM ubuntu

RUN apt-get install vim -y

RUN apt-get remove vim -y

虽然这个操作创建的镜像中没有安装 Vim,但是镜像的大小和有 Vim 是一样的。原因就是,每条指令都会新加一个镜像层,执行 install vim 后添加了一层,执行 remove vim 后也会添加一层,而这一删除命令并不会减少整个镜像的大小。

因此,当我们编写 Dockerfile 时,可以合并多个 RUN 指令,减少不必要的镜像层的产生,并且在之后将多余的命令清理干净,只保留运行时需要的依赖。就好比我买了两斤橘子,只需要把橘子肉保留下来就好,橘子皮可以直接丢掉,不用保留在房间里。

Dockerfile 构建的另外一个重要特性是指令可以缓存,可以极大地缩短构建时间。 因为之前也说了,每一个 RUN 都会产生一个镜像,而 Docker 在默认构建时,会优先选择这些缓存的镜像,而非重新构建一层镜像。比如,一开始我的 Dockerfile 如下:

FROM ubuntu

RUN apt-get install vim -y

使用一段时间之后,我发现需要添加新的特性,Dockerfile 变成了如下的样子:

FROM ubuntu

RUN apt-get install vim -y

ADD java /usr/local/java

重新 build 时,前面安装 Vim 那步可以使用缓存,而不需要重新运行。当我们需要构建一个新镜像时,这个特性非常有用,可以快速跳过前面构建通过的步骤,而不需要每次都重新构建,尤其适用于在 Docker 里面编译一些大型软件的情况,可以帮你节省大量时间。

镜像构建环境

当我们学会了使用 Dockerfile 构建镜像之后,下一步就是如何搭建构建环境了。搭建构建环境最简单的方式就是在虚拟机上安装 Docker Daemon,然后根据你所使用的语言提供的 Docker 客户端与 Docker Daemon 进行交互,完成构建。

但是,我们推崇构建环境容器化,因为我们的构建环境可能除了 Docker 外,还会有一些其他的依赖,比如编程语言、Git 等等。

上面我也分析了 Docker 镜像的各种好处,那如果环境还没有实现容器化,是不是就有点说不过去了?

接下来,我们就看看构建环境如何实现容器化。一般情况下,用容器来构建容器镜像有两种方式:

- Docker Out Of Docker(DooD)

- Docker In Docker(DinD)

第一,Docker Out Of Docker(DooD)

这种方式比较简单,首先在虚拟机上安装 Docker Daemon,然后将你的构建环境镜像下载下来启动一个容器。

在默认情况下,Docker 客户端都是通过 /var/run/docker.sock 与 Docker Daemon 进行通信。我们在创建 Docker 实例时,把外部的 /var/run/docker.sock mount 到容器内部,这样容器内的 Docker 客户端就可以与外部的 Docker Daemon 进行通信了。

另外,你还需要注意权限问题,容器内部的构建进程必须拥有读取 /var/run/docker.sock 的权限,才可以完成通信过程。

这种方式的好处很明显,我们可以将镜像构建环境打包复用,对宿主机来说,只要安装 Docker Daemon 就可以了。但是这种方式的缺点是,内部的环境必须要与外部保持一致,不然就会报错,比如缺少库文件。此外,如果构建容器时不小心把 Docker Daemon 搞挂了,那么就会影响该宿主机上的其他容器。

为了解决这个问题,我们是否可以在容器内部使用 Docker Daemon 呢?

第二,Docker In Docker(DinD)

Docker In Docker ,就是在容器内部启动一个完整的 Docker Daemon 进程,然后构建工具只需要和该进程交互,而不影响外部的 Docker 进程。

默认情况下,容器内部不允许开启 Docker Daemon 进程,必须在运行容器的时候加上 –privileged 参数,这个参数的作用是真正取得 root 的权限。另外,Docker 社区官方提供了一个 docker:dind 镜像可以直接拿来使用。

这样一来,容器内部 Docker Daemon 就和容器外部的 Docker Daemon 彻底分开了,容器内部就是一个完整的镜像构建环境,是不是很神奇。

然而 DinD 也不是百分之百的完美和健壮,它也有一些关于安全和文件系统的问题。此外,因为每个容器都有独立的 /var/lib/docker 用来保存镜像文件,一旦容器被重启了,这些镜像缓存就消失了,这可能会影响我们构建镜像的性能。

通过以上两个方法,你就可以做到用容器来构建容器镜像了。

总结

今天,我针对容器镜像构建的那些事儿,和你进行了讨论。

首先,容器镜像是一个独立的文件系统,它包含了容器运行初始化时所需要的数据或软件。Docker 容器的文件系统是分层的、只读的,每次创建容器时只要在最上层添加一个叫作 Container layer 的可写层就可以了。这种创建方式不同于虚拟机,可以极大的减少对磁盘空间的占用。

其次,Docker 提供了 Dockerfile 这个可以描述镜像的文本格式的配置文件。你可以在 Dockerfile 中运行功能丰富的指令,并可以通过 docker build 将这些指令转化为镜像。

再次,基于 Dockerfile 的特性,我分享了 Dockerfile 镜像构建优化的三个建议,包括:选择合适的 Base 镜像、减少不必要的镜像层产生,以及善用构建缓存。

最后,用容器来构建容器镜像,主要有 DooD 和 DinD 两种方案。这两种方案,各有优劣,你可以根据自身情况去选择。

思考题

- 除了上述的 DooD 和 DinD 之外,你还知道哪些其他的 Docker 构建方案吗?它们分别有什么特点?

- Docker 构建的缓存机制的基本规则是怎样的,如果 ADD 或 COPY 命令后是不同的文件,缓存机制会怎么处理?

18 如何做好容器镜像的个性化及合规检查?

你好,我是王潇俊。我今天分享的主题是:如何做好容器镜像的个性化及合规检查。

你是否还记得我在第 13 讲篇文章《容器技术真的是环境管理的救星吗?》中说到:容器不是银弹,镜像发布无法很好地满足用户的个性化需求?

在携程的发布标准化中,容器内的环境也是由发布系统定义的,用户即使登录到容器上去做变更,下一次发布之后还是会被回滚回来。但是,对 Dockerfile 的编写和控制需要一定的学习成本,因此我们又不可能将镜像的内容与构建流程完全交给用户来自定义。

于是,就有了我今天的分享,即如何做好容器镜像的个性化及合规检查?根据我在持续交付道路上摸爬滚打的实践经验,总结了以下三种方法来满足用户对容器镜像个性化需求:

- 自定义环境脚本;

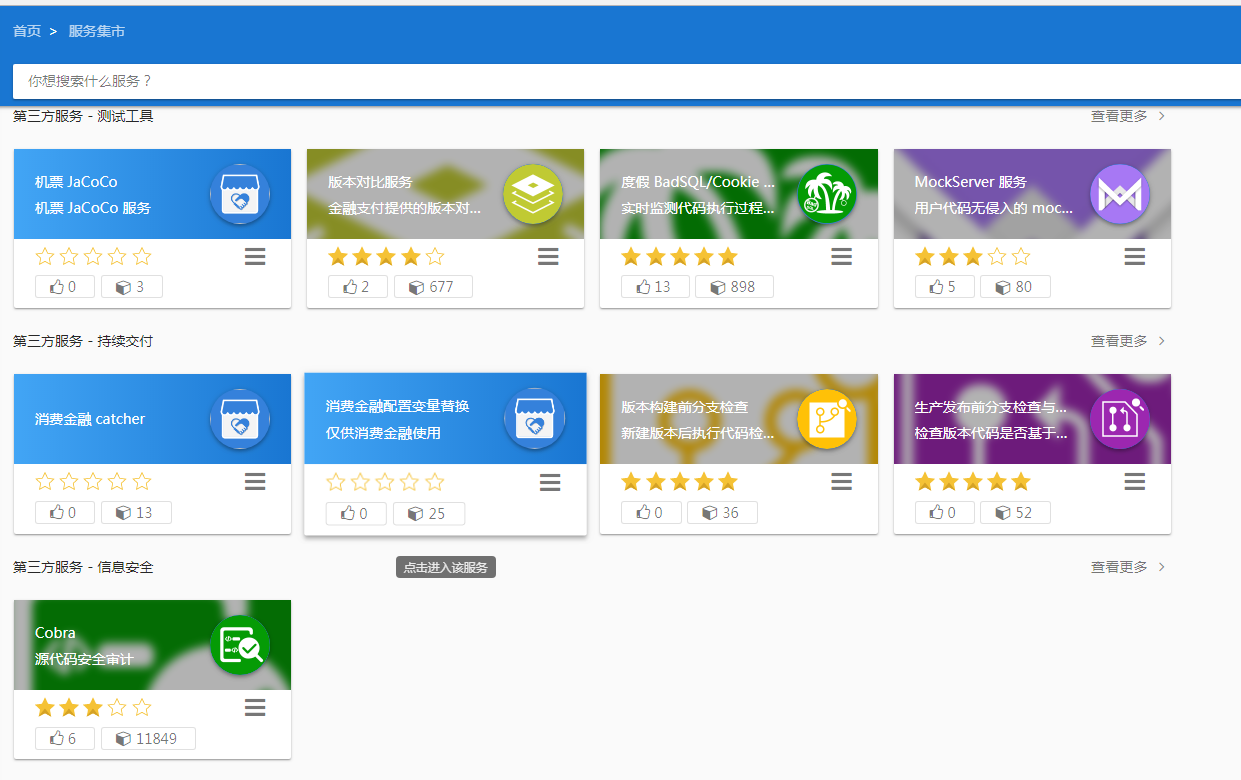

- 平台化环境选项与服务集市;

- 自定义镜像发布。

接下来的内容,我将根据这三种方法展开,并将介绍如何通过合规检查来规避个性化带来的风险。

用户自定义环境脚本

我们允许用户在编译后的代码包内放入包含自定义环境脚本的 .paas 目录(这是一个自定义的隐藏目录),来满足用户对环境的个性化需求。